Em 1939, Einstein escreveu a Roosevelt:1

Pode ser possível estabelecer uma reação nuclear em cadeia em uma grande massa de urânio… e é concebível – embora muito menos certo – que bombas extremamente poderosas de um novo tipo possam ser construídas.

Apenas alguns anos depois, essas bombas foram criadas. Em pouco mais de uma década, foi produzido o suficiente para que, pela primeira vez na história, um punhado de tomadores de decisão pudesse destruir a civilização.

A humanidade havia entrado em uma nova era, na qual enfrentamos não apenas riscos existenciais2 de nosso ambiente natural, mas também a possibilidade de podermos nos extinguir.

Nesta nova era, qual deve ser nossa maior prioridade como civilização? Melhorar a tecnologia? Ajudar os pobres? Mudar o sistema político?

Aqui está uma sugestão que não é discutida com tanta frequência: nossa primeira prioridade deve ser sobreviver.

Enquanto a civilização continuar a existir, teremos a chance de resolver todos os nossos outros problemas e ter um futuro muito melhor. Mas se formos extintos, é isso.

Por que essa prioridade não é mais discutida? Aqui está uma razão: muitas pessoas ainda não apreciam a mudança de situação e, portanto, não acham que nosso futuro está em risco.

O pesquisador de ciências sociais Spencer Greenberg pesquisou os americanos sobre sua estimativa das chances de extinção humana dentro de 50 anos. Os resultados descobriram que muitos acham que as chances são extremamente baixas, com mais de 30% adivinhando que estão abaixo de 1 em 10 milhões.3

Costumávamos pensar que os riscos eram extremamente baixos também, mas quando analisamos, mudamos de ideia. Como veremos, os pesquisadores que estudam essas questões acham que os riscos são mais de 1.000 vezes maiores e provavelmente estão aumentando.

Essas preocupações deram início a um novo movimento que trabalha para salvaguardar a civilização, ao qual se juntou Stephen Hawking, Max Tegmark e novos institutos fundados por pesquisadores de Cambridge, MIT, Oxford e outros lugares.

No restante deste artigo, abordamos os maiores riscos para a civilização, incluindo alguns que podem ser maiores do que a guerra nuclear e as mudanças climáticas. Em seguida, argumentamos que reduzir esses riscos pode ser a coisa mais importante que você faz em sua vida e explicamos exatamente o que você pode fazer para ajudar. Se você quiser usar sua carreira para trabalhar nessas questões, também podemos oferecer suporte individual.

Tempo de leitura: 25 minutos

===

(Uma rápida pausa para uma sugestão)

Prefere ouvir o que discutiremos agora em um podcast (em inglês)? Desde a publicação deste artigo, gravamos dois episódios de podcast com o Dr. Toby Ord, filósofo de Oxford e administrador do 80.000 Hours, sobre ameaças existenciais. Achamos que eles são pelo menos tão boas introduções quanto este artigo – talvez melhores. Ouça-os aqui:

- Toby Ord – O precipício e os futuros potenciais da humanidade

- Por que o futuro a longo prazo da humanidade importa mais do que qualquer outra coisa e o que devemos fazer a respeito

Ou leia o livro: O Dr. Toby Ord, filósofo de Oxford e administrador do 80.000 Hours, publicou recentemente The Precipice: Existential Risk and the Future of Humanity, que dá uma visão geral da importância moral das gerações futuras e o que podemos fazer para ajudá-las hoje.

Você também pode ler a resenha escrita pelo Altruísmo Eficaz Brasil sobre o livro de Toby Ord – O Precipício: uma resenha arriscada.

====

Qual a probabilidade de você ser morto por um asteroide? Uma visão geral das ameaças existenciais que ocorrem naturalmente

A chance de extinção de 1 em 10 milhões nos próximos 50 anos – o que muitas pessoas pensam que é o risco – deve ser subestimada. As ameaças existenciais que ocorrem naturalmente podem ser estimadas com bastante precisão a partir da história e são muito maiores.

Se a Terra fosse atingida por um asteroide de um quilômetro de largura, há uma chance de que a civilização fosse destruída. Observando o registro histórico e rastreando os objetos no céu, os astrônomos podem estimar o risco de um asteroide desse tamanho atingir a Terra em cerca de 1 em 5.000 por século.4 Isso é maior do que as chances da maioria das pessoas de sofrer um acidente de avião (cerca de 1 em 5 milhões por voo), e cerca de 1.000 vezes maior do que o risco de 1 em 10 milhões que algumas pessoas estimaram.5

Alguns argumentam que, embora um objeto do tamanho de um quilômetro fosse um desastre, não seria suficiente para causar a extinção, então essa é uma estimativa alta do risco. Mas, por outro lado, existem outros riscos naturais, como os supervulcões.6

Dito isso, os riscos naturais ainda são muito pequenos em termos absolutos. Um artigo do Dr. Toby Ord estimou que, se somarmos todos os riscos naturais juntos, é muito improvável que eles somem mais de uma chance em 300 de extinção por século.7

Infelizmente, como mostraremos agora, os riscos naturais são ofuscados pelos causados pelo homem. E é por isso que o risco de extinção se tornou uma questão especialmente urgente.

Uma história de progresso, levando ao início da época mais perigosa da história humana

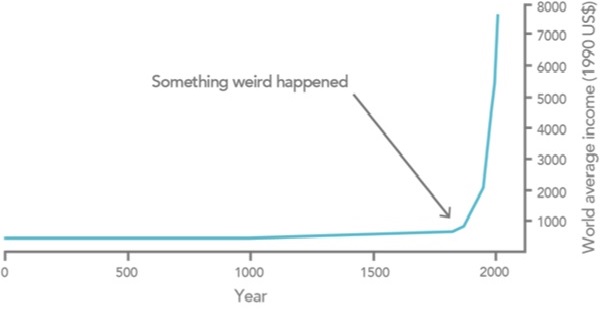

Se você olhar para a história ao longo de milênios, a mensagem básica é que por muito tempo quase todo mundo era pobre, e então, no século 18, isso mudou.8

Isso foi causado pela Revolução Industrial – talvez o evento mais importante da história.

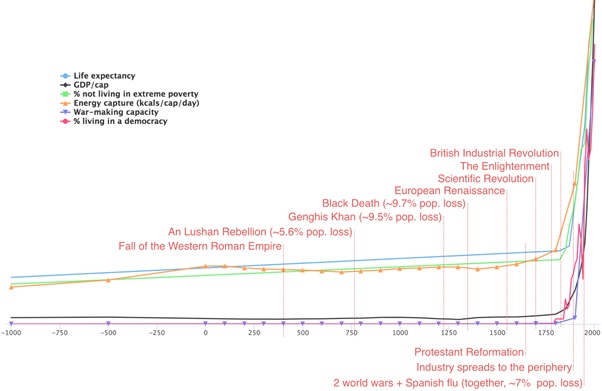

Não foi apenas a riqueza que cresceu. O gráfico a seguir mostra que, a longo prazo, a expectativa de vida, o uso de energia e a democracia cresceram rapidamente, enquanto a porcentagem que vive na pobreza diminuiu drasticamente.9

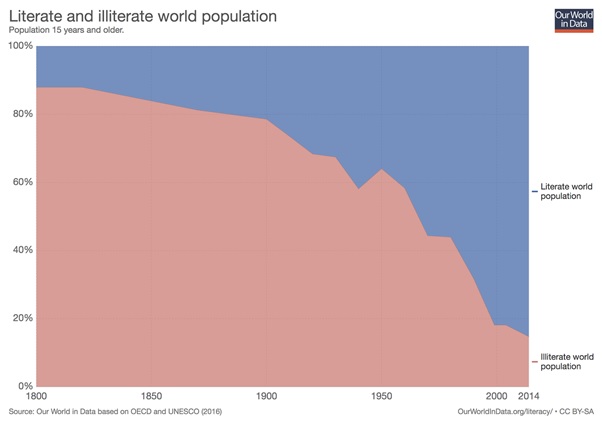

Os níveis de alfabetização e educação também aumentaram dramaticamente:

As pessoas também parecem ficar mais felizes à medida que ficam mais ricas.

Em The Better Angels of Our Nature, Steven Pinker argumenta que a violência está diminuindo. (Embora nosso recente podcast com Bear Braumoeller – lançado após a publicação deste artigo – veja algumas razões pelas quais isso pode não ser bem o caso.)

A liberdade individual aumentou, enquanto o racismo, o sexismo e a homofobia diminuíram.

Muitas pessoas pensam que o mundo está piorando,10 e é verdade que a civilização moderna faz coisas terríveis, como a pecuária industrial. Mas, como você pode ver nos dados, muitas medidas importantes de progresso melhoraram drasticamente.

Mais ao ponto, não importa o que você acha que aconteceu no passado, se olharmos para frente, melhorar a tecnologia, a organização política e a liberdade dá aos nossos descendentes o potencial para resolver nossos problemas atuais e ter vidas muito melhores.11 É possível acabar com a pobreza, prevenir as mudanças climáticas, aliviar o sofrimento e muito mais.

Mas observe também a linha roxa no segundo gráfico: a capacidade de fazer guerra. É baseado em estimativas do poder militar global do historiador Ian Morris, e também aumentou dramaticamente.

Aqui está a questão: melhorar a tecnologia traz a possibilidade de enormes ganhos, mas também enormes riscos.

Cada vez que descobrimos uma nova tecnologia, na maioria das vezes ela traz enormes benefícios. Mas também há uma chance de descobrirmos uma tecnologia com mais poder destrutivo do que temos a capacidade de usar com sabedoria.

E assim, embora a geração atual viva no período mais próspero da história humana, é plausivelmente também o mais perigoso.

A primeira tecnologia destrutiva desse tipo foram as armas nucleares.

Armas nucleares: uma história de quase acidentes

Hoje todos nós temos o programa nuclear da Coreia do Norte em mente, mas os eventos atuais são apenas um capítulo de uma longa saga de quase acidentes.

Chegamos perto de uma guerra nuclear várias vezes durante a crise dos mísseis cubanos.12 Em um incidente, os americanos resolveram que, se um de seus aviões espiões fosse abatido, eles invadiriam imediatamente Cuba sem uma nova reunião do Conselho de Guerra. No dia seguinte, um avião espião foi abatido. JFK convocou o conselho de qualquer maneira e decidiu não invadir.

Uma invasão de Cuba poderia muito bem ter desencadeado uma guerra nuclear; mais tarde surgiu a informação de que Castro era a favor da retaliação nuclear, mesmo que “isso levasse à aniquilação completa de Cuba”. Alguns dos comandantes de Cuba também tinham autoridade independente para atacar as forças americanas com armas nucleares táticas no caso de uma invasão.

Em outro incidente, um submarino nuclear russo tentava contrabandear materiais para Cuba quando foram descobertos pela frota americana. A frota começou a lançar cargas de profundidade fictícias para forçar o submarino à superfície. O capitão russo pensou que eram cargas de profundidade reais e que, enquanto fora da comunicação por rádio, a terceira guerra mundial havia começado. Ele ordenou um ataque nuclear à frota americana com um de seus torpedos nucleares.

Felizmente, ele precisava da aprovação de outros oficiais superiores. Um, Vasili Arkhipov, discordou, prevenindo a guerra.

Juntando todos esses eventos, JFK mais tarde estimou que as chances de uma guerra nuclear eram “entre em três ou até mesmo uma em dois”.13

Houve muitos outros quase eventos nucleares com a Rússia, mesmo após a Guerra Fria, conforme listado nesta bela página da Wikipedia. E esses são apenas os que conhecemos.

Atualmente, os especialistas em guerra nuclear estão tão preocupados com as tensões entre a Índia e o Paquistão, que possuem armas nucleares, quanto com a Coreia do Norte.14

O principal problema é que vários países mantêm grandes arsenais nucleares que estão prontos para serem implantados em minutos. Isso significa que um alarme falso ou acidente pode rapidamente se transformar em uma guerra nuclear completa, especialmente em tempos de relações externas tensas.

Uma guerra nuclear acabaria com a civilização? Inicialmente, pensava-se que uma explosão nuclear poderia ser tão quente que inflamaria a atmosfera e tornaria a Terra inabitável. Os cientistas estimaram que isso era suficientemente improvável para que as armas pudessem ser testadas “com segurança”, e agora sabemos que isso não acontecerá.

Na década de 1980, a preocupação era que as cinzas de prédios em chamas mergulhassem a Terra em um inverno de longo prazo que impossibilitaria o cultivo por décadas.15 Modelos climáticos modernos sugerem que um inverno nuclear suficientemente severo para matar todos é muito improvável, embora seja difícil ter certeza devido à incerteza do modelo.16

Mesmo um inverno nuclear “suave”, no entanto, ainda pode causar fome em massa.17 Por esta e outras razões, uma guerra nuclear seria extremamente desestabilizadora, e não está claro se a civilização poderia se recuperar.

Qual é a probabilidade de uma guerra nuclear acabar permanentemente com a civilização humana? É muito difícil estimar, mas parece difícil concluir que a chance de uma guerra nuclear que acabe com a civilização no próximo século não seja superior a 0,3%. Isso significaria que os riscos das armas nucleares são maiores do que todos os riscos naturais juntos. (Leia mais sobre riscos nucleares).

É por isso que a década de 1950 marcou o início de uma nova era para a humanidade. Pela primeira vez na história, tornou-se possível para um pequeno número de tomadores de decisão causar estragos em todo o mundo. Nós agora representamos a maior ameaça à nossa própria sobrevivência – isso faz de hoje o ponto mais perigoso da história humana.

E as armas nucleares não são a única maneira de acabar com a civilização.

Quão grande é o risco representado pelas mudanças climáticas?

Em 2015, o presidente Obama disse em seu discurso sobre o Estado da União que “nenhum desafio representa uma ameaça maior para as gerações futuras do que as mudanças climáticas”.

A mudança climática é certamente um grande risco para a civilização.

O resultado mais provável é de 2 a 4 graus de aquecimento,18 o que seria ruim, mas passível de sobrevivência para nossa espécie.

No entanto, algumas estimativas dão 10% de chance de aquecimento acima de 6 graus e talvez 1% de chance de aquecimento de 9 graus.

Então, parece que a chance de um grande desastre climático criado pelo CO2 é talvez semelhante à chance de uma guerra nuclear.

Mas, como argumentamos em nosso perfil de problemas sobre mudanças climáticas, parece improvável que mesmo 13 graus de aquecimento causem diretamente a extinção da humanidade. Como resultado, os pesquisadores que estudam essas questões acham que a guerra nuclear parece mais provável de resultar em extinção total, devido à possibilidade de inverno nuclear, e é por isso que achamos que as armas nucleares representam um risco ainda maior do que as mudanças climáticas.

Dito isto, a mudança climática é certamente um grande problema, e seus efeitos desestabilizadores podem exacerbar outros riscos (incluindo riscos de conflito nuclear). Isso deve aumentar ainda mais nossa estimativa dos riscos.

Que novas tecnologias podem ser tão perigosas quanto as armas nucleares?

A invenção das armas nucleares levou ao movimento antinuclear apenas algumas décadas depois, na década de 1960, e o movimento ambientalista logo adotou a causa do combate às mudanças climáticas.

O que é menos apreciado é que as novas tecnologias apresentarão mais riscos catastróficos. É por isso que precisamos de um movimento que se preocupe em salvaguardar a civilização em geral.

Prever o futuro da tecnologia é difícil, mas como só temos uma civilização, precisamos dar o nosso melhor. Aqui estão alguns candidatos para a próxima tecnologia que é tão perigosa quanto as armas nucleares.

Pandemias projetadas

Em 1918-1919, mais de 3% da população mundial morreu de gripe espanhola.19 Se tal pandemia surgisse hoje, poderia ser ainda mais difícil de conter devido ao rápido transporte global.

O que é mais preocupante, porém, é que em breve poderá ser possível projetar geneticamente um vírus tão contagioso quanto a gripe espanhola, mas também mais mortal, e que pode se espalhar por anos sem ser detectado.

Essa seria uma arma com o poder destrutivo das armas nucleares, mas muito mais difícil de impedir de ser usada. As armas nucleares exigem fábricas enormes e materiais raros para serem fabricadas, o que as torna relativamente fáceis de controlar. Vírus desenhados podem ser criados em um laboratório com algumas pessoas com doutorado em biologia. De fato, em 2006, o The Guardian conseguiu receber segmentos do extinto vírus da varíola por correspondência.20 Alguns grupos terroristas manifestaram interesse em usar armas indiscriminadas como essas. (Leia mais sobre riscos pandêmicos).

Inteligência artificial

Outra nova tecnologia com enorme poder potencial é a inteligência artificial.

A razão pela qual os humanos estão no comando e não os chimpanzés é puramente uma questão de inteligência. Nossos cérebros grandes e poderosos nos dão um controle incrível do mundo, apesar do fato de sermos muito mais fracos fisicamente do que os chimpanzés.

Então, o que aconteceria se um dia criássemos algo muito mais inteligente do que nós mesmos?

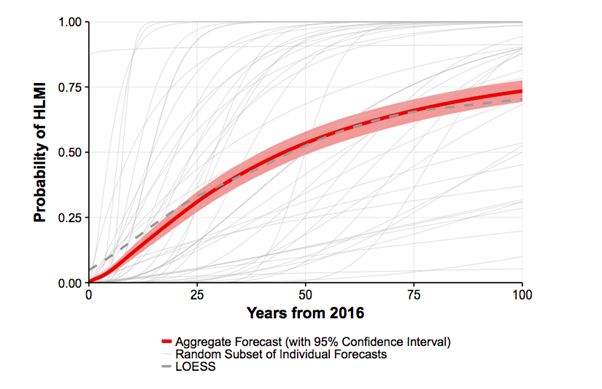

Em 2017, foi perguntado a 350 pesquisadores que publicaram pesquisas revisadas por pares sobre inteligência artificial foram questionados sobre quando acreditam que desenvolveremos computadores com inteligência em nível humano: ou seja, uma máquina capaz de realizar melhor todas as tarefas de trabalho do que humanos.

A estimativa mediana era de que há 50% de chance de desenvolvermos inteligência de máquina de alto nível em 45 anos e 75% até o final do século.21

Essas probabilidades são difíceis de estimar, e os pesquisadores deram números muito diferentes dependendo de como você faz a pergunta.22 No entanto, parece haver pelo menos uma chance razoável de que algum tipo de inteligência de máquina transformadora seja inventada no próximo século. Além disso, maior incerteza significa que pode vir mais cedo do que as pessoas pensam, e não mais tarde.

Que riscos esse desenvolvimento pode representar? Os pioneiros originais da computação, como Alan Turing e Marvin Minsky, levantaram preocupações sobre os riscos de sistemas de computador poderosos,23 e esses riscos ainda existem hoje. Não estamos falando de computadores “tornando-se malvados”. Em vez disso, uma preocupação é que um poderoso sistema de IA possa ser usado por um grupo para obter o controle global ou que seja mal utilizado de outro modo. Se a URSS tivesse desenvolvido armas nucleares 10 anos antes dos EUA, a URSS poderia ter se tornado a potência global dominante. A poderosa tecnologia de computador pode apresentar riscos semelhantes.

Outra preocupação é que a implantação do sistema pode ter consequências não intencionais, pois seria difícil prever o que algo mais inteligente do que nós faria. Um sistema suficientemente poderoso também pode ser difícil de controlar e, portanto, difícil de reverter uma vez implementado. Essas preocupações foram documentadas pelo professor de Oxford Nick Bostrom em Superinteligência e pelo pioneiro da IA Stuart Russell.

A maioria dos especialistas acha que uma IA melhor será um desenvolvimento extremamente positivo, mas também concordam que há riscos. Na pesquisa que acabamos de mencionar, especialistas em IA estimaram que o desenvolvimento de inteligência de máquina de alto nível tem 10% de chance de um “resultado ruim” e 5% de chance de um resultado “extremamente ruim”, como a extinção humana.21 E provavelmente devemos esperar que esse grupo seja positivamente tendencioso, pois, afinal, eles vivem da tecnologia.

Juntando as estimativas, se houver 75% de chance de que a inteligência de máquina de alto nível seja desenvolvida no próximo século, isso significa que a chance de um grande desastre de IA é de 5% de 75%, o que é cerca de 4%. (Leia mais sobre os riscos da inteligência artificial).

Outros riscos das tecnologias emergentes

As pessoas levantaram preocupações sobre outras novas tecnologias, como outras formas de geoengenharia e fabricação atômica, mas elas parecem significativamente menos iminentes, por isso são amplamente vistas como menos perigosas do que as outras tecnologias que abordamos. Você pode ver uma lista mais longa de riscos existenciais aqui.

O que provavelmente é mais preocupante são os riscos nos quais ainda não pensamos. Se você tivesse perguntado às pessoas em 1900 quais eram os maiores riscos para a civilização, eles provavelmente não teriam sugerido armas nucleares, engenharia genética ou inteligência artificial, já que nada disso foi inventado. É possível que estejamos na mesma situação olhando para o próximo século. Futuras “incógnitas desconhecidas” podem representar um risco maior do que os riscos que conhecemos hoje.

Cada vez que descobrimos uma nova tecnologia, é como apostar contra um único número em uma roleta. Na maioria das vezes nós vencemos, e a tecnologia é boa no geral. Mas cada vez há também uma pequena chance de que a tecnologia nos dê mais poder destrutivo do que podemos lidar, e perdemos tudo.

Qual é o risco total de extinção humana se somarmos tudo?

Muitos especialistas que estudam essas questões estimam que a chance total de extinção humana no próximo século está entre 1 e 20%.

Em nosso episódio de podcast com Will MacAskill, discutimos por que ele coloca o risco de extinção neste século em cerca de 1%.

E em seu livro de 2020 The Precipice: Existential Risk and the Future of Humanity, Toby Ord dá seu palpite sobre nosso risco existencial total neste século como 1 em 6 (ou cerca de 17%) – um lançamento de dados. (Observe, porém, que a definição de Ord de uma catástrofe existencial não é exatamente equivalente à extinção humana; incluiria, por exemplo, uma catástrofe global que deixa a espécie incapaz de se recuperar verdadeiramente, mesmo que alguns humanos ainda estejam vivos.) Ouça nosso episódio com Toby.

Seu livro fornece a seguinte tabela apresentando suas estimativas (muito grosseiras) de risco existencial do que ele acredita serem as principais ameaças:

| Catástrofe existencial via | Chance nos próximos 100 anos |

|---|---|

| Impacto de asteróide ou cometa | ~ 1 em 1.000.000 |

| Erupção de um supervulcâo | ~ 1 em 10.000 |

| Explosão estelar | ~ 1 em 1.000.000.000 |

| Risco natural total | ~ 1 em 10.000 |

| Guerra nuclear | ~ 1 em 1.000 |

| Das Alterações Climáticas | ~ 1 em 1.000 |

| Outros danos ambientais | ~ 1 em 1.000 |

| Pandemias que surgem ‘naturalmente’ | ~ 1 em 10.000 |

| Pandemias projetadas | ~ 1 em 30 |

| Inteligência artificial desalinhada | ~ 1 em 10 |

| Riscos antropogênicos imprevistos | ~ 1 em 30 |

| Outros riscos antropogênicos | ~ 1 em 50 |

| Risco antropogênico total | ~ 1 em 6 |

| Risco existencial total | ~ 1 em 6 |

Esses números são cerca de um milhão de vezes maiores do que as pessoas normalmente pensam.

O que devemos fazer com essas estimativas? Presumivelmente, pesquisadores interessados neste tópico só trabalham nessas questões porque pensam que elas são muito importantes, então devemos esperar que suas estimativas sejam altas (devido ao viés de seleção). Embora os números estejam em debate, acreditamos que uma variedade de pontos de vista, incluindo os de MacAskill e Ord, é plausível.

Por que ajudar a proteger o futuro pode ser a coisa mais importante que você pode fazer com sua vida

Quanto devemos priorizar o trabalho para reduzir esses riscos em comparação com outras questões, como pobreza global, erradicação do câncer ou mudanças políticas?

Na 80.000 Horas, fazemos pesquisas para ajudar as pessoas a encontrarem carreiras com impacto social positivo. Como parte disso, tentamos encontrar os problemas mais urgentes do mundo para se trabalhar. Avaliamos diferentes problemas globais usando nossa estrutura de problemas, que compara problemas em termos de:

- Escala — quantos são afetados pelo problema

- Negligência – quantas pessoas já estão trabalhando nisso

- Solvabilidade – como é fácil progredir

Se você aplicar essa estrutura, achamos que proteger o futuro se torna a maior prioridade do mundo. E assim, se você deseja ter um grande impacto positivo em sua carreira, esta é a principal área para se concentrar.

Nas próximas seções, avaliaremos essa questão em escala(Impacto), negligência e tratabilidade, baseando-nos fortemente na Prevenção de Risco Existencial como Prioridade Global de Nick Bostrom e no trabalho inédito de Toby Ord, bem como em nossa própria pesquisa.

Primeiro, vamos começar com a escala do problema. Argumentamos que provavelmente há mais de 3% de chance de extinção no próximo século. Quão grande é esse problema?

Um número que podemos ver é quantas pessoas podem morrer em tal catástrofe. A população da Terra em meados do século será de cerca de 10 bilhões, então uma chance de 3% de todos morrerem significa que o número esperado de mortes é de cerca de 300 milhões. Isso é provavelmente mais mortes do que podemos esperar no próximo século devido às doenças da pobreza, como a malária.24

Muitos dos riscos que cobrimos também podem causar uma catástrofe “média” em vez de uma que acabe com a civilização, e isso é presumivelmente muito mais provável. A pesquisa que cobrimos anteriormente sugeria mais de 10% de chance de uma catástrofe que mataria mais de 1 bilhão de pessoas no próximo século, o que seria pelo menos mais 100 milhões de mortes esperadas, juntamente com muito mais sofrimento entre aqueles que sobreviverem.

Portanto, mesmo que nos concentremos apenas no impacto na geração atual, esses riscos catastróficos são um dos problemas mais sérios que a humanidade enfrenta.

Mas isso é uma enorme subestimação da escala do problema, porque se a civilização acabar, também desistiremos de todo o nosso futuro.

A maioria das pessoas quer deixar um mundo melhor para seus netos, e a maioria também acha que devemos ter alguma preocupação com as gerações futuras de forma mais ampla. Pode haver muito mais pessoas com vidas excelentes no futuro do que pessoas vivas hoje, e devemos ter alguma preocupação com seus interesses. Existe a possibilidade de que a civilização humana possa durar milhões de anos, então, quando consideramos o impacto dos riscos nas gerações futuras, as apostas são milhões de vezes maiores – para o bem ou para o mal. Como Carl Sagan escreveu sobre os custos da guerra nuclear na revista Foreign Affairs:

Uma guerra nuclear põe em perigo todos os nossos descendentes, enquanto houver humanos. Mesmo que a população permaneça estática, com uma vida média da ordem de 100 anos, em um período de tempo típico para a evolução biológica de uma espécie bem-sucedida (aproximadamente 10 milhões de anos), estamos falando de cerca de 500 trilhões de pessoas ainda por vir. Por esse critério, as apostas são um milhão de vezes maiores para a extinção do que para as guerras nucleares mais modestas que matam “apenas” centenas de milhões de pessoas. Existem muitas outras medidas possíveis da perda potencial – incluindo cultura e ciência, a história evolutiva do planeta e o significado da vida de todos os nossos ancestrais que contribuíram para o futuro de seus descendentes. A extinção é a ruína do empreendimento humano.

Estamos felizes que os romanos não deixaram a humanidade extinta, pois isso significa que toda a civilização moderna conseguiu existir. Achamos que devemos uma responsabilidade semelhante às pessoas que virão depois de nós, supondo (como acreditamos) que elas provavelmente levarão vidas satisfatórias. Seria imprudente e injusto pôr em perigo a sua existência apenas para melhorar a nossa situação a curto prazo.

Não é apenas que pode haver mais pessoas no futuro. Como Sagan também apontou, não importa o que você acha que tem valor, potencialmente há muito mais disso no futuro. A civilização futura poderia criar um mundo sem necessidade ou desejo, e fazer realizações intelectuais e artísticas alucinantes. Poderíamos construir uma sociedade muito mais justa e virtuosa. E não há nenhuma razão em princípio para que a civilização não possa alcançar outros planetas, dos quais existem cerca de 100 bilhões em nossa galáxia.25 Se deixarmos a civilização acabar, nada disso poderá acontecer.

Não temos certeza se esse grande futuro realmente acontecerá, mas isso é mais uma razão para manter a civilização em andamento, para que tenhamos a chance de descobrir. Deixar de passar a tocha para a próxima geração pode ser a pior coisa que poderíamos fazer.

Assim, alguns por cento de risco de que a civilização acabe parece ser o maior problema que o mundo enfrenta hoje. O que também chama a atenção é como esses riscos são negligenciados.

Por que esses riscos são alguns dos problemas globais mais negligenciados

Aqui está quanto dinheiro por ano vai para algumas causas importantes:26

| Causa | Gastos anuais direcionados de todas as fontes (altamente aproximados) |

|---|---|

| Pesquisa e Desenvolvimento Global | US$ 1,5 trilhão |

| Produtos de luxo | US$ 1,3 trilhão |

| bem-estar social dos EUA | US$ 900 bilhões |

| Alterações Climáticas | >$300 bilhões |

| Para os pobres globais | >$250 bilhões |

| Segurança nuclear | US$ 1-10 bilhões |

| Prevenção de pandemias extremas | US$ 1 bilhão |

| Pesquisa de segurança de IA | US$ 10 milhões |

Como você pode ver, gastamos uma grande quantidade de recursos em P&D para desenvolver uma tecnologia ainda mais poderosa. Também gastamos muito em uma tentativa (possivelmente equivocada) de melhorar nossas vidas comprando bens de luxo.

Muito menos é gasto na mitigação de riscos catastróficos das mudanças climáticas. Os gastos com assistência social somente nos EUA superam os gastos globais com as mudanças climáticas.

Mas a mudança climática ainda recebe enormes quantias de dinheiro em comparação com alguns desses outros riscos que cobrimos. Estimamos aproximadamente que a prevenção de pandemias globais extremas receba menos de 300 vezes menos, embora o tamanho do risco pareça o mesmo.

A pesquisa para evitar acidentes de sistemas de IA é a mais negligenciada de todas, talvez recebendo 100 vezes menos recursos novamente, em torno de apenas US$ 10 milhões por ano.

Você encontraria uma imagem semelhante se analisasse o número de pessoas trabalhando nesses riscos em vez do dinheiro gasto, mas é mais fácil obter números para o dinheiro.

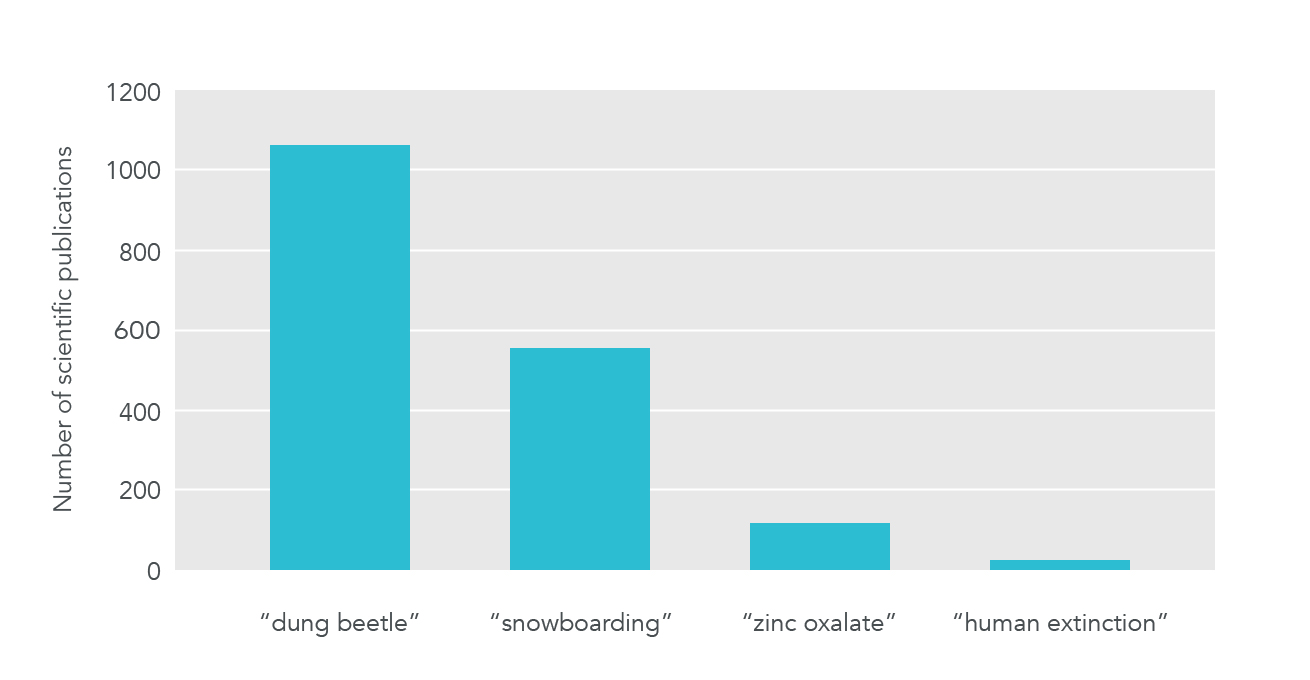

Se olharmos para a atenção científica, veremos um quadro semelhante de negligência (embora alguns dos riscos individuais recebam atenção significativa, como as mudanças climáticas):

Nossa impressão é que, se você olhar para a atenção política sendo dada a esses problemas, encontrará um quadro semelhante ao que apontamos em relação ao financiamento dos problemas. Uma quantidade esmagadora de atenção política vai para questões concretas que ajudam a geração atual no curto prazo, já que é isso que ganha votos. Os riscos catastróficos são muito mais negligenciados. E, entre os riscos catastróficos, as mudanças climáticas recebem mais atenção, enquanto questões como pandemias e IA são as mais negligenciadas.

Essa negligência em recursos, estudos científicos e atenção política é exatamente o que você esperaria que acontecesse a partir da economia subjacente, e é por isso que a área apresenta uma oportunidade para pessoas que desejam tornar o mundo um lugar melhor.

Primeiro, esses riscos não são responsabilidade de nenhuma nação. Suponha que os EUA investissem pesadamente para evitar as mudanças climáticas. Isso beneficia a todos no mundo, mas apenas cerca de 5% da população mundial vive nos EUA, de modo que os cidadãos americanos receberiam apenas 5% dos benefícios desses gastos. Isso significa que os EUA vão investir muito menos nesses esforços em comparação com o quanto eles valem para o mundo. E o mesmo acontece com todos os outros países.

Isso poderia ser resolvido se todos pudéssemos coordenar – se todas as nações concordassem em contribuir com sua parte justa para reduzir as mudanças climáticas, todas as nações se beneficiariam evitando seus piores efeitos.

Infelizmente, do ponto de vista de cada nação, é melhor que todos os outros países reduzam suas emissões, deixando sua própria economia desimpedida. Portanto, há um incentivo para que cada nação desista dos acordos climáticos, e é por isso que tão pouco progresso é feito (é o dilema do prisioneiro).

E, de fato, isso subestima dramaticamente o problema. Os maiores beneficiários dos esforços para reduzir os riscos catastróficos são as gerações futuras. Eles não têm como defender seus interesses, seja econômica ou politicamente.

Se as gerações futuras pudessem votar em nossas eleições, votariam esmagadoramente a favor de políticas mais seguras. Da mesma forma, se as gerações futuras pudessem enviar dinheiro de volta no tempo, estariam dispostas a nos pagar enormes quantias de dinheiro para reduzir esses riscos. (Tecnicamente, reduzir esses riscos cria um bem público global e transgeracional, que deve torná-los uma das maneiras mais negligenciadas de fazer o bem.)

Nosso sistema atual faz um trabalho ruim em proteger as gerações futuras. Conhecemos pessoas que falaram com altos funcionários do governo no Reino Unido e muitos querem fazer algo sobre esses riscos, mas dizem que as pressões das notícias e do ciclo eleitoral dificultam o foco neles. Na maioria dos países, não há nenhuma agência governamental que naturalmente tenha a mitigação desses riscos em suas atribuições.

Esta é uma situação deprimente, mas também é uma oportunidade. Para as pessoas que querem tornar o mundo um lugar melhor, essa falta de atenção significa que existem muitas maneiras de ajudar de alto impacto.

O que pode ser feito sobre esses riscos?

Cobrimos a escala e a negligência dessas questões, mas e o terceiro elemento de nossa estrutura, a tratabilidade?

É menos certo que possamos progredir nessas questões do que em áreas mais convencionais, como a saúde global. É muito mais fácil medir nosso impacto na saúde (pelo menos no curto prazo) e temos décadas de evidências sobre o que funciona. Isso significa que trabalhar para reduzir riscos catastróficos parece pior em termos de tratabilidade.

No entanto, ainda há muito que podemos fazer e, dada a enorme escala e negligência desses riscos, eles ainda parecem ser as questões mais urgentes.

Vamos esboçar algumas maneiras de reduzir esses riscos, divididos em três grandes categorias:

1. Esforços direcionados para reduzir riscos específicos

Uma abordagem possível é enfrentar cada risco diretamente. Há muitas propostas concretas para lidar com cada um, como as seguintes:

- Muitos especialistas concordam que uma melhor vigilância de doenças reduziria o risco de pandemias. Isso pode envolver tecnologia aprimorada ou melhor coleta e agregação de dados existentes, para nos ajudar a identificar novas pandemias mais rapidamente. E quanto mais rápido você identificar uma nova pandemia, mais fácil será gerencia-la.

- Há muitas maneiras de reduzir as mudanças climáticas, como ajudar a desenvolver melhores painéis solares ou introduzir um imposto sobre o carbono.

- Com a IA, podemos fazer pesquisas sobre o “problema de controle” na ciência da computação, para reduzir a chance de danos não intencionais de poderosos sistemas de IA. Um artigo recente, Problemas concretos na segurança da IA, descreve alguns tópicos específicos, mas apenas cerca de 20 pessoas trabalham em tempo integral em pesquisas semelhantes hoje.

- Em segurança nuclear, muitos especialistas pensam que os benefícios de dissuasão das armas nucleares poderiam ser mantidos com estoques muito menores. Mas, estoques menores também reduziriam os riscos de acidentes, bem como a chance de que uma guerra nuclear, se ocorresse, acabasse com a civilização.

Aprofundamos o que você pode fazer para enfrentar cada risco em nossos perfis de problemas:

Não nos concentramos em riscos causados pela natureza nesta seção porque eles são muito menos prováveis e já estamos fazendo muito para lidar com alguns deles. O aprimoramento em riqueza e tecnologia nos tornam mais resilientes aos riscos naturais, e um grande esforço já é feito em se obter mais riqueza e tecnologia.

2. Amplos esforços para reduzir riscos

Em vez de tentar reduzir cada risco individualmente, podemos tentar tornar a civilização melhor em gerenciá-los como um todo. Os esforços “amplos” ajudam a reduzir todas as ameaças de uma vez, mesmo aquelas em que ainda não pensamos.

Por exemplo, existem tomadores de decisão importantes, muitas vezes no governo, que precisarão gerenciar esses riscos à medida que surgirem. Se pudéssemos melhorar a capacidade de tomada de decisão dessas pessoas e instituições, isso ajudaria a tornar a sociedade em geral mais resiliente e a resolver muitos outros problemas.

Pesquisas recentes descobriram muitas maneiras de melhorar a tomada de decisões, mas a maioria ainda não foi implementada. Ao mesmo tempo, poucas pessoas estão trabalhando no assunto. Aprofundamos em nosso artigo sobre a melhoria da tomada de decisões institucionais.

Outro exemplo é que poderíamos tentar tornar mais fácil para a civilização se recuperar de uma catástrofe. O Global Seed Vault é um cofre congelado no Ártico, que contém as sementes de muitas variedades importantes de culturas, reduzindo a chance de perdermos uma espécie importante. Água derretida entrou recentemente no túnel que leva ao cofre devido, ironicamente, às mudanças climáticas, então supomos que provavelmente esse projeto poderia ser melhor financiado. Existem muitos outros projetos como este que poderíamos fazer para preservar o conhecimento.

Da mesma forma, poderíamos criar melhor abrigos contra desastres, o que reduziria a chance de extinção por pandemias, inverno nuclear e asteroides (embora não IA), além de aumentar a chance de recuperação após um desastre. No momento, essas medidas não parecem tão eficazes quanto reduzir os riscos em primeiro lugar, mas ainda ajudam. Uma opção mais negligenciada e talvez muito mais barata é criar fontes alternativas de alimentos, como aquelas que podem ser produzidas sem luz e podem ser rapidamente ampliadas em um inverno prolongado.

Como os esforços amplos ajudam mesmo que não tenhamos certeza sobre os detalhes dos riscos, eles são mais atraentes quanto mais incerto você estiver. À medida que você se aproxima dos riscos, você deve realocar recursos gradualmente de esforços amplos para esforços direcionados (leia mais).

Esperamos que haja muitas intervenções amplas mais promissoras, mas é uma área em que pouca pesquisa foi feita. Por exemplo, outra abordagem poderia envolver a melhoria da coordenação internacional. Como esses riscos são causados pela humanidade, podem ser prevenidos pela humanidade, mas o que nos impede é a dificuldade de coordenação. Por exemplo, a Rússia não quer se desarmar porque a colocaria em desvantagem em relação aos EUA e vice-versa, embora ambos os países estivessem em melhor situação se não houvesse possibilidade de guerra nuclear.

No entanto, pode ser possível melhorar nossa capacidade de coordenação como civilização, por exemplo, melhorando as relações externas ou desenvolvendo melhores instituições internacionais. Estamos ansiosos para ver mais pesquisas sobre esses tipos de propostas.

Esforços comuns para fazer o bem, como melhorar a educação e o desenvolvimento internacional, também podem ajudar a tornar a sociedade mais resiliente e sábia e, assim, também contribuir para reduzir os riscos catastróficos. Por exemplo, uma população mais instruída provavelmente elegeria líderes mais esclarecidos (cof cof), e os países mais ricos são, tudo o mais igual, mais capazes de prevenir pandemias – não é por acaso que o Ebola se espalhou em algumas das partes mais pobres da África Ocidental.

Mas, não vemos a educação e a saúde como as melhores áreas para focar por duas razões. Primeiro, essas áreas são muito menos negligenciadas do que as abordagens menos convencionais que abordamos. Na verdade, melhorar a educação talvez seja a causa mais popular para as pessoas que querem fazer o bem, e só nos EUA recebe 800 bilhões de dólares de financiamento do governo e outros trilhões de dólares de financiamento privado. Em segundo lugar, essas abordagens têm efeitos muito mais difusos na redução desses riscos – você teria que melhorar a educação em uma escala muito grande para ter qualquer efeito perceptível. Preferimos focar em soluções mais direcionadas e negligenciadas.

3. Aprendendo mais e desenvolvendo capacidades

Estamos altamente incertos sobre quais riscos são maiores, o que é melhor fazer sobre eles e se todo o nosso quadro de prioridades globais pode estar totalmente errado. Isso significa que outro objetivo fundamental é aprender mais sobre todas essas questões.

Podemos aprender mais simplesmente tentando reduzir esses riscos e vendo o progresso que pode ser feito. No entanto, achamos que a maneira mais negligenciada e importante de aprender mais agora é fazer pesquisas de prioridades globais.

Esta é uma combinação de economia e filosofia moral que visa responder a perguntas de alto nível sobre as questões mais importantes para a humanidade. Há apenas um punhado de pesquisadores trabalhando em tempo integral nessas questões.

Outra maneira de lidar com a incerteza é criar recursos que possam ser implantados no futuro quando você tiver mais informações. Uma maneira de fazer isso é ganhar e economizar dinheiro. Você também pode investir em seu capital de carreira, especialmente em obter habilidades transferíveis e conexões, para que possa alcançar mais no futuro.

No entanto, achamos que uma abordagem potencialmente melhor do que qualquer uma dessas é construir uma comunidade focada na redução desses riscos, sejam eles quais forem. A razão pela qual isso pode ser melhor é que é possível aumentar a capacidade de uma comunidade mais rapidamente do que você pode aumentar sua riqueza individual ou capital de carreira. Por exemplo, se você passar um ano de sua vida divulgando essas ideias, é provável que você encontre ao menos uma pessoa com experiência relevante e que compre a ideia. Isso seria um retorno anual para a causa de cerca de 100%.

No momento, estamos focados em construir a comunidade de altruísmo eficaz, que inclui muitas pessoas que desejam reduzir esses riscos. Além disso, a taxa recente de crescimento e estudos de esforços específicos para aumentar a comunidade sugerem que altas taxas de retorno são possíveis.

No entanto, esperamos que outros esforços de construção da comunidade também sejam valiosos. Seria ótimo ver uma comunidade de cientistas tentando promover uma cultura de segurança na academia. Seria ótimo ver uma comunidade de formuladores de políticas públicas que quisessem tentar reduzir esses riscos e fazer com que o governo se preocupasse mais com as gerações futuras.

Dado que poucas pessoas trabalham ativamente na redução desses riscos, acreditamos que há muito que possa ser feito para se construir um movimento em torno desses problemas.

No total, qual é a eficácia em se reduzir esses riscos?

Considerando todas as abordagens para reduzir esses riscos e quão poucos recursos são dedicados a alguns deles, parece que um progresso substancial é possível.

Na verdade, mesmo se considerarmos apenas o impacto desses riscos na geração atual (ignorando quaisquer benefícios para as gerações futuras), eles são plausivelmente a principal prioridade.

Aqui estão alguns números muito aproximados e simplificados, apenas para ilustrar como isso pode ser possível. Parece plausível para nós que US$ 100 bilhões gastos na redução de ameaças existenciais possam reduzi-las em mais de 1% no próximo século. Espera-se que uma redução de um ponto percentual no risco salve cerca de 100 milhões de vidas entre a geração atual (1% de cerca de 10 bilhões de pessoas vivas hoje). Isso significaria que o investimento salvaria vidas por apenas US$ 1.000 por pessoa.27

Greg Lewis fez uma estimativa mais detalhada, chegando a uma média de $ 9.200 por ano de vida economizado na geração atual (ou ~ $ 300.000 por vida).28 Há também mais estimativas no tópico. Achamos que Greg provavelmente é muito conservador, porque ele assume que o risco de extinção é de apenas 1% no próximo século, quando nossa estimativa é que seja várias vezes maior. Também achamos que o próximo bilhão de dólares gasto na redução do risco existencial poderia causar uma redução maior no risco do que Greg supõe (observe que isso só é verdade se o bilhão for gasto nas questões mais negligenciadas, como segurança da IA e bioriscos). Como resultado, não ficaríamos surpresos se o custo por vida presente salva para o próximo bilhão de dólares investido na redução do risco existencial fosse inferior a US$ 100.

A organização mais recomendada da GiveWell, a Against Malaria Foundation (AMF), é frequentemente apresentada como uma das melhores maneiras de ajudar a geração atual e salva vidas por cerca de US$ 7.500 (valores de 2017).29 Portanto, essas estimativas colocariam a redução de ameaças existenciais como melhor ou no mesmo patamar de custo-benefício que a AMF para salvar vidas na geração atual – uma organização que foi selecionada especificamente por ser excelente nessa dimensão.

Da mesma forma, pensamos que, se 10.000 jovens talentosos concentrassem suas carreiras nesses riscos, poderiam alcançar uma redução de 1% nos riscos. Isso significaria que cada pessoa salvaria 1.000 vidas na expectativa de suas carreiras na geração atual, o que provavelmente é melhor do que eles poderiam economizar e então doar para a Against Malaria Foundation.30

Em certo sentido, essas são comparações injustas, porque a estimativa da GiveWell é muito mais sólida e bem pesquisada, enquanto nossa estimativa é mais um palpite informado. Também pode haver maneiras melhores de ajudar a geração atual do que a AMF (por exemplo, defesa de melhores políticas públicas).

No entanto, também subestimamos dramaticamente os benefícios de reduzir as ameaças existenciais. A principal razão para salvaguardar a civilização não é beneficiar a geração presente, mas beneficiar as gerações futuras. Nós os ignoramos nesta estimativa.

Se também considerarmos as gerações futuras, então a eficácia da redução das ameaças existenciais é de ordem de magnitude maior, e é difícil imaginar uma prioridade mais urgente agora.

Agora você pode ler algumas respostas a esses argumentos ou pular para formas práticas de contribuir.

Quem não deve priorizar a proteção do futuro?

Os argumentos apresentados baseiam-se em algumas suposições que nem todos aceitarão. Apresentamos algumas das melhores respostas aos argumentos abaixo:

- Você precisa se concentrar mais em seus amigos e familiares

- Você acha que os riscos são muito menores do que discutimos

- Você acha que não há quase nada mais que possamos fazer sobre os riscos

- Você acha que há uma maneira melhor de ajudar o futuro

- Você está confiante de que o futuro será curto ou ruim

- Você está confiante de que temos obrigações morais muito mais fortes para ajudar a geração atual

1.Você precisa se concentrar mais em seus amigos e familiares:

Estamos apenas falando sobre qual deve ser a prioridade se você está tentando ajudar as pessoas em geral, tratando os interesses de todos como iguais (o que os filósofos às vezes chamam de “altruísmo imparcial”).

A maioria das pessoas se preocupa em ajudar os outros até certo ponto: se você pode ajudar um estranho com pouco custo, isso é uma boa coisa a fazer. As pessoas também se preocupam em fazer com que suas próprias vidas corram bem e em cuidar de seus amigos e familiares, e nós somos o mesmo.

Como equilibrar essas prioridades é uma questão difícil. Se você está na posição privilegiada de poder contribuir para ajudar o mundo, achamos que proteger o futuro deve ser o foco. Listamos maneiras concretas de se envolver na próxima seção.

Caso contrário, você pode precisar se concentrar em sua vida pessoal agora, contribuindo paralelamente ou no futuro.

2.Você acha que os riscos são muito menores do que argumentamos:

Não temos estimativas robustas de muitos dos riscos causados pelo homem, então você pode tentar fazer suas próprias estimativas e concluir que elas são muito mais baixas do que imaginamos. Se fossem suficientemente baixos, reduzi-los deixaria de ser a principal prioridade.

Não achamos isso plausível pelos motivos abordados. Se você considerar todos os riscos potenciais, parece difícil ter certeza de que eles estão abaixo de 1% ao longo do século, e mesmo um risco de 1% provavelmente garante muito mais ação do que vemos atualmente.

3.Você acha que não há quase nada mais que possamos fazer sobre os riscos:

Classificamos esses riscos como menos “solúveis” do que questões como a saúde global, portanto, esperamos que o progresso seja mais difícil por dólar. Dito isso, achamos que sua escala e negligência mais do que compensam isso e, portanto, eles acabam sendo mais eficazes na expectativa. Muitas pessoas pensam que o altruísmo eficaz consiste apenas em apoiar intervenções “comprovadas”, mas isso é um mito. Vale a pena fazer intervenções que tenham apenas uma pequena chance de compensar, se o lado positivo for alto o suficiente. O principal financiador da comunidade agora defende uma abordagem de “doação baseada em acertos”.

No entanto, se você for muito mais pessimista quanto às chances de progresso do que nós, talvez seja melhor trabalhar em questões mais convencionais, como a saúde global.

Pessoalmente, poderíamos mudar para uma questão diferente se houvesse duas ordens de grandeza a mais de recursos investidos na redução desses riscos. Mas isso está muito longe de hoje.

Uma resposta relacionada é que já estamos realizando as melhores intervenções para reduzir esses riscos. Isso significaria que os riscos não justificam uma mudança nas prioridades práticas. Por exemplo, mencionamos anteriormente que a educação provavelmente ajuda a reduzir os riscos. Se você pensou que a educação era o melhorresposta (talvez porque você esteja muito incerto sobre quais riscos serão mais urgentes), então porque já investimos muito em educação, você pode pensar que a situação já está resolvida. Não achamos isso plausível porque, conforme listado, há muitas oportunidades não aproveitadas para reduzir esses riscos que parecem mais direcionados e negligenciados.

Outro exemplo como esse é que os economistas às vezes afirmam que devemos nos concentrar apenas no crescimento econômico, pois isso nos colocará na melhor posição possível para lidar com os riscos no futuro. Não achamos isso plausível porque alguns tipos de crescimento econômico aumentam os riscos (por exemplo, a descoberta de novas armas), portanto, não está claro se o crescimento econômico é a principal forma de reduzir os riscos. Em vez disso, pelo menos nos concentraríamos no desenvolvimento tecnológico diferencial, ou os outros esforços mais direcionados listados acima.

4.Você acha que há uma maneira melhor de ajudar o futuro:

Embora a redução desses riscos valha a pena para a geração atual, muito de sua importância vem de seus efeitos de longo prazo – uma vez que a civilização termina, desistimos de todo o futuro.

Você pode pensar que existem outras ações que a geração atual poderia tomar que teriam efeitos de longo prazo e que poderiam ser igualmente importantes para reduzir o risco de extinção. Em particular, podemos ser capazes de melhorar a qualidade do futuro evitando que nossa civilização fique permanentemente presa a maus resultados.

Isso vai ficar um pouco sci-fi, mas tenha paciência conosco. Uma possibilidade que tem sido levantada é que a nova tecnologia, como vigilância extrema ou condicionamento psicológico, poderia tornar possível a criação de um governo totalitário que nunca poderia acabar. Este seria o cenário de 1984 e Admirável Mundo Novo, respectivamente. Se esse governo fosse ruim, a civilização poderia ter um destino pior do que a extinção, fazendo-nos sofrer por milênios.

Outros levantaram a preocupação de que o desenvolvimento de sistemas avançados de IA poderia causar danos terríveis se for feito de forma irresponsável, talvez porque haja um conflito entre vários grupos levantando esforços para desenvolver a tecnologia. Em particular, se em algum momento no futuro o desenvolvimento desses sistemas envolver a criação de mentes digitais sencientes, seu bem-estar poderá se tornar extremamente importante.

Os riscos de um futuro que contém uma quantidade astronômica de sofrimento foram chamados de “s-riscos”.31 Se há algo que podemos fazer hoje para evitar que um risco s aconteça (por exemplo, por meio de pesquisa direcionada em segurança técnica de IA e governança de IA), isso pode ser ainda mais importante.

Outra área a ser observada são as grandes transições tecnológicas. Mencionamos os perigos da engenharia genética e da inteligência artificial neste artigo, mas essas tecnologias também podem criar uma segunda revolução industrial e fazer muito bem uma vez implantadas. Pode haver coisas que podemos fazer para aumentar a probabilidade de uma boa transição, em vez de diminuir o risco de uma transição ruim. Isso tem sido chamado de tentar aumentar a “esperança existencial” em vez de diminuir o “risco existencial”.32

Concordamos que pode haver outras maneiras pelas quais podemos ter efeitos de longo prazo, e isso pode ser mais urgente do que reduzir o risco de extinção. No entanto, a maioria dessas propostas ainda não está bem elaborada e não temos certeza do que fazer com elas.

O principal resultado prático de considerar essas outras formas de impactar o futuro é que achamos ainda mais importante gerenciar positivamente a transição para novas tecnologias transformadoras, como a IA. Também nos deixa mais ansiosos para ver mais pesquisas de prioridades globais que analisam essas questões.

No geral, ainda achamos que faz sentido focar primeiro na redução de ameaças existenciais e, depois disso, podemos voltar nossa atenção para outras maneiras de ajudar o futuro.

Uma maneira de ajudar o futuro que não acho que não deveria ser considerada é acelerá-lo. Algumas pessoas que querem ajudar o futuro se concentram em trazer progresso tecnológico, como desenvolver novas vacinas, e é verdade que isso gera benefícios de longo prazo. No entanto, pensamos que o mais importante de uma perspectiva de longo prazo é onde terminamos, e não com que rapidez chegamos lá. Descobrir uma nova vacina provavelmente significa que a tomamos mais cedo, em vez de fazê-la acontecer.

Além disso, como a tecnologia também é a causa de muitos desses riscos, não está claro o quanto acelerá-la ajuda no curto prazo.

Acelerar o progresso também é muito menos negligenciado, pois beneficia também a geração atual. Como cobrimos, mais de 1 trilhão de dólares é gasto a cada ano em P&D para desenvolver novas tecnologias. Portanto, acelerações são menos importantes e menos negligenciadas.

Para ler mais sobre outras maneiras de ajudar as gerações futuras, consulte o capítulo 3 de On the Overwhelming Importance of Shaping the Far Future, do Dr. Nick Beckstead.

5.Você está confiante de que o futuro será curto ou ruim:

Se você acha que é virtualmente garantido que a civilização não durará muito tempo, então o valor de reduzir esses riscos é significativamente reduzido (embora talvez ainda valha a pena ajudar a geração atual e um pequeno número de gerações futuras).

Concordamos que há uma chance significativa de que a civilização termine logo (é por isso que essa questão é tão importante), mas também achamos que há uma chance grande o suficiente de que ela possa durar muito tempo, o que faz valer a pena lutar pelo futuro.

Da mesma forma, se você acha que é provável que o futuro seja mais ruim do que bom (ou se temos muito mais obrigação de reduzir o sofrimento do que aumentar o bem-estar), então o valor de reduzir esses riscos diminui. Não achamos que isso seja provável, no entanto, porque as pessoas querem que o futuro seja bom, então tentaremos torná-lo mais bom do que ruim. Também achamos que houve progresso moral significativo nos últimos séculos (devido às tendências observadas anteriormente) e estamos otimistas de que isso continuará. Veja mais discussão na nota de rodapé 11. 11

Além do mais, mesmo que você não tenha certeza de quão bom será o futuro, ou suspeite que será ruim de maneiras que podemos evitar no futuro, você pode querer que a civilização sobreviva e mantenha suas opções em aberto. As pessoas no futuro terão muito mais tempo para estudar se é desejável que a civilização se expanda, permaneça do mesmo tamanho ou diminua. Se você acha que há uma boa chance de podermos agir de acordo com essas preocupações morais, esse é um bom motivo para deixar as decisões finais para a sabedoria das gerações futuras. No geral, estamos muito incertos sobre essas questões gerais, mas isso geralmente nos deixa mais preocupados em evitar compromissos irreversíveis.33

Além disso, você provavelmente deve colocar sua atenção em maneiras de diminuir a chance de que o futuro seja ruim, como evitar riscos.

6.Você está confiante de que temos obrigações morais muito mais fortes para ajudar a geração atual:

Se você acha que temos obrigações muito mais fortes com a geração atual do que com as gerações futuras (como pontos de vista éticos que afetam as pessoas), então a importância de reduzir esses riscos diminuiria. Pessoalmente, não achamos que essas visualizações sejam particularmente atraentes.

Dito isso, argumentamos que, mesmo que você ignore as gerações futuras, vale a pena enfrentar esses riscos. Os esforços sugeridos ainda poderiam salvar as vidas da geração atual de forma relativamente barata e poderiam evitar muito sofrimento em desastres de médio porte.

Além do mais, se você não tem certeza se temos obrigações morais para com as gerações futuras, então você deve novamente tentar manter suas opções em aberto, e isso significa salvaguardar a civilização.

No entanto, se você acha que não temos grandes obrigações para com as gerações futuras e que os riscos também são relativamente insolúveis (ou que não há pesquisas úteis a serem feitas), então outra maneira de ajudar as gerações atuais pode surgir. Isso pode significar trabalhar em saúde global ou saúde mental. Alternativamente, você pode pensar que há outra questão moral que é mais importante, como a pecuária industrial.

Quer ajudar a reduzir as ameaças existenciais?

Nossa geração pode ajudar a causar o fim de tudo, ou navegar a humanidade por seu período mais perigoso e se tornar uma das gerações mais importantes da história.

Podemos ser a geração que possibilita alcançar um mundo incrível e florescente, ou que coloca tudo em risco.

Como pessoas que querem ajudar o mundo, é aqui que devemos concentrar nossos esforços.

Se você quer focar sua carreira na redução de ameaças existenciais e na salvaguarda do futuro da humanidade, nós queremos ajudar. Escrevemos um artigo descrevendo suas opções e etapas que você pode seguir para começar.

COMO USAR SUA CARREIRA PARA REDUZIR AMEAÇAS EXISTENCIAIS

Saiba mais

- Leia cerca de 51 ideias de políticas e pesquisas para reduzir o risco existencial.

- Veja a versão acadêmica desse argumento neste artigo do professor Nick Bostrom.

- Leia o argumento para focar nas gerações futuras.

- Leia uma introdução alternativa à ideia de que nosso impacto nas gerações futuras é extremamente importante moralmente — incluindo uma seção sobre objeções.

- Você pode ouvir ideias relacionadas discutidas em nossos podcasts com o Dr. Toby Ord e o Dr. Nick Beckstead, bem como outros episódios sobre riscos específicos.

- Ouça esta entrevista com Thomas Moynihan sobre a história intelectual do risco existencial.

- Também recomendamos nossos podcasts com Carl Shulman sobre o caso de senso comum para o trabalho de risco existencial e suas implicações práticas e com Will MacAskill sobre o que devemos ao futuro (em inglês) (N.T: leia, em português, a introdução do livro “O que devemos ao futuro” de MacAskill, aqui.

Notas e Referências

1. Ao longo dos últimos quatro meses tornou-se provável – através do trabalho de Joliot na França, bem como de Fermi e Szilárd na América – que pode ser possível estabelecer uma reação nuclear em cadeia em uma grande massa de urânio, por quais grandes quantidades de energia e grandes quantidades de novos elementos semelhantes ao rádio seriam gerados. Agora parece quase certo que isso pode ser alcançado no futuro imediato. Esse novo fenômeno também levaria à construção de bombas, e é concebível – embora muito menos certo – que bombas extremamente poderosas de um novo tipo possam ser construídas. Uma única bomba desse tipo, transportada por barco e explodida em um porto, poderia muito bem destruir todo o porto junto com parte do território circundante. No entanto, essas bombas podem muito bem revelar-se pesadas demais para serem transportadas por via aérea. Carta de Einstein–Szilárd, Wikipedia, Link arquivado, recuperado em 17 de outubro de 2017.

2. Nick Bostrom define um risco existencial como um evento que “pode causar a extinção humana ou reduzir permanente e drasticamente o potencial da humanidade”. Um risco existencial é distinto de um risco catastrófico global (GCR) em seu escopo – um GCR é catastrófico em escala global, mas mantém a possibilidade de recuperação. Uma ameaça existencial parece ser usada como um modificador linguístico de uma ameaça para fazê-la parecer mais terrível.

3. Greenberg pesquisou usuários do Mechanical Turk, que tendem a ter entre 20 e 40 anos e mais escolaridade do que a média, então a pesquisa não representa a opinião de todos os americanos. Veja mais detalhes neste vídeo:

Social Science as Lens on Effective Charity: resultados de quatro novos estudos – Spencer Greenberg, 12:15.A pesquisa inicial encontrou uma estimativa mediana da chance de extinção dentro de 50 anos de 1 em 10 milhões. Greenberg fez três estudos de replicação e estes forneceram estimativas mais altas das chances. O mais alto encontrou uma mediana de 1 em 100 ao longo de 50 anos. No entanto, mesmo neste caso, 39% dos entrevistados ainda supunham que as chances eram inferiores a 1 em 10.000 (aproximadamente a mesma que a chance de um asteroide de 1 km). Em todos os casos, mais de 30% acharam que as chances eram inferiores a 1 em 10 milhões. Você pode ver um resumo de todas as pesquisas aqui.Observe que quando perguntamos às pessoas sobre as chances de extinção sem prazo, as estimativas foram muito maiores. Uma pesquisa deu uma mediana de 75%. Isso faz sentido – a humanidade acabará por ser extinta. Isso ajuda a explicar a discrepância com algumas outras pesquisas. Por exemplo, “Climate Change in the American Mind” (maio de 2017, link arquivado), descobriu que o americano médio achava que a chance de extinção pelas mudanças climáticas é de cerca de 1 em 3. Essa pesquisa, no entanto, não perguntou sobre um prazo específico. Quando Greenberg tentou replicar o resultado com a mesma pergunta, encontrou um número semelhante. Mas quando Greenberg perguntou sobre a chance de extinção pelas mudanças climáticas nos próximos 50 anos, a mediana caiu para apenas 1%. Muitos outros estudos também não amostram corretamente estimativas de baixa probabilidade – as pessoas normalmente não respondem 0,00001%, a menos que sejam apresentadas a opção explicitamente.No entanto, como você pode ver, esses tipos de pesquisas tendem a dar resultados muito instáveis. As respostas parecem variar exatamente como a pergunta é feita e no contexto. Em parte, isso ocorre porque as pessoas são muito ruins em fazer estimativas de probabilidades minúsculas. Isso torna difícil dar uma estimativa estreita do que a população em geral pensa, mas nada do que descobrimos refuta a ideia de que um número significativo de pessoas (digamos, mais de 25%) acha que as chances de extinção no curto prazo são muito, muito baixo e provavelmente menor do que o risco de um asteroide sozinho. Além disso, a instabilidade das estimativas não parece motivo de confiança de que a humanidade esteja lidando racionalmente com esses riscos.

4. Para causar a extinção da vida humana, o corpo impactante provavelmente teria que ter mais de 1 km de diâmetro (e provavelmente 3 – 10 km). Houve pelo menos cinco e talvez mais de uma dúzia de extinções em massa na Terra, e pelo menos algumas delas foram provavelmente causadas por impactos ([9], pp. 81f.). Em particular, a extinção K/T há 65 milhões de anos, na qual os dinossauros foram extintos, tem sido associada ao impacto de um asteroide de 10 a 15 km de diâmetro na península de Yucatán. Estima-se que um corpo de 1 km ou mais colida com a Terra cerca de uma vez a cada 0,5 milhão de anos. Nós apenas catalogamos uma pequena fração dos corpos potencialmente perigosos. BOSTROM, Nick. “Riscos existenciais: analisando cenários de extinção humana e perigos relacionados.” (2002). Link arquivado, recuperado em 21 de outubro de 2017.

5. As chances de cair no Atlântico em um A330 operado pela Virgin voando de Heathrow para JFK (1 em 5,4 milhões). Então, você precisaria voar 1000 vezes em sua vida para ter a mesma probabilidade de estar em um acidente de avião como em um desastre de asteróide. Um curso intensivo de probabilidade, The Economist, 2015. Web, recuperado em 14-outubro-2017.

6. Um supervulcão suficientemente grande também pode causar um longo inverno que acaba com a vida. Alguns outros riscos naturais podem incluir uma pandemia especialmente mortal, uma supernova próxima ou uma explosão de raios gama ou uma mudança climática descontrolada causada naturalmente.

7. Você pode ver um resumo do conteúdo do artigo em “Dr Toby Ord – Will We Cause Our Own Extinction? Natural versus Anthropogenic Extinction Risks”, palestra proferida no CSER em Cambridge em 2015. Link.

8. Gráfico produzido a partir de Maddison, Angus (2007): “Contours of the World Economy, 1–2030 AD. Essays in Macro-Economic History,” Oxford University Press, ISBN 978-0-19-922721-1, p. 379, tabela A.4.

9. Quão grande foi a Revolução Industrial?, por Luke Muehlhauser, 2017, link arquivado, recuperado em 21 de outubro de 2017.

10. Diferentes pesquisas encontram resultados substancialmente diferentes sobre como as pessoas são pessimistas em relação ao futuro, mas muitos acham que a maioria acha que o mundo está piorando. Por exemplo, uma pesquisa recente do governo no Reino Unido descobriu que 71% dos entrevistados disseram que achavam que o mundo estava piorando. Declinismo: o mundo está realmente piorando?, Pete Etchells, The Guardian, 2015, Link arquivado, recuperado em 17 de outubro de 2017.

11. O mundo está melhorando? Embora a maioria das medidas de progresso pareça estar aumentando (conforme abordado no artigo), existem algumas maneiras pelas quais a vida pode ter piorado. Por exemplo, em Sapiens, Yuval Harari argumenta que a solidão e os problemas de saúde mental aumentaram na era moderna, enquanto nosso senso de propósito e significado pode ter diminuído. Estamos céticos de que essas desvantagens compensem os ganhos, mas é difícil estar confiante. Um caso mais forte de que o mundo está piorando vem se você considerar nosso impacto sobre os animais. Em particular, desde a década de 1960 a pecuária industrial cresceu dramaticamente, e agora há talvez bem mais de 30 bilhões de animais vivendo em condições terríveis em fazendas industriais a cada ano. Se nos preocuparmos com o sofrimento desses animais, isso pode superar os ganhos no bem-estar humano. Em conjunto, não achamos óbvio que o bem-estar aumentou. No entanto, a questão mais importante é o que o futuro reserva. O futuro será melhor? Nossa visão é que – desde que evitemos a extinção – o aumento da tecnologia e do progresso moral nos dá a oportunidade de resolver nossos piores problemas sociais e ter vidas muito melhores no futuro. Colocando de lado as ameaças existenciais, se considerarmos problemas globais específicos, muitos deles poderiam ser corrigidos com maior riqueza, tecnologia e mais progresso moral e político do tipo que vimos. Por exemplo, no caso da pecuária industrial, esperamos que, à medida que as pessoas fiquem mais ricas, o problema diminua. Primeiro, as pessoas ricas são mais propensas a comprar produtos com altos padrões de bem-estar porque custa menos para elas. Em segundo lugar, a tecnologia tem o potencial de acabar com a pecuária industrial criando substitutos de carne, carne cultivada ou práticas agrícolas menos prejudiciais. Terceiro, a preocupação moral com outros seres parece ter aumentado ao longo do tempo – o “círculo moral em expansão” – então esperamos que as pessoas no futuro tenham mais preocupação com o bem-estar animal. Se diminuirmos ainda mais o zoom, em última análise, esperamos que o futuro seja melhor porque as pessoas querem que seja melhor. À medida que obtemos mais poder tecnológico e liberdade, as pessoas são mais capazes de alcançar seus valores. Como as pessoas querem um bom futuro, é mais provável que melhore do que piore. Tudo isso dito, há muitas complicações para esta imagem. Por exemplo, muitos de nossos valores estão em tensão com os outros, e isso pode causar conflito. Essas questões sobre o que o futuro reserva também receberam pouca pesquisa. Assim, embora esperemos um futuro melhor, admitimos muita incerteza.

12. Para saber mais sobre a história desses quase acidentes, veja nosso podcast com o Dr. Toby Ord.

13. Cinquenta anos atrás, a crise dos mísseis cubanos levou o mundo à beira de um desastre nuclear. Durante o impasse, o presidente John F. Kennedy pensou que a chance de escalada para a guerra era “entre 1 em 3 e até mesmo”, e o que aprendemos nas últimas décadas não fez nada para aumentar essas chances. Tal conflito pode ter levado à morte de 100 milhões de americanos e mais de 100 milhões de russos. Aos 50 anos, a crise dos mísseis cubanos como guia, Graham Allison, The New York Times, 2012,

link arquivado, recuperado em 17 de outubro de 2017.

14. Para a chance de uma bomba atingir um alvo civil, veja a figura um terço abaixo da página “Qual é a probabilidade de que uma bomba nuclear seja lançada sobre um alvo civil na próxima década?” Observe que um especialista estimou a chance de um ataque nuclear contra um alvo civil na próxima década em menos de 1%.Os especialistas estão mais preocupados com a Índia-Paquistão do que com a Coreia do Norte? O conflito que liderou a lista de confrontos dos especialistas para se preocupar é Índia-Paquistão. Ambos os estados desenvolveram armas nucleares fora da jurisdição do Tratado de Não-Proliferação, ambos os estados têm capacidades limitadas, o que pode incentivar o uso precoce, e ambos os estados – embora suas doutrinas públicas sejam intencionalmente ambíguas – são conhecidos por terem planos de contingência envolvendo primeiros ataques nucleares contra alvos militares. Estamos nos aproximando da guerra nuclear, Milo Beckman, FiveThirtyEight, 2017, link arquivado, recuperado em 17 de outubro de 2017.

15. Quando o “inverno nuclear” se tornou uma preocupação? “Inverno nuclear” e seu progenitor, “crepúsculo nuclear”, referem-se a eventos nucleares. O inverno nuclear começou a ser considerado um conceito científico na década de 1980, depois que ficou claro que uma hipótese anterior, de que as emissões de NOx geradas por bolas de fogo devastariam a camada de ozônio, estava perdendo credibilidade. Foi nesse contexto que os efeitos climáticos da fuligem dos incêndios foram “casados” e logo se tornaram o novo foco dos efeitos climáticos da guerra nuclear. Nesses cenários de modelo, várias nuvens de fuligem contendo quantidades incertas de fuligem foram assumidas sobre cidades, refinarias de petróleo e mais silos de mísseis rurais. Uma vez que a quantidade de fuligem é decidida pelos pesquisadores, os efeitos climáticos dessas nuvens de fuligem são então modelados. O termo “inverno nuclear” foi cunhado em 1983 por Richard P. Turco em referência a um modelo de computador 1-dimensional criado para examinar a ideia do “crepúsculo nuclear”, este modelo 1-D produz a descoberta de que grandes quantidades de fuligem e fumaça permaneceriam no ar por anos, causando um grave queda de temperatura em todo o planeta. Turco mais tarde se distanciaria dessas conclusões 1-D extremas.” “Nuclear Winter” na Wikipedia, link arquivado, recuperado em 30 de outubro de 2017.

16. Os modelos climáticos envolvem incerteza significativa, o que significa que os riscos podem facilmente ser maiores do que os modelos atuais sugerem. Além disso, a existência de incerteza do modelo em geral torna difícil fornecer estimativas muito baixas da maioria dos riscos, conforme explicado em:

Ord, T., Hillerbrand, R., & Sandberg, A. (2010). Sondando o improvável: desafios metodológicos para riscos com baixa probabilidade e alto risco. Journal of Risk Research, 13(2), pp. 191-205. arXiv:0810.5515v1, link.

17. A gravidade esperada do inverno nuclear ainda está sendo debatida, e a Open Philanthropy recentemente financiou uma investigação mais aprofundada sobre o assunto.

18. Ver caixa SPM1.1 na seção B do Resumo para Formuladores de Políticas da Contribuição do Grupo de Trabalho I para o Sexto Relatório de Avaliação do Painel Intergovernamental sobre Mudanças Climáticas.

19. Pode ter matado entre 3% e 6% da população global. O papel da Primeira Guerra Mundial na pior pandemia de gripe de todos os tempos, John Mathews, The Conversation, 2014, link arquivado, recuperado em 27 de outubro de 2017.Uma população mundial de 1.811 milhões sofrendo 30 milhões de mortes teria uma taxa de mortalidade de 16,6 por mil, três vezes a taxa dos países mais ricos, mas bem dentro da faixa dos pobres. As estimativas de 50-100 milhões de mortes por gripe colocariam as taxas globais em aproximadamente 27,6-55,2 por mil. Patterson, KD e Pyle, GF, 1991. A geografia e mortalidade da pandemia de gripe de 1918. Boletim de História da Medicina, 65(1), p.4.

Link arquivado, recuperado em 22 de outubro de 2017.Pesquisas adicionais viram a revisão consistente para cima da mortalidade global estimada da pandemia, que um cálculo da década de 1920 colocou nas proximidades de 21,5 milhões. Um artigo de 1991 revisou a mortalidade como estando na faixa de 24,7 a 39,3 milhões. Este artigo sugere que foi da ordem de 50 milhões. No entanto, deve-se reconhecer que mesmo esse grande número pode ser substancialmente menor do que o número real, talvez até 100% subestimado. Johnson, NP e Mueller, J., 2002. Atualizando as contas: mortalidade global da pandemia de influenza 1918-1920 “espanhol”. Boletim da História da Medicina, 76(1), pp.105-115.

Web.

20. Revelado: as leis frouxas que podem permitir a montagem de DNA de vírus mortal: Urgente pede regulamentação depois que o Guardian compra parte do genoma da varíola por correspondência, The Guardian, 2006, Link arquivado, recuperado em 21 de outubro de 2017.

21. Os pesquisadores acreditam que há 50% de chance de a IA superar os humanos em todas as tarefas em 45 anos. Os entrevistados foram questionados se o HLMI teria um impacto positivo ou negativo na humanidade a longo prazo. Eles atribuíram probabilidades aos resultados em uma escala de cinco pontos. A probabilidade mediana foi de 25% para um resultado “bom” e 20% para um resultado “extremamente bom”. Por outro lado, a probabilidade era de 10% para um resultado ruim e 5% para um resultado descrito como “Extremamente Ruim (por exemplo, extinção humana)”.Grace, K., Salvatier, J., Dafoe, A., Zhang, B. e Evans, O., 2017. Quando a IA excederá o desempenho humano? Evidências de especialistas em IA. arXiv pré-impressão arXiv:1705.08807.

Web.

22. Para uma discussão sobre as inconsistências nas estimativas, consulte a postagem do blog divulgada pela AI Impacts, “Some Survey Results”, link arquivado, recuperado em 30 de outubro de 2017. Por exemplo: Perguntar às pessoas sobre trabalhos específicos altera massivamente as previsões do HLMI. Quando perguntamos a algumas pessoas quando a IA seria capaz de fazer várias ocupações humanas específicas e, em seguida, todas as ocupações humanas (presumivelmente um subconjunto de todas as tarefas), eles deram cronogramas muito posteriores do que quando perguntamos diretamente sobre o HLMI. Para as pessoas solicitadas a dar probabilidades para certos anos, a diferença era um fator de mil e vinte anos! (10% vs. 0,01%) Para as pessoas solicitadas a dar anos para certas probabilidades, a maneira normal de pedir 50% de chance de 40 anos, enquanto o ‘enquadramento de ocupações’ coloca 90 anos. As pessoas consistentemente fornecem previsões posteriores se você perguntar a probabilidade em N anos em vez do ano em que a probabilidade é M. Vimos isso na pergunta direta do HLMI e na maioria das tarefas e ocupações, e também na maioria dessas coisas quando nós os testamos em pessoas mturk mais cedo. Para o HLMI, por exemplo, se você perguntar quando haverá 50% de chance de HLMI, obterá uma resposta mediana de 40 anos, mas se perguntar qual é a probabilidade de HLMI em 40 anos, obterá uma resposta mediana de 30%.

23. Declarações ocasionais de estudiosos como Alan Turing, IJ Good e Marvin Minsky indicaram preocupações filosóficas de que uma superinteligência poderia assumir o controle. Veja as notas de rodapé 15-18 em Risco existencial da inteligência artificial, Wikipedia, link arquivado, recuperado em 21 de outubro de 2018.

24. Há milhões de mortes a cada ano devido a doenças facilmente evitáveis, como malária e diarréia, embora os números estejam caindo rapidamente, então parece improvável que ultrapassem 300 milhões no próximo século. Mortes anuais por malária caíram de 3,8 milhões para cerca de 0,7 milhão. Mortes anuais por diarreia (redução) de 4,6 milhões para 1,6 milhão. A Ajuda humanitária ajuda (na média), Dr. Toby Ord, dando o que podemos, Web.

25. A Via Láctea contém pelo menos 100 bilhões de planetas de acordo com a pesquisa,

link arquivado do Hubblesite, recuperado em 22 de outubro de 2017.

26. A despesa bruta global em pesquisa e desenvolvimento (GERD) totalizou 1,48 trilhão de dólares PPP (paridade do poder de compra) em 2013.Fatos e números: Despesas em P&D, UNESCO,

Link arquivado, recuperado em 21 de outubro de 2017. A indústria geral registrou um crescimento constante de 4%, para um valor estimado de € 1,08 trilhão em vendas no varejo em 2016.Luxury Goods Worldwide Market Study, Fall-Winter 2016, Claudia D’Arpizio, Federica Levato, Daniele Zito, Marc-André Kamel and Joëlle de Montgolfier, Bain & Company,

Link arquivado, recuperado em 21 de outubro de 2017. A melhor estimativa do custo dos 185 programas federais de assistência social testados para 2010 só para o governo federal é de quase US$ 700 bilhões, um terço a mais desde 2008, segundo a Heritage Foundation. Contando os gastos do estado, os gastos totais com o bem-estar em 2010 chegaram a quase US$ 900 bilhões, quase um quarto a mais desde 2008 (24,3%).Império de bem-estar sempre em expansão da América, Peter Ferrara, Forbes,

link arquivado, recuperado em 2 de março de 2016. Após estabilizar em 2012 e diminuir em 2013, o montante de financiamento climático investido em todo o mundo em 2014 aumentou 18%, de US$ 331 bilhões para cerca de US$ 391 bilhões.Global Landscape of Climate Finance 2015, Climate Policy Initiative, 2015,