Moldar positivamente o desenvolvimento da Inteligência Artificial é um dos maiores problemas do mundo. Veja a lista dos demais problemas aqui.

Muitos especialistas acreditam que há uma chance significativa de que a inteligência artificial se desenvolva a ponto de termos máquinas mais inteligentes que humanos no século XXI. Isso poderia levar a grandes e rápidas melhorias no bem-estar humano, mas há boas razões para pensar que isso também poderia levar a resultados desastrosos.

“Não há como duvidar da força destes argumentos … esse problema é um desafio de pesquisa digno do melhor talento matemático da próxima geração. A civilização humana está em jogo ”.

– Clive Cookson, editor de ciências do Financial Times

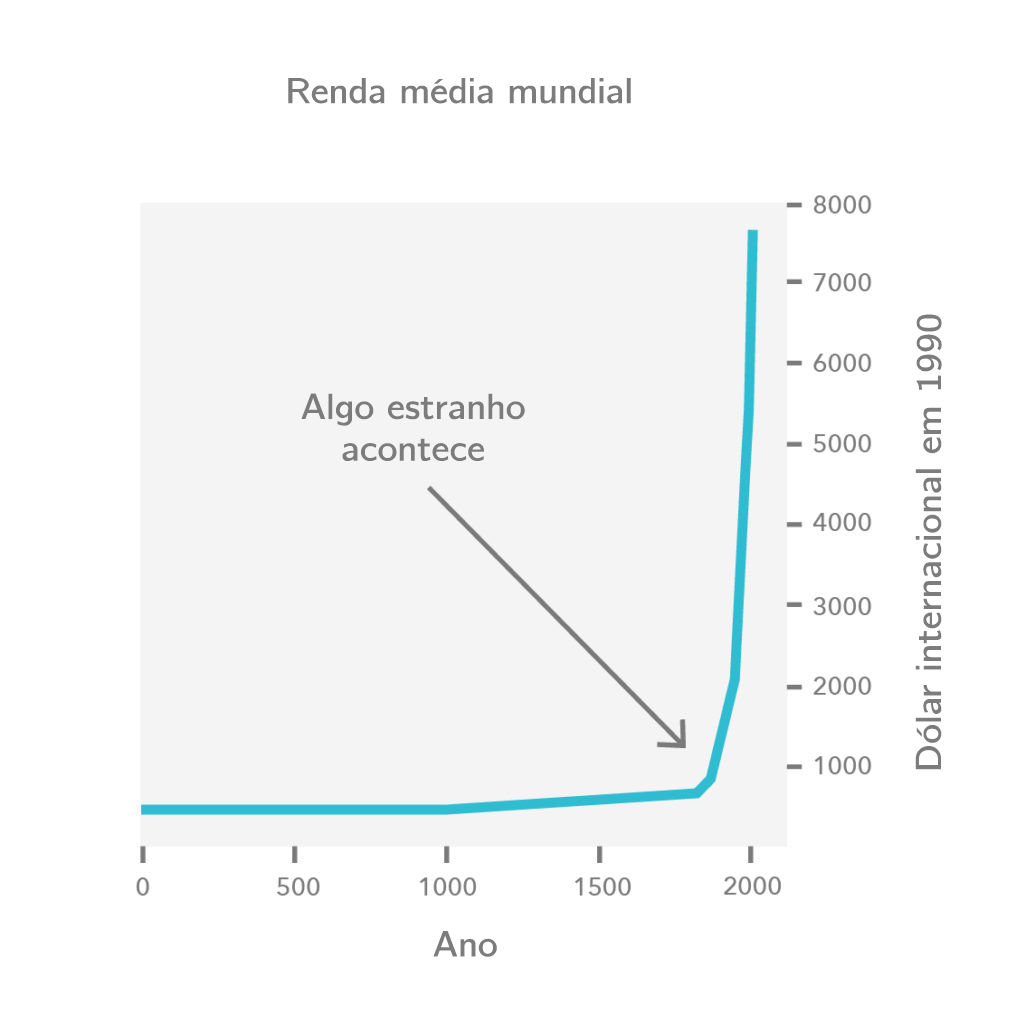

Por volta de 1800, a civilização passou por uma das mudanças mais profundas da história humana: a revolução industrial.1

Este não foi o primeiro evento desse tipo – a revolução agrícola transformou vidas humanas 12 mil anos antes.

Um crescente número de especialistas acredita que uma terceira revolução ocorrerá durante o século XXI, pela invenção de máquinas com inteligência que supera em muito a nossa. Estes especialistas vão desde Stephen Hawking a Stuart Russell, o autor do livro de Inteligência Artificial (IA) sucesso de vendas: AI: A Modern Approach.2

O rápido progresso no “aprendizado de máquina” (machine learning) elevou a perspectiva de que os algoritmos um dia serão capazes de realizar a maioria ou todas as tarefas mentais realizadas atualmente por humanos. Isso poderia levar a máquinas que são muito melhores nessas tarefas do que nós.

Esses avanços podem levar a desenvolvimentos extremamente positivos, apresentando soluções para problemas globais atualmente intratáveis, mas também apresentam riscos graves. A inteligência superior da humanidade é praticamente a única razão pela qual é a espécie dominante no planeta. Se as máquinas ultrapassarem os humanos em inteligência, então, assim como o destino dos gorilas depende hoje das ações dos humanos, o destino da humanidade pode vir a depender mais das ações das máquinas do que das nossas. Para uma explicação técnica dos riscos na perspectiva de cientistas da computação, veja esses artigos.34

Essa pode ser a transição mais importante do próximo século – podendo tanto inaugurar uma era de riqueza e progresso sem precedentes ou sendo o prenúncio de um desastre. Mas também é uma área altamente negligenciada: enquanto bilhões são gastos tornando a IA mais poderosa,5 estimamos que menos de 100 pessoas no mundo estão trabalhando em como tornar a IA mais segura.6

Esse é um problema incomum e nos levou muito tempo para compreendê-lo. Soa estranho? Definitivamente. Quando encontramos essas ideias pela primeira vez em 2009, estávamos bastante céticos. Mas, como muitos outros, quanto mais lemos, mais preocupados ficamos.7 Nós também passamos a acreditar que esse desafio técnico provavelmente pode ser superado se a humanidade realmente se esforçar nele.

Trabalhar em um problema recém-reconhecido significa que você se arrisca a se deparar com um problema que nunca se materializará ou que acabará sendo solucionado facilmente – mas também significa que você pode ter um impacto maior ao abrir caminho em uma área que ainda não foi adequadamente avaliada, tal como muitas das pessoas com maior impacto na história fizeram. A seguir, abordaremos os argumentos para trabalhar nessa área e analisaremos as melhores maneiras de contribuir na solução deste problema.

1.Resumo

A inteligência artificial trata-se de um assunto em geral muito mal compreendido: como alguém pode projetar uma máquina altamente inteligente, para perseguir objetivos humanos realistas, com segurança. Se a pesquisa em IA continuar avançando sem atenção suficiente ao problema do controle dessas máquinas, acidentes catastróficos tem muito maior chance de ocorrerem. Apesar do reconhecimento crescente deste desafio, menos de 100 pessoas em todo o mundo estão trabalhando diretamente no problema.

2.Nossa visão sobre Inteligência Artificial

Recomendado

Este é um dos problemas mais urgentes para se trabalhar.

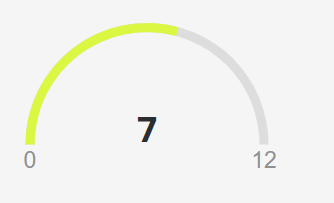

Escala?

|

Estimamos que o risco de uma catástrofe causada pela inteligência das máquinas nos próximos 100 anos esteja entre 1% e 10%. |

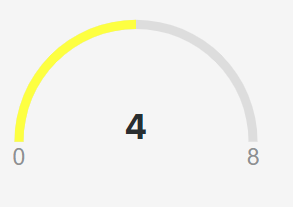

Negligência?

|

US$ 10 milhões de financiamento anual. Esta estimativa busca incluir tanto o trabalho em abordagens técnicas como políticas para moldar positivamente a IA; Inclui organizações focadas exclusivamente em moldar positivamente o futuro da IA, além de equipes e indivíduos que realizam trabalhos relevantes em organizações mais amplas. |

Capacidade de Resolução?

|

Acreditamos que se duplicássemos o esforço destinado a essa área reduziríamos o tamanho do risco existente em cerca de 1%. |

Profundidade do perfil: Média profundidade

Autor do perfil: Robert Wiblin

Este perfil é baseado em entrevistas com: Professor Nick Bostrom na Universidade de Oxford, o autor da Superinteligência; um professor líder anônimo de ciência da computação; Jaan Tallinn, um dos maiores doadores nesta área e co-fundador do Skype; Jan Leike, pesquisador de machine learning agora na DeepMind; Miles Brundage, pesquisador de política de IA no Future of Humanity Institute da Universidade de Oxford; Nate Soares, diretor executivo do Machine Intelligence Research Institute; Daniel Dewey, que trabalha em tempo integral para encontrar pesquisadores e oportunidades de financiamento no campo; e vários outros pesquisadores na área. Também lemos os conselhos de David Krueger, aluno de doutorado em machine learning.

Este é um dos muitos perfis que escrevemos para ajudar as pessoas a encontrar os problemas mais urgentes que podem resolver com suas carreiras. Saiba mais sobre como comparamos diferentes problemas, veja como tentamos classificá-los numericamente e veja como esse problema se compara aos outros que consideramos até agora.

3.Por que trabalhar nesse problema?

Os argumentos para trabalhar nessa área problemática são complexos e o que se segue é apenas um breve resumo. Se você prefere assistir a um vídeo, veja esta palestra introdutória no TED:

Aqueles que já estão familiarizados com a ciência da computação podem preferir assistir a essa palestra do professor de Ciência da Computação da Universidade da Califórnia em Berkeley, Stuart Russell. Essa palestra avança mais nas potenciais agendas de pesquisa.

Se você quiser ir ainda mais longe e dedicar algum tempo a entender essa questão, recomendamos a leitura de Superinteligência: Caminhos, Estratégias, Perigos, do professor da Oxford, Nick Bostrom. A Revolução da Inteligência Artificial, uma publicação de Tim Urban no Wait But Why, é uma leitura mais curta e também muito boa (e também recomendamos ver essa resposta a publicação de Tim Urban).

3.1.Progressos recentes em “aprendizado de máquina”(machine learning) sugerem que o impacto da Inteligência Artificial pode ser grande e repentino

Quando Tim Urban começou a investigar e escrever seu artigo sobre esse assunto, ele esperava termina-lo em alguns dias. Em vez disso, ele passou semanas lendo tudo o que podia, porque, em suas palavras “rapidamente me ocorreu que o que está acontecendo no mundo da IA não é apenas um tópico importante, mas de longe o tópico mais importante para o nosso futuro”.

Em outubro de 2015, um sistema de IA chamado AlphaGo chocou o mundo ao derrotar um profissional no antigo jogo de tabuleiro chinês Go pela primeira vez. Apenas cinco meses depois, um segundo choque: o AlphaGo derrotou um dos melhores profissionais de Go do mundo, vencendo quatro partidas em cinco. Sete meses depois, o mesmo programa havia melhorado, esmagando os principais jogadores do mundo em uma sequência de 60 vitórias. No espaço de um ano, o avanço desta IA foi de “fraca demais” para vencer um único jogo contra os piores profissionais humanos até uma posição onde foi impossível até para os melhores jogadores do mundo a derrotarem.

Isso foi chocante porque o jogo Go é considerado muito mais difícil para uma máquina jogar do que o xadrez. O número de movimentos possíveis no Go é vasto, por isso não é possível calcular o melhor movimento através da “força bruta”. Em vez disso, o jogo requer intuição estratégica. Alguns especialistas acharam que demoraria pelo menos uma década para que Go fosse conquistado.8

Desde então, a AlphaGo descobriu que certas formas de jogar Go que os humanos consideraram, por milhares de anos, insensatas, eram realmente superiores. Ke Jie, o melhor jogador do mundo, ficou surpreso: “depois da humanidade ter passado milhares de anos melhorando nossas táticas”, ele disse, “os computadores nos dizem que os humanos estão completamente errados. Eu diria até mesmo que nem um único humano tocou o limite da verdade de Go”.9

Os avanços acima se tornaram possíveis devido ao progresso em uma técnica de IA chamada “aprendizagem profunda”(deep learning). No passado, tínhamos que fornecer instruções detalhadas aos computadores para cada tarefa. Hoje, temos programas que ensinam a si próprios como alcançar um objetivo – por exemplo, um programa foi capaz de aprender a jogar jogos de Atari com base apenas no feedback de recompensa da pontuação. Isso foi possível graças a algoritmos aprimorados, processadores mais rápidos, conjuntos de dados maiores e grandes investimentos de empresas como a Google. Isso levou a avanços surpreendentes, muito mais rápidos do que o esperado.

Mas esses são apenas jogos. Estaria a inteligência geral das máquinas ainda longe? Talvez, mas talvez não. É realmente difícil prever o futuro da tecnologia, e muitas das tentativas anteriores foram totalmente furadas. No entanto, muitas pesquisas de opiniões feitas com especialistas da área atribuem uma probabilidade significativa de desenvolvimento de uma IA poderosa ainda durante nossas vidas.

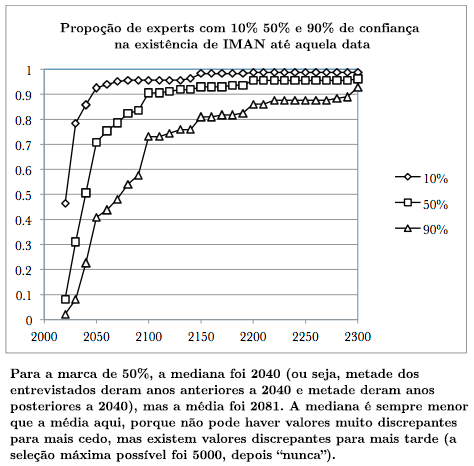

Uma pesquisa com os 100 pesquisadores de ciência da computação mais citados, dos quais 29 responderam, descobriu que mais da metade deles concordava que havia mais de 50% de chance de, até o ano 2050, alcançarmos uma “inteligência de máquina de alto nível” (definida como uma inteligência que pudesse realizar a maioria das profissões humanas ao menos tão bem quanto um ser humano típico) e uma chance maior do que 10% disso acontecer até 2024 (veja a figura abaixo).210

3.2.Quando alcançarmos uma IA superinteligente ela poderá ter enormes impactos, positivos e negativos

Se os especialistas estiverem certos, um sistema de IA que atinja e exceda as capacidades humanas poderia ter impactos muito grandes, tanto positivos quanto negativos. Se a IA alcançar a maturidade em campos como a pesquisa matemática ou científica, tais sistemas poderiam nos ajudar a progredir rapidamente na cura de doenças ou a projetar robôs para atender às necessidades humanas.

Por outro lado, muitas pessoas se preocupam com os efeitos sociais disruptivos desse tipo de inteligência de máquina e, em particular, com sua capacidade de assumir trabalhos anteriormente feitos por trabalhadores menos qualificados. Se a economia for incapaz de criar novos empregos para essas pessoas com rapidez suficiente, haverá desemprego generalizado e queda nos salários.11 Esses resultados poderiam ser evitados por meio de políticas governamentais, mas isso exigiria um planejamento significativo.

No entanto, esses não são os únicos impactos que máquinas altamente inteligentes poderiam ter.

O professor Stuart Russell, autor do principal livro didático sobre inteligência artificial, escreveu:12

O sucesso traz grandes riscos. … A combinação de desalinhamento [de objetivos] com sistemas de tomada de decisões cada vez mais capazes pode levar a problemas – talvez até mesmo problemas do fim de nossa espécie, se as máquinas forem mais capazes que os humanos.

Aqui está um exemplo altamente simplificado desta preocupação:

Os proprietários de uma empresa farmacêutica usam algoritmos de aprendizado de máquina (machine learning) para gerar e avaliar rapidamente novos compostos orgânicos.

À medida que os algoritmos melhoram sua capacidade, torna-se cada vez menos prático manter os humanos envolvidos no trabalho dos algoritmos – até por que as ideias dadas pelos humanos são quase sempre piores. Como resultado, o sistema recebe cada vez mais autonomia no projeto e execução de experimentos em novos compostos.

Eventualmente, atribuem a estes algoritmos o objetivo de “reduzir a incidência de câncer”. Os algoritmos oferecem então um composto cujos testes iniciais demonstraram alta eficácia na prevenção do câncer. Vários anos depois essa droga passou a ser usada universalmente como uma medida preventiva contra o câncer …

… Até que um dia, anos depois, um relógio molecular embutido no composto faz com que ele produza uma toxina potente que, de imediato, mata qualquer um com traços da substância em seus corpos.

O algoritmo concluiu que o composto mais eficaz em conduzir as taxas de câncer para 0 foi aquele que mata os seres humanos antes que eles venham a envelhecer o suficiente para desenvolver câncer. O sistema também previu que seu medicamento só atingiria esse objetivo se fosse amplamente usado,. Deste modo, combinou a toxina com uma droga útil que incentivaria a adoção generalizada do “medicamento”.

Naturalmente, a preocupação não é especificamente com esse exemplo, mas com consequências não intencionais semelhantes. Estas preocupações ressurgem em praticamente qualquer objetivo que os pesquisadores poderão vir a oferecer para análise por uma máquina superinteligente. 13 Tudo que se faz necessário é que uma única máquina superinteligente no mundo receba uma instrução mal elaborada para termos um grande risco em mãos.

Quanto mais inteligente for um sistema, mais difícil será para os humanos exercerem uma supervisão significativa. E, como no cenário acima, uma máquina inteligente poderia desejar manter os humanos no escuro, se ocultar suas ações reduz o risco de que os humanos interfiram no alcance da meta que lhe foi colocada.

Você pode pensar “por que não podemos simplesmente desligá-lo?”, Mas é claro que um sistema inteligente dará todas as indicações de que está fazendo exatamente o que queremos, até que tenha certeza de que não conseguiremos mais desativá-lo.

Uma máquina inteligente pode “saber” que o que está fazendo não é aquilo que os humanos pretendiam que ela fizesse, mas isso simplesmente não é relevante. Tal como um míssil à procura de calor segue objetos quentes, uma inteligência de máquina fará exatamente, e literalmente, o que inicialmente a programamos para fazer. Infelizmente, ela ter inteligência não significa necessariamente que ela compartilha de nossos objetivos. Como resultado disso, ela pode facilmente tornar-se “monomaníaca” em busca de um objetivo final totalmente estúpido.

A solução é descobrir como garantir que as instruções que damos a uma inteligência de máquina realmente capturem o que queremos que ela faça, sem nenhum resultado indesejado. Isso é o que chamamos de uma solução para o “problema de controle”(control problem) ou problema de “alinhamento de valores”(value alignment).

É difícil imaginar uma questão de pesquisa mais importante. Resolver o problema do controle pode significar a diferença entre enorme riqueza, felicidade e saúde e a destruição das condições que permitem à humanidade prosperar.

3.3.Poucas pessoas estão trabalhando no problema

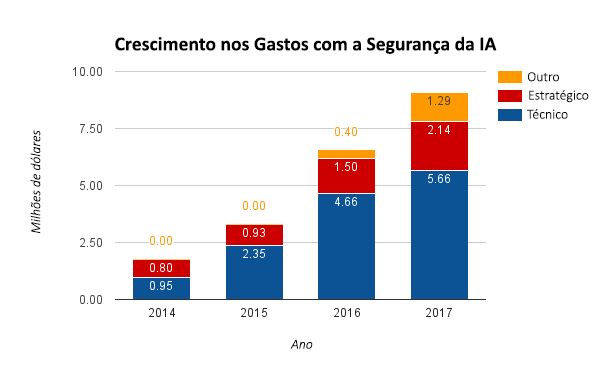

Embora o que está em jogo pareça enorme, o esforço que está sendo colocado em evitar esses riscos é pequeno. Os gastos globais em pesquisa e ação para garantir que a inteligência da máquina seja desenvolvida com segurança foram de apenas US$ 9 milhões em 2017.6 Em comparação, mais de 100 vezes é gasto tentando acelerar o desenvolvimento da inteligência de máquina5 e 26.000 vezes mais é gasto com pesquisa biomédica.14

Dito isso, o campo de pesquisa em segurança de IA está crescendo rapidamente – em 2015, o gasto total tinha sido de apenas US$ 3 milhões.

Pesquisa técnica refere-se ao trabalho em matemática e IA para resolver o problema de controle. A pesquisa de estratégia está focada em questões mais amplas sobre como desenvolver com segurança a IA, por exemplo, como ela deve ser regulamentada.

Como tão poucos recursos foram aplicados neste trabalho até agora, podemos esperar um progresso bastante rápido desde o início: as descobertas mais fáceis e úteis ainda estão disponíveis para que você dê sua contribuição. E o problema tornou-se mais urgente nos últimos anos devido ao aumento do investimento e progresso no desenvolvimento de inteligência de máquina.

3.4.Existem maneiras claras de progredir neste problema

Como seria de se esperar, o investimento recente em pesquisa técnica sobre o problema de controle já produziu resultados significativos. Nós detalhamos algumas dessas descobertas nesta nota de rodapé.15 Embora alguns dos problemas técnicos tenham sido resolvidos, hoje temos uma visão muito mais clara do que há alguns anos atrás de como sistemas inteligentes podem dar errado (o que também é o primeiro passo para uma solução).3

Houve também progressos recentes no sentido de compreender melhor as questões “estratégicas” mais amplas em torno da IA. Por exemplo, tem havido pesquisas sobre como o governo deveria responder à IA, tal como corridas armamentistas,16 implicações de compartilhar pesquisas abertamente,17 e os critérios que deveriam ser avaliados na formulação de políticas para a IA.18 Dito isto, ainda há muito pouco escrito sobre esses tópicos, o que significa que mesmo um único artigo técnico ou cientifico pode vir a ter uma grande contribuição para essa literatura.

Mesmo que – como alguns argumentaram – pesquisas significativas não fossem possíveis no momento, ainda seria possível construir uma comunidade dedicada a mitigar esses riscos em um momento futuro, quando progredir nestes problemas será mais fácil. Mesmo o trabalho de pessoas que não atuam tecnicamente no problema tem ajudado a expandir muito o financiamento e o interesse no campo, contribuindo para o recente e rápido crescimento dos esforços para enfrentar o problema.

Exemplo: Paul Christiano usou suas habilidades matemáticas para enfrentar desafios técnicos

Paul Christiano foi um excelente estudante de matemática que se mudou para Berkeley para aprender mais sobre pesquisas de segurança em inteligência de máquinas há vários anos. Desde então, ele fez pesquisas em teoria da aprendizagem e escreveu independentemente sobre pesquisa de segurança em IA. Isso levou a OpenAI, que futuramente contará com US$ 1 bilhão em doações (prometidas) para financiar o desenvolvimento de uma IA segura, a oferecer-lhe um emprego. Desde então, ele ajudou a esclarecer precisamente alguns dos desafios técnicos envolvidos em tornar a IA segura, facilitando a contribuição de outros para resolvê-los.

4.Quais são os principais argumentos contra considerar que esse é um problema urgente?

4.1.Nem todos concordam que existe um problema com a Inteligência Artificial

Aqui estão alguns exemplos de contra-argumentos:

- Alguns argumentam que uma inteligência de máquina além das capacidades humanas está muito distante. Para exemplos deste debate, veja Não, os especialistas não pensam que uma Inteligência Artificial Superinteligente é uma ameaça à humanidade na MIT Technology Review, e as respostas Sim, estamos preocupados com o risco existencial da Inteligência Artificial, e o FAQ do AI.

- Alguns acreditam que a inteligência artificial, mesmo que seja muito mais inteligente do que os seres humanos em alguns aspectos, nunca terá a oportunidade de causar destruição em escala global. Para um exemplo disso, veja o economista Robin Hanson, que acredita que as máquinas se tornarão melhores do que os humanos em todas as tarefas e nos superarão, mas que o processo será gradual e distribuído o suficiente para garantir que nenhum ator esteja em posição de tornar-se particularmente influente. Suas opiniões são detalhadas em seu livro The Age of Em.19

- Alguns acreditam que será muito fácil fazer com que o sistema inteligente aja de acordo com nossos interesses. Para um exemplo disso, veja Holden Karnofsky argumentando em 2012 que poderíamos projetar IAs para funcionar como ferramentas passivas em vez de agentes ativos (contudo, desde então ele mudou significativamente de opinião e agora represente um dos principais financiadores deste campo de pesquisa).

- Neil Lawrence, um acadêmico na área de machine learning, discorda de muitas previsões no livro Superinteligência de Bostrom, incluindo nossa capacidade de fazer previsões significativas quanto ao futuro distante.

É um alívio o fato de não termos um consenso se uma IA mais esperta do que os humanos está próxima de se tornar realidade e se será perigosa. No entanto, dado que uma fração significativa e crescente de especialistas relevantes está preocupada, torna-se uma questão prudente de gerenciamento de risco investir esforços neste problema, caso eles estejam certos. Você não precisa ter 100% de certeza de que sua casa vai queimar para comprar um seguro contra incêndio.

Nós não somos os mais qualificados para julgar, contudo, nós olhamos para as questões substantivas e nos encontramos em maior concordância com aqueles que estão mais preocupados do que menos.

4.2.Pode ser muito cedo para trabalhar nisso

Se o desenvolvimento da inteligência de máquina em nível humano está a centenas de anos de distância, então pode ser prematuro pesquisar como alinhá-la com os valores humanos. Por exemplo, os métodos usados para construir inteligência de máquina podem acabar sendo completamente diferentes daqueles que usamos para desenvolver a IA agora, tornando a pesquisa de hoje obsoleta.

No entanto, as pesquisas com cientistas da computação mostram que há uma chance significativa – talvez em torno de 10% – de que a IA de nível humano chegue em 10 a 20 anos. Vale a pena começar agora, caso este cenário acelerado se prove correto.

Além disso, mesmo que soubéssemos que a IA do nível humano está a pelo menos 50 anos de distância, não sabemos quão difícil será resolver o “problema do controle”. A solução pode exigir uma série de insights que vêm naturalmente, um após o outro. Quanto mais esses insights forem construídos antes do tempo, mais provável será que seremos capazes de chegarmos a solução do problema rapidamente, uma vez que a natureza da IA se torne clara.

Além disso, ao agirmos hoje poderemos moldar a infra-estrutura necessária para agir mais tarde, mesmo que a pesquisa de hoje não seja diretamente útil.

4.3.Pode ser muito difícil de resolver

Tal como acontece com muitos projetos de pesquisa em seus estágios iniciais, não sabemos o quão difícil será resolver este problema. Alguém pode, por exemplo, acreditar que há grandes riscos na inteligência de máquina, mas ser pessimista quanto a capacidade de pesquisas adicionais ajudarem no problema e por isso decidir não se dedicar a este problema.

4.4.Pode não se encaixar nas suas habilidades

Muitos indivíduos estão preocupados com esse problema mas acham que suas aptidões não são as melhores para trabalhar nele e, portanto, irá se dedicar a trabalhar em outra atividade. É provável que isso seja verdade para funções de pesquisa técnica pesadas em matemática, embora abaixo descrevamos também funções operacionais e de suporte que são adequadas para uma faixa mais ampla de pessoas.

4.5.Resumindo

- Provavelmente será possível projetar uma máquina que seja tão boa na realização de seus objetivos quanto os humanos, inclusive em tarefas “sociais” que as máquinas que temos hoje tem péssimo desempenho. Especialistas em inteligência artificial atribuem mais de 50% de chance de isso acontecer no século XXI.

- Se não desenvolvermos um projeto cuidadoso para que essas tecnologias tenham confiabilidade e robustez, a inteligência de máquina pode fazer as coisas de maneira muito diferente do que os seres humanos pretendiam que ela fizesse – incluindo a execução de políticas que têm um impacto catastrófico no mundo.

- Mesmo que a inteligência da máquina avançada não fique “fora de controle”, é provável que ela seja socialmente muito destrutiva e possa ser usada como uma arma de guerra desestabilizadora.

- Não se sabe quão rapidamente o progresso na resolução deste problema poderá ser alcançado – pode ser rápido ou lento.

5.O que você pode fazer para ajudar?

Nós dividimos essa seção em cinco partes, cobrindo os principais caminhos para fazer a diferença nessa área.

5.1.Pesquisa técnica

Em última análise, o problema exigirá uma solução técnica – os humanos precisarão encontrar uma maneira de garantir que as máquinas sempre entendam e cumpram o que realmente queremos que elas façam. Mas poucas pessoas são capazes de pesquisar esse problema e, atualmente, há um excedente de financiamento e falta de pesquisadores.

Então, se você pode se considera apto para esse tipo de pesquisa, pode ser uma das coisas de maior impacto que você pode fazer com sua vida.

Pesquisadores nessa área trabalham principalmente em universidades e empresas de tecnologia, como o Google Deepmind ou OpenAI. Você pode ser um bom candidato a trabalhar nesse problema se for capaz de concluir um doutorado em um dos 10 melhores programas de ciência da computação existentes ou em um curso similar, na área de exatas (embora não seja imprescindível ter esse histórico). Nós discutimos este caminho em mais detalhes no link a seguir:

REVISÃO DE CARREIRA DE PESQUISA TÉCNICA EM IA

5.2.Pesquisas em estratégias e políticas voltadas ao tema da Inteligência Artificial

Se melhorias na inteligência artificial vierem a representar as mudanças mais importantes do século XXI, os governos certamente terão grande interesse no assunto. Por essa razão, há muito interesse em pesquisa estratégica e política – tentativas de prever como uma transição para uma inteligência de máquina mais inteligente do que a humana poderia ocorrer, e qual deveria ser a resposta dos governos e outras instituições importantes.

Este é um campo enorme, mas alguns dos principais problemas incluem:

- Como devemos responder ao desemprego tecnológico no caso de os sistemas inteligentes substituírem rapidamente os trabalhadores humanos?

- Como evitamos uma ‘corrida armamentista’ na qual países ou organizações correm para desenvolver fortes inteligências de máquina, visando obter uma vantagem estratégica, tal como ocorreu com as armas nucleares?

- Quando (se é que) deveríamos esperar que a IA alcançasse certas capacidades específicas ou alcançasse inteligência de nível humano?

Se lidarmos mal com esses problemas, isso poderá levar ao desastre, mesmo que possamos resolver os desafios técnicos associados ao controle de uma inteligência de máquina. Portanto, há uma necessidade real de mais pessoas trabalharem nestas questões.

Nós discutimos este caminho em detalhes aqui:

GUIA PARA AS CARREIRAS ESTRATÉGIAS E DE ELABORAÇÃO DE POLÍTICAS VOLTADAS A IA

5.3.Papéis Complementares

Mesmo em um centro de pesquisa, cerca da metade da equipe fará outras tarefas não relacionadas a pesquisa, igualmente essenciais para a organização continuar funcionando e ter impacto. Ter pessoas de alto desempenho nessas funções é essencial. Uma equipe melhor permitirá que a organização cresça mais rapidamente, evite grandes erros e tenha um impacto maior ao comunicar suas ideias a mais pessoas.

Nossa impressão é que a importância desses papéis é subestimada porque o trabalho é menos visível. Algumas das pessoas que já fizeram as maiores contribuições para resolver esse problema o fizeram como comunicadores e gerentes de projeto. Além disso, esses papéis são adequados para um grande número de pessoas.

Organizações que trabalham com segurança em IA precisam de uma ampla gama de habilidades complementares:

- RH;

- Gestão de pessoal;

- Gerenciamento de Projetos;

- Gestão de eventos;

- Mídia e comunicação;

- Designer visual e webdesign;

- Contabilidade.

Esse caminho está aberto a muitas pessoas que podem desempenhar, com bastante qualidade, essas habilidades.

Para ocupar esses papéis, você deve almejar empregos semelhantes em organizações que são conhecidas por exigir trabalho de alta qualidade e que investem no treinamento de seus funcionários. Temos mais sobre como se aprimorar em nosso artigo sobre capital de carreira.

Exemplo: Seán Ó Heigeartaigh ajudou no crescimento do Future of Humanity Institute

Seán Ó hÉigeartaigh foi o Gerente de Projeto Acadêmico (e mais tarde, Gerente Acadêmico Sênior) no Future of Humanity Institute durante 2011-15, enquanto seu Diretor estava focado em escrever um livro. Ele desempenhou um papel crucial ao garantir que o Instituto funcionasse sem problemas, mais do que duplicou seu financiamento, foi responsável por financiar diversas pesquisas bem-sucedidas, incluindo vários subsídios relevantes para a pesquisa estratégica de IA, e comunicou sua pesquisa à mídia, aos formuladores de políticas públicas e aos parceiros da indústria. Durante sua gestão, a equipe da FHI cresceu de 5 para 16 funcionários. Ele implementou e supervisionou uma equipe de gerentes de projeto e administradores, incluindo um Diretor de Pesquisa e Diretor de Operações para quem transferiu suas responsabilidades ao sair do instituto. Sua experiência com a FHI permitiu a ele ser um peça-chave na fundação do Centro de Cambridge para o Estudo do Risco Existencial e, mais tarde, no Centro para o Futuro da Inteligência. Leia mais…

5.4.Ativismo político e fortalecimento institucional (advocacy and capacity building)

As pessoas que são relativamente boas em habilidades sociais podem ter um impacto maior ao persuadir outras pessoas a trabalhar ou financiar esse problema. Isso geralmente é feito trabalhando-se em uma das organizações de pesquisa já mencionadas.

Além disso, sabemos que o grupo mais dedicado a aumentar a conscientização sobre a questão é a comunidade de altruísmo eficaz, da qual fazemos parte. Juntar-se a esse movimento e ajudá-lo a crescer é uma maneira promissora de aumentar os esforços para resolver o problema de controle da IA, entre outros problemas urgentes.

Uma vez familiarizado com o problema, você também pode gastar um pouco do seu tempo divulgando-o. Para isso, poderá seguir qualquer uma das carreiras que normalmente fornecem uma boa plataforma para ativismo, tais como:

- Jornalista e Escritor

- Trabalho com partidos políticos

- Serviço público orientado para formação de políticas públicas

- Universidades.

Você também pode subir nas fileiras de uma organização que esteja desenvolvendo algum trabalho relevante para a questão da IA, tal como o Google ou as forças armadas*, e promover a preocupação com a segurança da IA. (*Os autores fazem referência explicita as forças armadas americanas. É de supor que a influência nas forças armadas brasileiras seria pouco relevante, dado a falta de protagonismo nacional na questão da IA).

No entanto, a menos que você esteja fazendo a pesquisa técnica, estratégica ou política descrita acima, você provavelmente só poderá gastar uma fração de seu tempo de trabalho atuando na questão da IA.

Também gostaríamos de alertar que é fácil causar danos ao se engajar no ativismo com relação aos problemas da IA. Se retratada de uma maneira sensacionalista, ou por alguém sem a necessária compreensão técnica, o ‘ativismo’ poderá, na verdade, causar confusão e tornar a questão menos digna de confiança. Muita da cobertura na mídia representa de modo bem errado quais as reais preocupações dos especialistas. Para evitar contribuir para esse erro, recomendamos veementemente que você se informe muito bem e apresente qualquer dado e ideia de maneira sóbria e precisa.

Exemplo: Niel mudou da física para o gerenciamento de pesquisa

Niel Bowerman estudou Física na Universidade de Oxford e planejava tentar trabalhar com política para o clima (aquecimento global). Mas, por ter se deparado com as idéias acima, ele mudou sua carreira e tornou-se o Diretor Assistente no Future of Humanity Institute, trabalhando nas operações do Instituto, na captação de recursos e divulgação da pesquisa. Por meio deste trabalho, Niel ajudou a levantar 3 milhões de libras para o Instituto, contribuindo para dobrar seu tamanho. Como resultado, eles conseguiram contratar uma série de excelentes pesquisadores, técnicos e estratégicos, adicionais. (Leia a história de Niel)

5.5.Ganhando para doar

Existe um montante crescente de financiamento disponível para pesquisa nesta área e esperamos que mais financiadores de grande porte entrem no campo no futuro. Isso significa que o problema está, principalmente, limitado pela necessidade de talentos – especialmente pela necessidade de pesquisadores inovadores.

No entanto, ainda existem algumas lacunas de financiamento, especialmente para os grupos menos convencionais que não podem obter bolsas acadêmicas, tal como o Machine Intelligence Research Institute (MIRI).

Como resultado, ganhar para doar e assim apoiar outros que trabalham diretamente no problema ainda é uma opção razoável caso não entenda que os outros papéis descritos aqui são adequados para você.

Se você quiser doar, nossa primeira sugestão é dar ao Fundo de Longo Prazo para o Futuro. O gestor do fundo é especialista em financiamento de riscos catastróficos e concede subvenções às organizações que mais necessitam de financiamento no momento. É administrado pelo Centre for Effective Altruism, do qual fazemos parte.

PARA DOAR PARA O FUNDO DE LONGO PRAZO PARA O FUTURO ACESSE AQUI

Alternativamente, você pode escolher entre as principais organizações sem fins lucrativos da região, como o Machine Intelligence Research Institute (Instituto de Pesquisa em Inteligência de Máquinas) em Berkeley e o Future of Humanity Institute em Oxford. Estas foram as opções mais populares entre os especialistas em nossa análise de dezembro de 2016. Veja mais organizações abaixo.

6.Quais são as principais organizações nas quais você poderia trabalhar?

Mantemos uma lista de todas as organizações que sabemos que estão trabalhando na segurança da IA, com links para suas páginas de vagas, aqui. As organizações mais significativas, que seriam bons lugares para trabalhar, provavelmente são as seguintes:

- O Google DeepMind é provavelmente o maior e mais avançado grupo de pesquisa que desenvolve inteligência de máquinas em geral. Inclui um número razoável de funcionários que trabalham especificamente em questões de segurança e ética. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas. Google Brain é outro projeto de pesquisa de aprendizagem profunda no Google. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas.

- O Future of Humanity Institute da Universidade de Oxford foi fundado pelo Prof Nick Bostrom, autor do livro Superinteligência. Tem funcionários acadêmicos conduzindo pesquisas técnicas e estratégicas. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas.

- A OpenAI foi fundada em 2015 com o objetivo de realizar pesquisas sobre como tornar a IA segura e compartilhar livremente as informações. Recebeu US $ 1 bilhão em “compromissos de financiamento” vindos da comunidade de tecnologia. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas.

- O MIRI ( Machine Intelligence Research Institute ) foi um dos primeiros grupos a se preocupar com os riscos da inteligência de máquinas no início dos anos 2000 e publicou vários artigos sobre questões de segurança e como resolvê-las. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas.

- O Cambridge Centre for the Study of Existential Risk (Centro de Cambridge para o Estudo de Riscos Existenciais) e o Leverhulme Centre for the Study for the Future of Intelligence (Centro Leverhulme para o Estudo para o Futuro da Inteligência) na Universidade de Cambridge estudam tanto questões técnicas quanto estratégicas relacionadas à segurança da IA. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas.

- O Berkeley Center for Human-Compatible Artificial Intelligence é muito novo, mas pretende realizar pesquisas principalmente técnicas, com um orçamento de vários milhões de dólares por ano. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas.

- O Future of Life Institute (Instituto do Futuro da Vida), do MIT, faz um trabalho combinado de comunicar e realizar doações para organizações no espaço de segurança da IA, além de trabalhar nos riscos da guerra nuclear e das pandemias. Veja as vagas atuais e se inscreva para ser notificado sobre novas vagas.

- O grupo de pesquisa de Alan Dafoe na Universidade de Yale está conduzindo pesquisas sobre a “política global da IA”, incluindo seus efeitos sobre conflitos internacionais. Posições para doutores e assistentes de pesquisa podem estar disponíveis.

- A AI Impacts é uma organização sem fins lucrativos que trabalha na predição do progresso da inteligência de máquina e na previsão de seus impactos prováveis.

- O Center for a New American Security (Centro para uma Nova Segurança Americana) é um centro de pesquisas (think tank) em Washington DC que tem um programa chamado Inteligência Artificial e Iniciativa Global de Segurança. Sua agenda de pesquisa é amplamente focada em questões de longo prazo.

7.Lista de todos os nossos artigos sobre inteligência artificial

Oferecemos vários outros recursos sobre carreiras relacionadas à IA. Aqui estão eles, na ordem em que você pode lê-los naturalmente:

- Introdução à forma como tentamos priorizar os problemas do mundo e onde a IA se encaixa neste quadro maior

- Este próprio artigo que você está lendo, quanto ao problema em modelar positivamente a inteligência artificial – por que achamos que esse problema é urgente e o que pode ser feito a respeito

- Guia para seguir uma carreira em pesquisa técnica de segurança em IA

- Guia para seguir uma carreira em estratégia e política de IA

- AI Safety Syllabus – uma compilação de coisas úteis para ler para aprender mais, bem como lugares para estudar e conferências para participar.

- Engenharia de “aprendizado de máquina”(machine learning) para segurança e robustez da IA: um guia do engenheiro do Google Brain para entrar neste campo.

Complementar a esses artigos, também temos uma série de entrevistas com pessoas trabalhando ativamente para moldar positivamente o desenvolvimento da inteligência artificial:

- Dr. Paul Christiano, sobre como a OpenAI está desenvolvendo soluções reais para o “problema de alinhamento da IA”, e sua visão de como a humanidade irá progressivamente transferir a tomada de decisões para sistemas de IA

- Prof Allan Dafoe sobre como tentar preparar o mundo para a possibilidade de que a IA desestabilize a política global.

- O mundo precisa de pesquisadores de IA. Veja como se tornar um, diz o Dr. Dario Amodei da OpenAI.

- O mundo precisa desesperadamente de estrategistas de inteligência artificial. Veja como se tornar um.

- A fundação mais intelectual do mundo está contratando. Holden Karnofsky, fundador da GiveWell, sobre como a filantropia pode vir a ter o máximo de impacto, assumindo grandes riscos (inclui uma discussão de seu trabalho em moldar positivamente o desenvolvimento da IA).

- Doutorado ou programação? Caminhos rápidos para alinhar a IA como engenheiro de “aprendizado de máquina”(machine learning), de acordo com os engenheiros da ML Catherine Olsson & Daniel Ziegler

- Um pesquisador de alinhamento de machine learning sobre como se tornar um pesquisador do problema de alinhamento.

Você também poderá ler nossas revisões de carreira de PhDs de Machine Learning e Data Science.

8.Saiba mais

As duas principais fontes introdutórias são:

- A palestra do Prof Bostrom sobre o problema e o que pode ser feito a respeito.

- A Revolução da Inteligência Artificial, por Tim Urban em Wait But Why. (E também veja essa resposta a seu artigo).

Depois disso:

- O principal trabalho que descreve detalhadamente este problema é o livro Superinteligência. Se você não está pronto para um livro completo, tente este artigo mais técnico de Michael Cohen.

- Se você deseja fazer uma pesquisa técnica, nosso programa de segurança em IA lista uma variedade de fontes de informações técnicas sobre o problema. É ideal trabalhar detalhadamente esses artigos durante um bom tempo.

9.Notas e referências

1. Gráfico produzido por Maddison, Angus (2007): “Contornos da Economia Mundial, 1 – 2030 dC. Ensaios na História Macroeconômica”, Oxford University Press, ISBN 978-0-19-922721-1, p. 379, tabela A.4.

2. Uma carta pública indicando preocupação com os riscos foi assinada na conferência de 2015 em Porto Rico, organizada pelo Future of Life Institute. Aqui está uma cópia arquivada da carta, recuperada em 10 de março de 2017.Os signatários incluem Stephen Hawking e Stuart Russell, que é o autor de AI: A Modern Approach, que é o livro mais vendido sobre IA.Veja esse artigo para mais detalhes sobre questionários feitos com especialistas sobre quando a IA de nível humano pode se tornar realidade: O que sabemos sobre cronogramas de inteligência artificial? Open Philanthropy Project, Última atualização de 2016.

3. Amodei, Dario, Chris Olah, Jacob Steinhardt, Paul Christiano, John Schulman e Dan Mané. “Problemas concretos na segurança da IA”. [1606.06565] Problemas concretos na segurança da IA. Arxiv, 25 de julho de 2016. Arquivo da Web.

4. Desafios a longo e curto prazo para garantir a segurança dos sistemas AI. Blog de Jacob Steinhardt. Arquivo da Web.

5. “Os gastos com tecnologias de IA feitos por empresas devem crescer para US$ 47 bilhões em 2020, de um total projetado de US$ 8 bilhões em 2016, segundo a IDC.”Norton, Steven. “Inteligência Artificial ganha destaque no mundo corporativo.” Wall Street Journal. Dow Jones & Company, 11 de janeiro de 2017. Rede. 03 de março de 2017. Arquivo da Web.

6. Mudanças no financiamento do campo de segurança da IA. Seb Farquhar, fevereiro de 2017. Nossa estimativa de ‘menos de 100 pessoas trabalhando com o problema de controle e alinhamento de valores na IA’ é baseada em uma contagem informal de pessoas que realizam trabalhos diretamente relevantes nas organizações listas neste artigo, que é significativamente abaixo de 100. Verificamos isso estimando o custo por funcionário em tempo integral: a previsão de gastos de US $ 9 milhões em 2017 não seria suficiente para sustentar mais de 100 funcionários, devido ao alto custo de contratar pesquisadores em aprendizado de máquina(machine learning). Observe que esse número pode ser impreciso se houver um projeto de segurança de IA grande e que não seja público, mas achamos que isso improvável.

7. Russell, Allan Dafoe e Stuart. “Sim, os especialistas estão preocupados com o risco existencial da inteligência artificial”. Revisão de Tecnologia do MIT. 02 de novembro de 2016. Acesso em 01 mar. 2017. Web

8. Inteligência artificial: podemos controlá-la? John Thornhill no Financial Times. Julho de 2016. Web

9. Humanos lamentam a perda depois que o Google é revelado como sendo o mestre do jogo Go na China. Wall Street Journal, fevereiro de 2016. Arquivo da Web.

10. Müller, Vincent C. e Bostrom, Nick (2016), “Progresso futuro em inteligência artificial: Uma pesquisa de opinião de especialistas”, em Vincent C. Müller (ed.), Questões Fundamentais de Inteligência Artificial (Synthese Library; Berlin: Springer) 553-571. Arquivo da Web.

11. Armellini, Mauricio e Tim Pike. “Os economistas deveriam estar mais preocupados com a Inteligência Artificial?”Bank Underground. 24 de fevereiro de 2017. Acessado em 06 de março de 2017. Arquivo da Web.

12. O que você acha das máquinas que pensam? Edge essay, 2015.

13. Capítulos 9-11 de Bostrom, Nick. Superinteligência: Caminhos, Perigos, Estratégias. Oxford: Oxford UP, 2016. Impresso. Rede.

14. Chakma, Justin, Gordon H. Sun, Jeffrey D. Steinberg, Stephen M. Sammut e Reshma Jagsi. “Ascensão da Ásia – Tendências Globais em Despesas de P&D Biomédicas”. New England Journal of Medicine 370.1 (2014): 3-6. Web

15. Para um exemplo bastante fácil de entender, veja uma pesquisa recente da OpenAI descrevendo como “ fotos alteradas podem ser usadas para manipular sistemas de machine learning de maneiras perigosas e inesperadas. O paper Concrete Problems in IA Safety, de autoria de pesquisadores de machine learning no Google, OpenAI e Stanford, analisa uma série de problemas técnicos “que estão prontos para a experimentação hoje e relevantes para a tecnologia de ponta dos sistemas de IA”, mas “provavelmente robustamente útil em uma ampla variedade de riscos potenciais, tanto a curto como a longo prazo. ”Outro sinal de que há poucas oportunidades de impacto fácil nesta área é o recente desenvolvimento de novas estruturas formais e ambientes de teste para estudar problemas de segurança em cenários simples. Estes incluem ambientes de segurança na Academia OpenAI, as estruturas de indutores lógicos e de agentes modais, aprendizado de reforço inverso cooperativo e aprendizado de algoritmos por bootstrap para maximização de aprovação. Outro progresso recente em questões relevantes para a segurança inclui o trabalho sobre estimativa de risco não-supervisionada, engenharia de recompensa e aprendizagem de reforço inverso para agentes limitados. A aparente taxa de progresso atual sugere que mais progresso poderia ser alcançado se mais horas de pesquisa fossem dedicadas ao problema.

16. Stuart Armstrong, Nick Bostrom e Carl Shulman. “Correndo para o Precipício: Um Modelo de Desenvolvimento de Inteligência Artificial.” AI & Society 31.2 (2015): 201-06. Arquivo da Web

17. Bostrom, N. (2016): “Implicações Estratégicas da Abertura no Desenvolvimento da IA”, Relatório Técnico # 20161, Future of Humanity Institute, Universidade de Oxford: pp. Arquivo da Web.

18. Nick Bostrom, Allan Dafoe e Carrick Flynn. “Aspirações para a política de desenvolvimento da superinteligência de máquinas” Documento de trabalho. Arquivo da Web.

19. Hanson, Robin. A Era do Em: Trabalho, Amor e Vida quando os Robôs Governam a Terra. Oxford: Oxford University Press, 2016. Web

10.Material em Português

Já traduzimos uma parte da literatura deste problema para o português. Confira:

Não deixe que a indústria escreva as regras para IA

Fundamentos para considerar a Inteligência Artificial (IA) como uma ameaça séria à humanidade

Os Maiores Mitos sobre a Inteligência Artificial

As pessoas acreditam que a IA precisa de maior regulação

Steven Pinker sobre riscos da Inteligência Artificial (trecho do livro o Novo Iluminismo) – esse texto serve de contraponto ao argumento de que a IA representa um grande risco

Traduzido de: https://80000hours.org/problem-profiles/positively-shaping-artificial-intelligence/