Meta: fornecer uma síntese básica do que está acontecendo na governança longotermista de IA.

Audiência: pessoas que têm familiaridade limitada com a governança longotermista de IA e querem entendê-la melhor. Não espero que isso seja útil àqueles já familiarizados com o campo. Após a escrita: algumas pessoas já bem familiarizadas com o campo acharam esse texto bem útil.

Esta postagem descreve os diferentes tipos de trabalho que estão acontecendo na governança longotermista de IA. Para cada tipo de trabalho, irei explicá-lo, dar exemplos, esboçar algumas histórias sobre como isso pode vir a ter um impacto positivo e listar os atores que tenho ciência que estão trabalhando atualmente nesta atividade1.

Primeiro, algumas definições.

- Governança de IA significa criar normas, diretrizes políticas, leis, processos e instituições (não limitado a instituições governamentais) locais e globais que afetarão os resultados sociais provenientes da implementação de sistemas de IA2.

- Governança longotermista de IA, em particular, é um subconjunto desse trabalho que é motivado por uma preocupação com os impactos de IAs no muito longo prazo. Isso coincide consideravelmente com trabalhos que visam gerir a IA transformadora (IAT).

Vale a pena observar que a área da governança longotermista de IA é muito pequena. Meu palpite é que haja cerca de 60 pessoas trabalhando na governança de IA que estão motivadas por uma preocupação com impactos no muito longo prazo.

Índice

Breve resumo

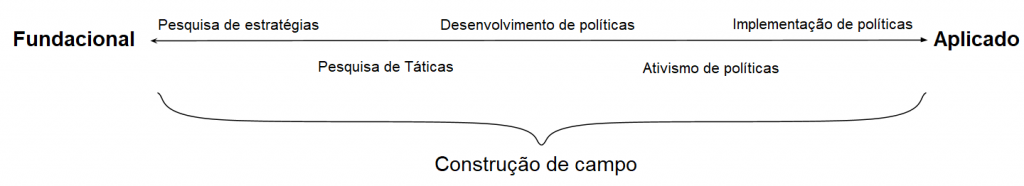

Em um nível abstrato, acho útil considerar que há um espectro que vai do trabalho Fundacional ao aplicado. Na ponta Fundacional, existe a pesquisa de estratégias, que visa identificar boas metas de alto nível para a governança longotermista de IA; daí existe a pesquisa de táticas, que visa identificar planos que ajudarão a alcançar essas metas de alto nível. Aproximando-se da ponta aplicada, existe o trabalho de desenvolvimento de diretrizes políticas (N.T.: policy), que pega essa pesquisa e a traduz em diretrizes concretas; o trabalho que faz o ativismo (N.T.: advocacy) para que essas políticas sejam implementadas, e finalmente a efetiva implementação dessas políticas (por, p. ex., servidores públicos).

Também existe o trabalho de construção de campo (que não se encaixa claramente no espectro). Em vez de contribuir diretamente à resolução do problema, esse trabalho visa construir um campo de pessoas que estão fazendo um trabalho valioso na resolução do problema.

Claro que essa classificação é uma simplificação e absolutamente nem todo trabalho se ajustará perfeitamente bem numa só categoria.

Poderíamos pensar que insights fluem predominantemente da ponta mais fundacional para a ponta mais aplicada do espectro, mas também é importante que a pesquisa seja sensível a preocupações relativas a diretrizes políticas, p. ex., a consideração sobre quão provável é que a nossa pesquisa informe uma proposta política que seja politicamente viável.

Agora passaremos por cada um desses tipos de trabalho em mais detalhes.

Pesquisa

Pesquisa de estratégias

A pesquisa de estratégias no longotermismo em IA, em última análise, visa identificar metas de alto nível que poderíamos buscar e que, se alcançadas, claramente aumentariam as probabilidades de bons resultados posteriores vindas das IAs avançadas, de uma perspectiva longotermista (seguindo Muehlhauser, às vezes chamarei essa meta de “conseguir clareza estratégica”).

Esta própria pesquisa pode variar num espectro entre direcionada e exploratória da seguinte forma.

- Pesquisa direcionada de estratégias responde questões que iluminam algumas outras questões específicas, importantes e conhecidas:

- p. ex., “Quero descobrir quanto de computação o cérebro humano utiliza, pois isso me ajudará a responder a questão sobre quando a IAT será desenvolvida (o que afeta quais objetivos de alto nível devemos buscar).”

- Pesquisa exploratória de estratégias responde questões sem uma noção muito precisa de quais outras questões importantes elas nos ajudam a responder:

- p. ex., “Quero descobrir como é a política industrial da China, pois isso provavelmente irá me ajudar a responder um monte de questões estratégicas importantes, embora eu não saiba exatamente quais.”

Exemplos

- Trabalho em previsão da IAT, p. ex., âncoras biológicas e leis de escala (scaling laws) para modelos de linguagem neurais.

- Exemplo de relevância estratégica: se a IAT vier logo, vagarosamente fazer crescer um campo de especialistas parece uma estratégia menos promissora; se a IAT estiver muito longe, então a governança longotermista de IA provavelmente deveria ser, relativamente, despriorizada.

- Trabalho no esclarecimento das fontes de riscos existenciais (riscos-x) de IA, p. ex., nos escritos de Christiano, Critch, Carlsmith, Ngo e Garfinkel.

- Exemplo de relevância estratégica: se a maior parte dos riscos-x vier de agentes de IA desalinhados, a governança deveria focar em influenciar os primeiros atores que vierem a construí-los.

- Trabalho na investigação da velocidade do progresso em torno da IAT, p. ex., a investigação e análise feita pela AI Impacts.

- Exemplo de relevância estratégica: se o progresso na IA ocorrer descontinuamente, é provável que haja somente um pequeno número de atores de alto risco, e a maior parte do valor da governança virá ao influenciar esses atores.

É fácil confundir pesquisa de estratégias (e, especialmente, pesquisa exploratória de estratégias) com pesquisa de escopo amplo. Como mostram muitos dos exemplos acima, pesquisa de estratégias pode ser de escopo restrito — ou seja, pode responder uma questão bastante restrita. Exemplos de questões de escopo amplo vs. restrito:

- Sobre as leis de escala (scaling laws):

- Questão ampla: em geral, como o desempenho dos modelos de aprendizado profundo muda conforme aumentamos o tamanho desses modelos?

- Questão mais restrita: como o desempenho específico de grandes modelos de linguagem (p. ex., GPT-3) muda conforme mudamos o tamanho desses modelos? (A questão tratada neste artigo).

- Sobre fontes de riscos-x de IA:

- Questão ampla: quanto de risco-x representam as IAs avançadas em geral?

- Questão mais restrita: quanto de risco-x representam especificamente os agentes que buscam influência? (A questão tratada neste relatório).

De fato, acho com frequência melhor atacar questões de escopo restrito, especialmente para pesquisadores juniores, pois tendem a ser mais tratáveis.

Luke Muehlhauser tem algumas recomendações para aqueles que querem tentar este tipo de trabalho: veja o ponto 4 nesta postagem. E veja esta postagem para alguns exemplos de questões abertas de pesquisa3.

Narrativas para impacto

- Impacto direto: há muitas metas possíveis na governança de IA, e precisamos priorizar as mais importantes. Este trabalho é frequentemente motivado pelas impressões dos pesquisadores de que há muito pouca clareza sobre aqueles tópicos que afetam quais são as metas que devemos buscar. Por exemplo, vemos os resultados destas pesquisas de opinião que mostram um amplo desacordo sobre cenários de riscos-x de IA e a quantidade total de riscos-x, respectivamente.

- Impacto indireto:

- Construção de campo: termos um entendimento claro do que estamos buscando alcançar e por que importa ajudaria a atrair mais gente a esse campo.

- Comunicar a necessidade de mudança de políticas: se queremos convencer as pessoas a fazerem coisas custosas ou dramáticas no futuro, é melhor que tenhamos um discurso claro sobre o que estamos buscando alcançar e porque isso importa.

Quem está fazendo isso?

Algumas pessoas nas seguintes organizações: FHI, GovAI, CSER, DeepMind, OpenAI, GCRI, CLR, Rethink Priorities, OpenPhil, CSET,4 além de alguns acadêmicos independentes.

Pesquisa de táticas

Pesquisas de táticas no longotermismo em IA visam identificar os planos que ajudarão a alcançar metas de alto nível (que a pesquisa de estratégias tenha identificado como sendo prioritárias). Ela tende a ter um escopo mais restrito por natureza.

Vale a pena observar que pode haver boas razões para fazer pesquisas de táticas mesmo se não tivermos identificado claramente algumas metas como sendo prioritárias: para o nosso próprio aprendizado, para a aquisição de capital de carreira e para auxiliar na construção de uma área de estudo acadêmica.

Exemplos

- A Cláusula do Lucro Inesperado (Windfall clause) (Veja uma definição aqui).

- Plano: desenvolver uma ferramenta para distribuir os benefícios da IA para o bem comum.

- Meta de alto nível que esse plano busca: reduzir incentivos para atores competirem entre si para ser o primeiro a desenvolver IA avançada; reduzir a desigualdade econômica.

- Mecanismos para Apoiar Alegações Verificáveis

- Plano: desenvolver práticas pelas quais desenvolvedores de IA poderiam tornar suas próprias alegações sobre desenvolvimento de IA mais verificáveis (isto é, alegações às quais os desenvolvedores possam responder)

- Metas de alto nível que esse plano busca: desenvolver mecanismos para demonstrar comportamento responsável de sistemas de IA; capacitar uma supervisão mais efetiva; reduzir a pressão para que “se dê um jeitinho” a fim de ganhar uma vantagem competitiva.

- IA & Antitruste

- Plano: propor modos de mitigar tensões entre o direito à concorrência e a necessidade de um desenvolvimento cooperativo da IA

- Meta de alto nível que esse plano busca: aumentar a cooperação entre empresas que desenvolvem IAs avançadas.

Narrativas para impacto

- Impacto direto: criar soluções que sejam utilizadas para ajudar a tomarmos melhores decisões (em futuras diretrizes políticas e pesquisas).

- Isso é o que Allan Dafoe chama o “Modelo de pesquisa direcionado ao produto”.

- Impacto indireto: mesmo se nem todas as soluções acabem utilizadas para ajudar a tomarmos melhores soluções, elas ajudarão a fazer crescer um campo de pessoas que se importam com questões de governança longotermista de IA, e a melhorar o insight, a expertise, as conexões e a credibilidade dos pesquisadores.

- Isso é o que Allan Dafoe chama o “Modelo de pesquisa direcionado à construção de campo”.

Quem está fazendo?

Algumas pessoas nas seguintes organizações: FHI, GovAI, CSER, DeepMind, OpenAI, GCRI, CSET, Rethink Priorities, LPP, além de alguns acadêmicos independentes.

Desenvolvimento, ativismo e implementação de políticas

A pesquisa de estratégias produz metas de alto nível. A pesquisa de táticas pega essas metas e emite planos para alcançá-las. O trabalho em desenvolvimento de diretrizes políticas (N.T: Policy) pega esses planos e os traduzem em recomendações de políticas que estejam prontas para serem entregues aos elaboradores de políticas. Isso requer descobrir (p. ex.) o que pedir exatamente, qual linguagem utilizar (tanto na diretriz formal quanto no pedido) e outras características específicas ao contexto, que afetarão a probabilidade de uma implementação bem-sucedida.

Trabalho de ativismo (N.T.: advocacy) de políticas foca em fazer com que as políticas sejam implementadas, p. ex., descobrir quem é a melhor pessoa para representar essa demanda política, para quem pedir e em que momento.

Implementação de políticas é o trabalho de efetivamente implementá-las na prática, pelos servidores públicos e pelas corporações.

Vale a pena distinguir entre políticas governamentais (isto é, políticas com a intenção de serem adotadas pelos governos ou organizações intergovernamentais) e políticas corporativas (isto é, políticas com a intenção de serem adotadas pelas corporações). Algumas pessoas trabalhando na governança longotermista de IA focam na melhoria de políticas corporativas (especialmente as políticas de desenvolvedores de IAs), ao passo que outros no campo focam na melhoria das políticas dos governos relevantes.

Uma motivação comum para todo o trabalho em diretrizes políticas é que detalhes de implementação frequentemente são concebidos como cruciais para a elaboração bem-sucedida das políticas. Por exemplo, se uma regulamentação governamental tem uma brecha sutil, isso pode torná-la inútil.

Em comparação com pesquisas, este tipo de trabalho tende a envolver relativamente menos pensamento individualizado e relativamente mais a coleta de conversas/informações (p. ex., ter reuniões para descobrir quem tem autoridade sobre uma determinada política, com o que eles se importam e o que os outros jogadores querem numa política), assim como coordenação (p. ex., descobrir como podemos conseguir que um grupo de atores endosse uma política, e daí fazer isso acontecer).

Conforme mencionado anteriormente, o insight em diretrizes políticas às vezes flui “retroativamente”. Por exemplo, o desenvolvimento de políticas pode ser feito interativamente, tendo por base como o ativismo modifica o nosso conhecimento (e o panorama de diretrizes políticas).

Exemplos

- Política governamental:

- Comprometer-se a não incorporar tecnologia de IA ao comando, controle e comunicações nucleares (NC3), p. ex., conforme defendido pelo CLTR em seu relatório Future Proof.

- Monitoramento governamental do desenvolvimento de IAs, p. ex., conforme desenvolvido neste informativo sobre monitoramento de IAs.

- Tornar regulamentações nascentes ou estratégias/princípios de IA sensíveis a riscos de sistemas de IA avançados (assim como atuais), p. ex., feedback de várias organizações do AE sobre o Ato da IA da União Europeia.

- Política corporativa:

- Desenvolver normas para a disseminação responsável de pesquisas sobre IA, dado o seu potencial de uso indevido, p. ex., estas recomendações da PAI.

Essas ideias variam num espectro de mais direcionadas (p. ex., não integrar IAs ao NC3) a mais gerais (no sentido de criar capacidades genéricas para lidar com uma ampla classe de problemas que provavelmente surgirão, como, p. ex., a maioria dos outros acima). Acho que o nosso desenvolvimento, ativismo e implementação de políticas de hoje deveria focar predominantemente em ideias mais gerais, dadas as nossas incertezas sobre como a IA se desenrolará (enquanto também pressionem por ideias específicas e objetivamente boas, quando elas surgirem).

Narrativas para impacto

- Impacto direto: termos boas políticas em vigor aumenta nossas chances de navegarmos com sucesso a transição para um mundo com IA avançada.

- Impacto indireto: mesmo se não pudermos ter certeza de que alguma ideia de diretriz política é robustamente boa, desenvolver / defender / implementá-la ajudará a construir o insight, a expertise, conexões e a credibilidade das pessoas na governança longotermista de IA. Não queremos chegar a uma “hora da verdade” da IA5, e só aí começar a aprender sobre como desenvolver as políticas e o processo de tomada de decisão.

- Dito isso, devemos ter muito cuidado para não implementarmos políticas que poderiam acabar sendo nocivas, p. ex., limitando o futuro desenvolvimento de políticas.

Quem está fazendo?

- Desenvolvimento:

- Ativismo:

- Implementação:

Construção de campo

Isto é trabalho que explicitamente visa fazer crescer o campo ou a comunidade de pessoas que estão fazendo trabalho valioso em governança longotermista de IA6. Poderíamos pensar neste trabalho como algo que envolve tanto (1) trazer novas pessoas e (2) tornar o campo mais efetivo.

Exemplos

- Trazer novas pessoas criando:

- bolsas de diretrizes políticas, como a OpenPhil Technology Policy Fellowship;

- programas on-line ou cursos para ajudar pessoas juniores a se atualizarem sobre o que está acontecendo na governança de IA;

- material introdutório de alta qualidade e que apelem a um público amplo, alcançando muitos graduandos;

- mais bolsas de pesquisas ampliáveis para conectar, apoiar e credenciar pesquisadores juniores.

- Tornar o campo mais efetivo criando:

- pautas de pesquisa;

- maneiras para pesquisadores seniores contratarem facilmente assistentes de pesquisa7.

Narrativas para impacto

- Modelo de crescimento: construir um campo de governança longotermista de IA com muitas pessoas alinhadas, que tenham a capacidade e a expertise relevante para fazer importantes pesquisas e trabalho de diretrizes políticas (talvez especialmente quando esse trabalho estiver menos afunilado pela falta de clareza estratégica).

- Modelo-metrópole8. construir um campo de governança de IA com conexões densas com comunidades mais amplas (p. ex., formulação de diretrizes políticas, ciências sociais, aprendizado de máquina), de tal modo que o campo possa valer-se de uma expertise diversa advinda dessas comunidades.

Quem está fazendo?

GovAI, OpenPhil, SERI, CERI, CHERI e EA Cambridge. Numa perspectiva mais ampla, toda construção do movimento do AE que seja generalista quanto ao apoio à causas. Este é o tipo de trabalho menos explorado discutido nesta postagem.

Outras visões do panorama da governança longotermista de IA

Apresentei só uma possível visão do panorama da governança longotermista de IA — há obviamente outras, que podem ser mais úteis para outros propósitos. Por exemplo, poderíamos dividir o panorama com base em diferentes tipos de intervenções, tais como:

- Mudar as discussões existentes nos espaço de diretrizes políticas para torná-las mais sensíveis aos riscos-x de IA (p. ex., conscientizar da dificuldade de assegurar sistemas de IA de ponta)

- Propor ferramentas de diretrizes políticas inovadoras (p. ex., padrões de IA internacionais)

- Conseguir fazer com que os governos financiem pesquisas de segurança em IA

- Modificar o comportamento corporativo (p. ex., a cláusula do lucro inesperado)

- …

Ou poderíamos dividir as coisas por pólo geográfico (embora nem toda organização faça parte de um pólo geográfico):

- Área da Baía de São Francisco: OpenPhil, OpenAI, PAI, várias organizações de alinhamento de IA. Na média estão mais focadas no desalinhamento como a fonte de riscos-x de IA; culturalmente mais próximas do Vale do Silício e de culturas da racionalidade.

- Distrito de Colúmbia (DC): governo dos EUA, CSET. Foco no desenvolvimento / ativismo / implementação de políticas nos EUA; culturalmente mais próximo da cultura do DC.

- Reino Unido (RU): FHI/GovAI, DeepMind, governo do RU, CSER, CLTR, (outros?). Em média mais preocupados com uma gama mais ampla de fontes de riscos-x de IA.

- União Europeia. Em 2020, a Comissão Europeia esboçou a primeira regulamentação do mundo relativa à IAs, que provavelmente será aprovada nos próximos anos e poderá levar a um efeito-Bruxelas.

- China.

- …

Ou poderíamos dividir o panorama com base em diferentes “teorias da vitória”, isto é, narrativas completas sobre como a humanidade navegará com sucesso a transição para um mundo com IA avançada. Há muito mais que poderia ser dito sobre tudo isso; a meta desta postagem foi somente dar uma síntese concisa dos tipos de trabalho que estão acontecendo atualmente.

Reconhecimentos: esta é a minha própria síntese do panorama, mas ela foi inspirada e/ou se vale diretamente de postagens do fórum do AE de Allan Dafoe, Luke Muehlhauser e Convergence Analysis. Obrigado também a Jess Whittlestone pelas úteis conversas, e também a Matthijs Maas, Yun Gu, Konstantin Pilz, Caroline Baumöhl e especialmente a um revisor do SERI pelo feedback dado a um esboço.

Notas

1. Com certeza, esqueci alguns importantes grupos da lista, e posso ter classificado mal alguns deles — por favor, avisem-me se esse for o caso!

2. Isso se baseia diretamente na definição da Open Philanthropy.

3. Observe que algumas dessas são questões de pesquisa de táticas em vez de questões de pesquisa de estratégias.

4. A CSET faz predominantemente pesquisa de táticas e desenvolvimento e defesa de políticas, mas o seu trabalho em mapear a cadeia de suprimento de semicondutores se insere na pesquisa de estratégias.

5. Muehlhauser define isso como “um período que dura 1-20 anos em que as decisões mais impactantes sobre os resultados de IAT podem ser tomadas”.

6. Isso é diferente dos benefícios da construção de campo de outros tipos de trabalho discutidos neste documento, visto que ele foca só e explicitamente em construir o campo.

7. O que pode também ajudar a trazer novas pessoas.

8. Essa ideia se baseia diretamente na postagem de Allan Dafoe no fórum.

Esta obra está licenciada sob uma Licença Creative Commons Atribuição 4.0 Internacional.

Publicado originalmente 18 de janeiro de 2022 aqui.

Autor: Sam Clarke

Tradução: Luan Marques

Revisão: Fernando Moreno