De Jason Wei e Denny Zhou. 11 de maio de 2022.

Nos últimos anos, foi demonstrado que aumentar o tamanho dos modelos de linguagem é uma forma confiável de melhorar o desempenho em uma série de tarefas de processamento de linguagem natural (PLN). Os modelos de linguagem atuais na escala de 100 bilhões ou mais de parâmetros alcançam um forte desempenho em tarefas como análise de sentimentos e tradução de máquina, mesmo com poucos ou nenhum exemplo de treinamento. Mesmo os maiores modelos de linguagem, no entanto, ainda podem ter dificuldades com certas tarefas de raciocínio em várias etapas, como problemas matemáticos com palavras e raciocínio de senso comum. Como podemos permitir que modelos de linguagem executem tais tarefas de raciocínio?

Em “A Indução de Cadeia de Pensamento Elicita Raciocínio em Grandes Modelos de Linguagem”, exploramos um método de indução (prompting) para melhorar as habilidades de raciocínio de modelos de linguagem. Chamado de indução de cadeia de pensamento, esse método permite que modelos decomponham problemas de várias etapas em etapas intermediárias. Com a indução de cadeia de pensamento, modelos de linguagem de escala suficiente (parâmetros de aproximadamente 100B) podem resolver problemas de raciocínio complexos que não podem ser resolvidos com métodos de indução-padrão.

Índice

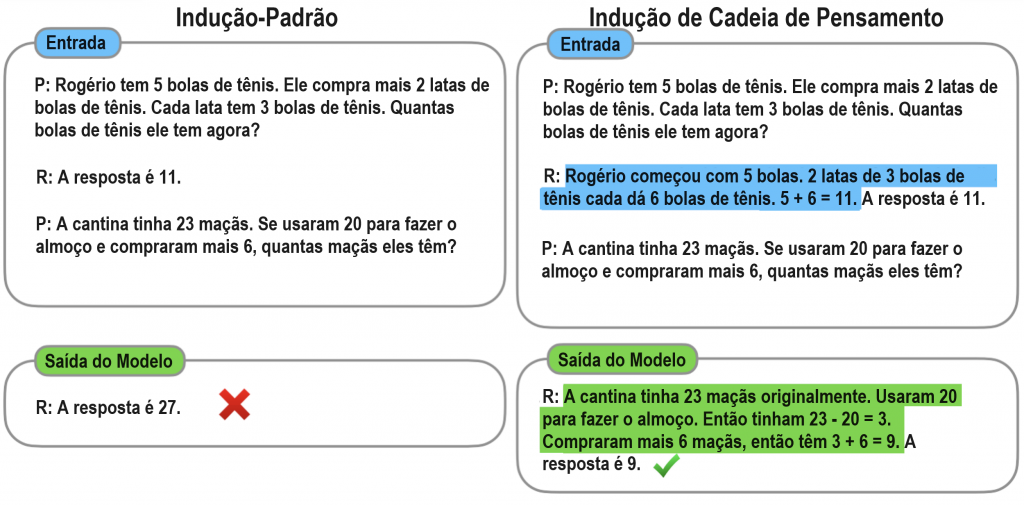

Comparação com a indução-padrão

Com a indução-padrão (popularizada pelo GPT-3), o modelo recebe exemplos de pares de entrada-saída (formatados como perguntas e respostas) antes de ser solicitado a prever a resposta para um exemplo de tempo de teste (mostrado abaixo à esquerda). Na cadeia de pensamento (abaixo, à direita), o modelo é solicitado a produzir etapas intermediárias de raciocínio antes de dar a resposta final a um problema de várias etapas. A ideia é que uma cadeia de pensamento gerada por um modelos imitaria um processo de pensamento intuitivo ao trabalhar em um problema de raciocínio em várias etapas. Embora a produção de um processo de pensamento tenha sido realizada anteriormente por meio de ajuste fino, mostramos que tais processos de pensamento podem ser elicitados incluindo alguns exemplos de cadeia de pensamento apenas via indução, o que não requer um grande conjunto de dados de treinamento ou modificação dos pesos do modelo de linguagem.

O raciocínio em cadeia de pensamento permite que os modelos decomponham problemas complexos em etapas intermediárias que são resolvidas individualmente. Além disso, a natureza da cadeia de pensamento baseada na linguagem a torna aplicável a qualquer tarefa que uma pessoa possa resolver através da linguagem. Descobrimos, por meio de experimentos empíricos, que a indução de cadeia de pensamento pode melhorar o desempenho em várias tarefas de raciocínio, e que o raciocínio em cadeia de pensamento bem-sucedido é uma propriedade emergente da escala do modelo — ou seja, os benefícios da indução de cadeia de pensamento só se materializam com um número suficiente de parâmetros do modelo (cerca de 100B).

Raciocínio Aritmético

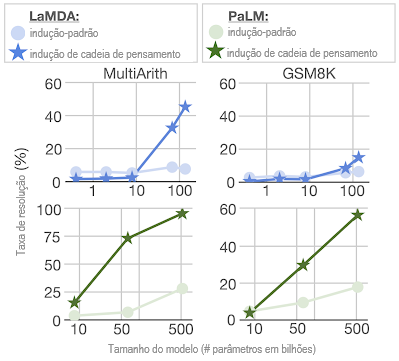

Uma classe de tarefas em que os modelos de linguagem normalmente enfrentam dificuldades é o raciocínio aritmético (ou seja, resolver problemas matemáticos com palavras). Dois referenciais em raciocínio aritmético são o MultiArith e o GSM8K, que testam a capacidade dos modelos de linguagem de resolver problemas matemáticos de várias etapas semelhantes ao mostrado na figura acima. Avaliamos tanto a coleção LaMDA de modelos de linguagem que varia de 422M a 137B parâmetros, quanto a coleção PaLM de modelos de linguagem que varia de 8B a 540B parâmetros. Compomos manualmente cadeias de pensamento para incluir nos exemplos de indução de cadeia de pensamento.

Para esses dois referenciais, o uso de indução-padrão leva a curvas de amplificação relativamente planas: aumentar a escala do modelo não melhora substancialmente o desempenho (mostrado abaixo). No entanto, descobrimos que, ao usar a indução de cadeia de pensamento, o aumento da escala do modelo leva a um desempenho melhorado que supera substancialmente a indução-padrão para tamanhos grandes de modelos.

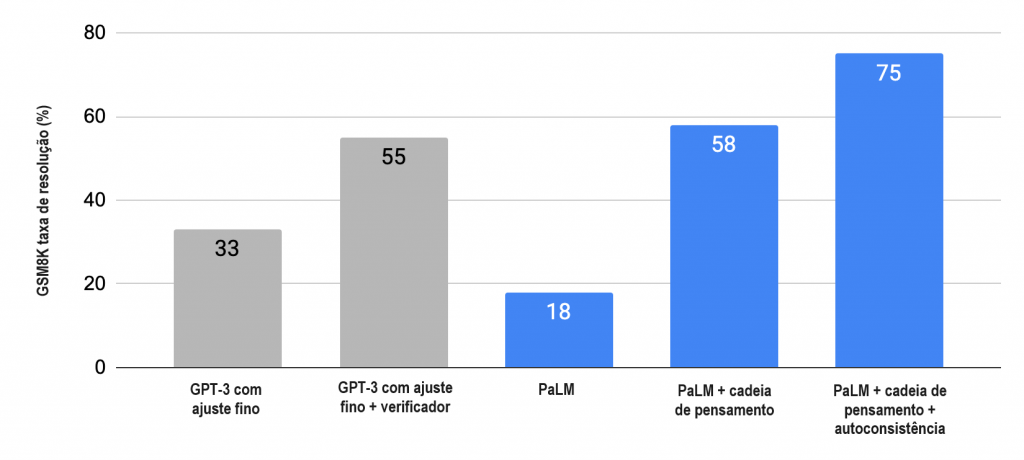

No conjunto de dados GSM8K de problemas matemáticos, o PaLM mostra um desempenho notável quando amplificado para 540B parâmetros. Conforme mostrado na tabela abaixo, a combinação da indução de cadeia de pensamento com o modelo PaLM de 540B parâmetros leva a um novo desempenho de última geração de 58%, superando o estado da arte anterior de 55% alcançado pelo ajuste fino do GPT- 3 175B em um grande conjunto de treinamento e depois classificando soluções potenciais por meio de um verificador especialmente treinado. Além disso, o trabalho de acompanhamento sobre autoconsistência mostra que o desempenho da indução de cadeia de pensamento pode ser melhorado ainda mais através da obtenção do voto majoritário de um amplo conjunto de processos de raciocínio gerados, o que resulta em 74% de precisão no GSM8K.

Raciocínio de senso comum

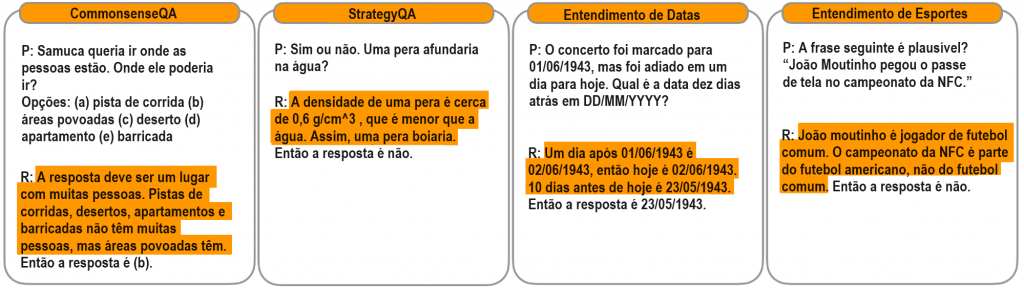

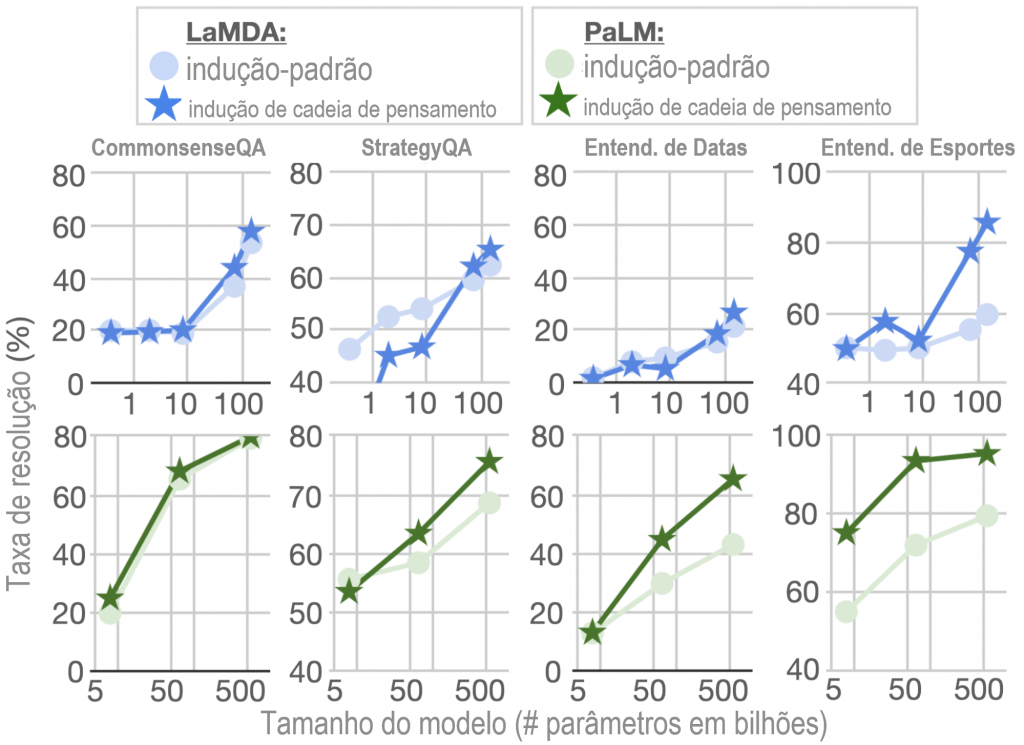

Além do raciocínio aritmético, consideramos se a natureza da cadeia de pensamento baseada na linguagem também a torna aplicável ao raciocínio de senso comum, que envolve raciocínio sobre interações físicas e humanas sob a pressuposição de conhecimento geral de base. Para essas avaliações, usamos os referenciais CommonsenseQA e StrategyQA, bem como duas tarefas específicas ao domínio da colaboração BIG-Bench relacionadas à compreensão de datas e à compreensão de esportes. Exemplos de perguntas estão abaixo:

Conforme mostrado abaixo, para CommonsenseQA, StrategyQA e Date Understanding, o desempenho melhorou com a escala do modelo e o emprego da indução de cadeia de pensamento levou a pequenas melhorias adicionais. A indução de cadeia de pensamento teve a maior melhoria na compreensão de esportes, para a qual o desempenho da cadeia de pensamento do PaLM 540B superou o de um entusiasta de esportes sem assistência (95% vs 84%).

Conclusões

A indução de cadeia de pensamento é um método simples e amplamente aplicável para melhorar a capacidade dos modelos de linguagem de realizar várias tarefas de raciocínio. Através de experimentos sobre raciocínio aritmético e de senso comum, descobrimos que a cadeia de pensamento é uma propriedade emergente da escala do modelo. Esperamos que ampliar a gama de tarefas de raciocínio que os modelos de linguagem pode realizar inspire mais trabalhos sobre abordagens de raciocínio baseadas na linguagem.

Agradecimentos

Foi uma honra e um privilégio trabalhar com Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Ed Chi, Sharan Narang, Aakanksha Chowdhery e Quoc Le neste projeto.

Tradução: Luan Marques

Link para o original