Versão em áudio disponível no Cold Takes (ou busque no Stitcher, Spotify, Google Podcasts, etc. por “Cold Takes Audio”)

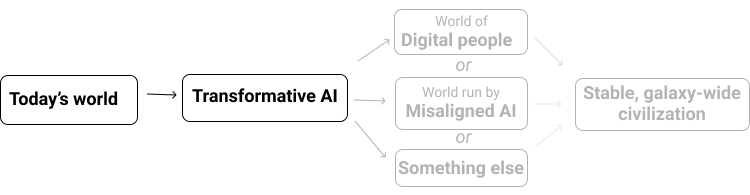

[Mundo de hoje, IA transformadora, Mundo de Pessoas digitais, ou Mundo governado por IA desalinhada ou Outra coisa, Civilização estável de amplitude galáctica]

Este artigo começa com um resumo de quando devemos esperar que uma IA transformadora se desenvolva, com base em múltiplos ângulos cobertos anteriormente nesta série. Achamos este resumo útil, mesmo que você já tenha lido todos os artigos anteriores, mas, se gostaria de pulá-lo, clique aqui.

Eu então trato da questão: “Por que não há consenso entre os especialistas sobre este tópico, e o que isso significa para nós?”

Estimo que haja uma chance de mais de 10% de que veremos IA transformadora dentro de 15 anos (por volta de 2036); uma chance de aproximadamente (~) 50% de que a veremos dentro de 40 anos (por volta de 2060); e uma chance de ~2/3 de que a veremos neste século (por volta de 2100).

(Por “IA transformadora”, quero dizer uma “IA potente o bastante para nos levar para um futuro novo e qualitativamente diferente”. Eu foco especificamente no que estou chamando de PASTA: sistemas de IA que podem essencialmente automatizar todas as atividades humanas para acelerar o avanço científico e tecnológico. Argumentei que o PASTA poderia ser suficiente para tornar este o século mais importante, por meio do potencial para uma explosão de produtividade, assim como riscos de IAs desalinhadas).

Essa é a minha conclusão geral baseada em diversos relatórios técnicos abordando as previsões sobre a IA de diferentes ângulos — muitos dos quais produzidos pela Open Philanthropy durante os últimos anos, conforme nós tentamos desenvolver uma imagem minuciosa quanto às previsões de uma IA transformadora, de modo a embasar nossas doações longoprazistas.

Aqui está um resumo em uma tabela dos diferentes ângulos das previsões de IA transformadora que discutimos, com links para discussões mais detalhadas em postagens anteriores, assim como relatórios técnicos subjacentes:

| Ângulo de previsão | Artigos detalhados cruciais (títulos abreviados) | Minhas conclusões |

| Estimativas de probabilidade para IA transformadora | ||

| Opinião de especialistas. O que os pesquisadores da área de IA esperam? | Evidências dos Especialistas em IA | A opinião de especialistas implica1 uma probabilidade de ~20% por volta de 2036; de ~50% por volta de 2060; de ~70% por volta de 2100. Perguntas feitas de modos ligeiramente diferentes (colocadas a uma minoria de respondentes) levam a estimativas muito mais posteriores. |

| Estrutura de âncoras biológicas. Com base em padrões comuns sobre quanto custa o “treinamento de IAs”, quanto custaria para treinar um modelo de IA tão grande quanto um cérebro humano para desempenhar a mais difícil tarefa que humanos fazem? E quando isso será barato o bastante que poderemos esperar que alguém o faça? | Bioâncoras, Valendo-se da Computação Cerebral(N.R: Veja Poder computacional do cérebro humano) | Probabilidade >10% por volta de 2036; chance de ~50% por volta de 2055; chance de ~80% por volta de 2100. |

| Ângulos sobre o ônus da prova | ||

| É improvável que um dado século qualquer seja aquele “mais importante”. | “Momento decisivo da história“; Resposta à ideia de “momento decisivo da história” | Temos muitas razões para pensar que este século seja um século “especial” antes de olharmos para os detalhes da IA. Muitas delas foram cobertas em artigos anteriores; uma outra razão será abordada na próxima sequência. |

| O que você poderia prever sobre linhas do tempo da IA transformadora, com base somente em informações básicas sobre (a) por quantos anos as pessoas têm tentado construir uma IA transformadora; (b) quanto elas têm “investido” nela (em termos do número de pesquisadores na área da IA e da quantidade de computação utilizada por eles); (c) se eles já o fizeram (até agora, não fizeram)? | Probabilidades a priori semi-informativas | Estimativas centrais: 8% por volta de 2036; 13% por volta de 2060; 20% por volta de 2100.2 Na minha opinião, esse relatório destaca que a história da IA é curta, o investimento em IA está aumentando rápido e, assim, não devemos ficar muito surpresos se a IA transformadora for desenvolvida em breve. |

| Com base na análise de modelos econômicos e da história da economia, quão provável é o “crescimento explosivo” — definido como >30% de crescimento anual na economia mundial — por volta de 2100? Isso está longe o bastante do “normal” para duvidarmos da conclusão? | Crescimento Explosivo, Trajetória Humana | Trajetória Humana projeta o passado adiante, implicando crescimento explosivo por volta de 2043-2065.Crescimento Explosivo conclui: “Acho que considerações econômicas não fornecem uma boa razão para rejeitar a possibilidade de que IAT seja desenvolvida neste século. De fato, há uma perspectiva econômica plausível da qual se espera que sistemas de IA suficientemente avançados causem crescimento explosivo.” |

| “Como as pessoas previram a IA (…) no passado e como deveríamos ajustar as nossas visões hoje para corrigir os padrões que podemos observar em previsões anteriores? (…) Encontramos a visão de que a IA levou a propensão de visões exageradas no passado, e que deveríamos assim esperar que as previsões de hoje provavelmente sejam superotimistas.” | Previsões de IA do Passado | “O pico do hype da IA parece ter sido 1956-1973. Ainda assim, o hype de algumas das previsões de IA mais bem conhecidas desse período é comumente exagerado.” |

Por uma questão de transparência, observo que muitos destes relatórios técnicos são análises feitas pela Open Philanthropy e também que sou codiretor executivo da Open Philanthropy.

Índice

Pós Resumo

Tendo considerado tudo acima, espero que os leitores ainda tenham uma sensação de inquietude. Ainda que pensem que meus argumentos fazem sentido, podem estar se perguntando: se tudo isso é verdade, por que não é mais amplamente discutido e aceito? Qual é o estado atual da opinião dos especialistas?

Meu resumo do estado atual da opinião dos especialistas neste momento é o seguinte.

- As afirmações que estou fazendo não contradizem nenhum consenso de especialistas em particular. (De fato, as probabilidades que dei não se afastam muito do que os pesquisadores da área da IA parecem prever, conforme mostrado na primeira fileira) Mas há alguns sinais de que eles não estão pensando muito a fundo sobre o problema.

- Os relatórios técnicos da Open Philanthropy em que me apoiei tiveram uma considerável revisão externa da parte de especialistas. Pesquisadores da área do aprendizado de máquina revisaram Bioâncoras; neurocientistas revisaram Computação Cerebral; economistas revisaram o Crescimento Explosivo; acadêmicos focados em tópicos relevantes em incerteza e/ou probabilidade revisaram Probabilidades a priori semi-informativas2. (Algumas dessas revisões tinham consideráveis pontos de desacordo, mas nenhum desses apontamentos parecia ser um exemplo de que os relatórios contradizerem um claro consenso dos especialistas ou da literatura).

- Mas não há também nenhum consenso entre os especialistas, que seja ativo e robusto, apoiando afirmações como “Há pelo menos uma chance de 10% de IA transformadora por volta de 2036” ou “Há uma boa chance de que estejamos no século mais importante para a humanidade”, da mesma maneira que há um consenso para apoiar, p. ex., a necessidade de tomarmos uma atitude contra o aquecimento global.

Em última análise, minhas afirmações tratam de tópicos que simplesmente não existem especialistas daquela “área”, dedicados a estudá-la. Esse, em si, é um fato assustador, e algo que espero que, finalmente, irá mudar.

Mas devemos estar dispostos a agir de acordo com a hipótese do “século mais importante” por enquanto?

Abaixo, discutiremos sobre o seguinte.

- Como se poderia parecer uma “área de estudos de previsão da IA”.

- Uma “visão cética” que diz que discussões atuais em torno destes tópicos são pequenas, homogêneas e insulares demais (com o que eu concordo) — e que, portanto, não deveríamos agir de acordo com a hipótese do “século mais importante” até haver uma área de estudo mais madura e robusta (com o que eu não concordo).

- Por que deveríamos levar a hipótese a sério por enquanto, até e a não ser que tal área de estudo se desenvolva.

- Não temos tempo para esperar um consenso robusto entre os especialistas.

- Se há boas refutações por aí — ou futuros especialistas em potencial poderiam desenvolver tais refutações — não as encontramos ainda. Quanto mais levamos a hipótese a sério, mais provável é que essas refutações apareçam. (Isso também conhecido como a teoria da Lei de Cunningham: “a melhor maneira de conseguir uma resposta certa é publicando uma resposta errada.”)

- Acho que insistir sistematicamente num consenso robusto entre especialistas é um padrão de raciocínio perigoso. Na minha opinião, está tudo bem em corrermos algum risco de autoilusão e insularidade, em troca de fazermos a coisa certa quando isso mais vale a pena.

Que tipo de especialidade é a especialidade na previsão de IA?

As questões analisadas nos relatórios técnicos listados acima incluem o seguinte:

- As capacidades de IA estão ficando mais impressionantes com o passar do tempo? (IA, história da IA)

- Como comparamos modelos de IA com cérebros de animais/humanos? (IA, neurociência)

- Como comparamos as capacidades da IA com as capacidades dos animais? (IA, etologia)

- Como estimamos a despesa de treinarmos um grande sistema de IA para uma tarefa difícil, com base em informações que temos sobre treinarmos sistemas de IA passados? (IA, ajuste de curvas)

- Como podemos fazer uma estimativa sobre IA transformadora baseada em informações mínimas, tendo por base somente quantos anos/pesquisadores/dólares entraram na área até o momento? (Filosofia, probabilidade)

- Quão provável é o crescimento econômico explosivo neste século, com base na teoria e nas tendências históricas? (Economia do crescimento, história da economia)

- Como foi o “hype da IA” no passado? (História)

Ao falar sobre as implicações mais amplas da IA transformadora para o “século mais importante”, também discuti sobre coisas como “Quão viáveis são pessoas digitais e estabelecermos assentamentos espaciais pela galáxia?” Esses tópicos tocam a física, a neurociência, a engenharia, a filosofia da mente e mais.

Não há um emprego ou credencial óbvio que faça de alguém um especialista sobre a questão de quando podemos esperar uma IA transformadora, ou sobre a questão de se estamos no século mais importante.

(Eu particularmente discordaria de qualquer afirmação de que deveríamos confiar exclusivamente em pesquisadores da área da IA para essas previsões. Além do fato de que eles não parecem estar pensando muito seriamente sobre o tópico, acho que confiar em pessoas que se especializam em desenvolver modelos de IA sempre mais potentes para nos dizerem quando IA transformadora poderia chegar é como confiar em empresas de pesquisa e desenvolvimento em energia solar — ou empresas de extração de petróleo, dependendo de como você olha as coisas — para prever emissões de carbono e mudanças climáticas. Elas certamente veem parte do panorama. Mas previsão é uma atividade distinta de inovação e construção de sistemas no estado da arte).

E nem tenho certeza de que essas questões têm ao formato correto para serem uma área de estudo acadêmica. Tentar prever a IA transformadora, ou determinar as probabilidades de estarmos no mais importante século, parece:

- mais semelhante ao modelo de eleição FiveThirtyEight (“Quem vai vencer a eleição?”) do que ciência política acadêmica (“Como governos e cidadãos interagem?”);

- mais semelhante ao comércio nos mercados financeiros (“Este preço vai aumentar ou baixar no futuro?”) do que economia acadêmica (“Por que as recessões existem?”)3;

- mais semelhante às pesquisas da GiveWell (“Qual instituição de caridade mais ajuda as pessoas, por dólar?”) do que economia do desenvolvimento acadêmica (“O que causa a pobreza e o que pode reduzi-la?”)4.

Em outras palavras, não me é claro como se pareceria um “lar institucional” para a especialidade em previsão da IA transformadora e do “século mais importante”. Mas parece justo dizer que não há grandes e robustas instituições dedicadas a esse tipo de questão atualmente.

Como devemos agir na ausência de um consenso robusto entre especialistas?

A visão cética

Carecendo de um consenso robusto entre especialistas, espero que algumas (na verdade, a maioria das) pessoas sejam céticas, não importam os argumentos apresentados.

Aqui está uma versão de uma reação cética muito geral pela qual sinto bastante empatia.

- Isso tudo é simplesmente extravagante demais.

- Você está fazendo uma alegação exagerada sobre viver no século mais importante. Isso casa com o padrão da autoilusão.

- Você argumentou que o ônus da prova não deveria ser tão alto, pois de diversas maneiras vivemos numa época extraordinária e instável. Mas… eu não confio em mim mesmo para avaliar essas alegações, ou nas suas alegações sobre IA, ou realmente qualquer coisa sobre esses tópicos extravagantes.

- Preocupo-me com o modo como algumas pessoas parecem envolver-se com esses argumentos; com como as discussões parecem ser pequenas, homogêneas e insulares. No geral, isso parece mais uma narrativa que pessoas inteligentes contam umas às outras — com um monte de gráficos e números para racionalizá-la — sobre o seu lugar na história. Não passa uma sensação de “realidade”.

- Então, me liga de volta quando tiver uma área de estudo madura de talvez centenas ou milhares de especialistas, criticando e avaliando uns aos outros, e eles tiverem alcançado o mesmo consenso que vemos para as mudanças climáticas.

Enxergo como você se sente dessa maneira, e já me senti assim às vezes — especialmente sobre os pontos #1-#4. Mas darei três razões pelas quais o ponto #5 não parece certo.

Razão 1: não temos tempo para esperar um consenso robusto entre especialistas

Preocupo-me que a chegada da IA transformadora possa desenrolar-se como um tipo de versão da pandemia da COVID-19 só que em câmera lenta e com muito mais em jogo. O argumento a favor de esperarmos que algo de grande porte aconteça existe, se você olhar para a melhor informação e as melhores análises disponíveis atualmente. Mas a situação é amplamente não familiar; não se ajusta aos padrões com que as nossas instituições lidam regularmente. E todo ano extra de ação é valioso.

Você também poderia pensar nela como uma versão em alta velocidade da dinâmica das mudanças climáticas. Imagine se as emissões de gases do efeito estufa tivessem só começado a se elevar recentemente5 (em vez de em meados do século XIX), e que não houvesse nenhuma área de estudo estabelecida da ciência do clima. Seria realmente uma má ideia esperar décadas para uma área de estudo surgir, antes de buscar reduzir as emissões.

Razão 2: a Lei de Cunningham (“a melhor maneira de conseguir uma resposta certa é publicar uma resposta errada”) pode ser a nossa melhor esperança de encontrar o defeito nesses argumentos

(Sobre a Lei de Cunningham).

Sim, estou falando sério.

Vários anos atrás, alguns colegas e eu suspeitamos de que a hipótese do “século mais importante” poderia ser verdadeira. Mas antes de agir demasiadamente de acordo com ela, queríamos ver se podíamos encontrar defeitos fatais na hipótese.

Um modo de interpretar as nossas ações durante os últimos anos é como se estivéssemos fazendo tudo que pudéssemos para descobrir que a hipótese está errada.

Primeiro, tentamos falar com as pessoas sobre os argumentos cruciais: pesquisadores da área da IA, economistas, etc. Mas:

- tínhamos vagas ideias dos argumentos nesta série (predominante ou talvez inteiramente apanhados de outras pessoas). Não pudemos enunciá-los com boa nitidez e especificidade.

- Havia um monte de pontos factuais cruciais que pensávamos que provavelmente estariam corretos6, mas que não havíamos especificado e não conseguíamos apresentar para a crítica.

- No geral, não conseguimos nem realmente articular o bastante uma defesa concreta para dar aos outros uma justa oportunidade de derrubá-la.

Logo, trabalhamos bastante na criação de relatórios técnicos sobre muitos dos argumentos cruciais. (Eles agora estão públicos e incluídos na tabela no topo deste artigo). Isso nos coloca em posição de publicar os argumentos e potencialmente encontrar contra-argumentos fatais.

Portanto, comissionamos revisões externas de especialistas7.

Falando somente das minhas próprias visões, a hipótese do “século mais importante” parece ter sobrevivido a tudo isso. De fato, tendo examinado os vários ângulos e entrado mais nos detalhes, creio nela mais intensamente que antes.

Mas digamos que isso seja só porque os especialistas de verdade — pessoas que não encontramos ainda, com contra-argumentos devastadores — acham tudo tão bobo que não se estão dando ao trabalho de dialogar. Ou digamos que haja pessoas por aí atualmente que poderiam um dia tornar-se especialistas sobre estes tópicos e demolir esses argumentos. O que poderíamos fazer para fazer isso acontecer?

A melhor resposta que já elaborei é: “Se esta hipótese fosse mais conhecida, mais amplamente aceita e mais influente, ela receberia um escrutínio mais crítico”.

Esta série é uma tentativa de dar um passo nessa direção — para mover-nos em direção a uma maior credibilidade para a hipótese do “século mais importante”. Isso seria uma coisa boa se a hipótese fosse verdadeira; também parece como o melhor próximo passo se meu único objetivo fosse desafiar minhas crenças e descobrir que elas são falsas.

Claro que não estou dizendo para aceitar ou promover a hipótese do “século mais importante” se ela não parecer correta para você. Mas acho que se a sua única ressalva se trata da falta de um consenso robusto, continuar a ignorar a situação parece estranho. Se as pessoas se comportassem assim em geral (ignorando qualquer hipótese que não for apoiada por um consenso robusto), não tenho certeza de como qualquer hipótese — incluindo as verdadeiras — passaria de marginal para aceita.

Razão 3: ceticismo geral assim parece uma má ideia

Lá no tempo em que eu focava na GiveWell, as pessoas ocasionalmente diziam algo como: “Sabe, você não pode exigir que todo argumento satisfaça o padrão que a GiveWell exige das suas organizações mais bem classificadas — buscando estudos aleatórios controlados, dados empíricos robustos, etc. Algumas das melhores oportunidades de fazer o bem serão aquelas que são menos óbvias — logo, esse padrão arrisca excluir algumas das suas maiores oportunidades potenciais de ter impacto.”

Acho que isso está certo. Acho que é importante examinarmos a nossa abordagem geral quanto às razões e aos padrões de evidências e nos perguntarmos: “Quais são alguns cenários nos quais minha abordagem fracassa, e nos quais eu realmente iria preferir que ela tivesse êxito?” Na minha opinião, está tudo bem em corrermos algum risco de autoilusão e insularidade, em troca de fazermos a coisa certa quando isso mais vale a pena.

Acho que a falta de um consenso robusto entre especialistas — e preocupações sobre autoilusão e insularidade — fornece boa razão para pegar mesmo no pé da hipótese do “século mais importante”, em vez de aceitá-la de imediato. Perguntar onde pode haver um defeito não descoberto, procurar algum viés em direção a inflar a nossa própria importância, pesquisar as partes que mais parecem importantes no argumento, etc.

Mas se você investigou a questão tanto quanto lhe foi razoável/prático, e não encontrou um defeito além de considerações como “Não há um consenso robusto entre especialistas” e “Preocupo-me com autoilusão e insularidade”, então acho que descartar a hipótese é o tipo de coisa que essencialmente garante que você não esteja entre as pessoas que irão perceber e tomar uma atitude mais cedo sobre um problema tremendamente importante, se surgir a oportunidade. Acho que isso é demais para se sacrificar, em termos de abrir mão de oportunidades potenciais para se fazer bastante bem ao mundo.

Notas

1. Tecnicamente, essas probabilidades são para a “inteligência de máquina de nível humano”. Em geral, essa tabela simplifica as coisas ao apresentar um conjunto unificado de probabilidades. Em geral, todas essas probabilidades se referem a algo ao menos tão capaz quanto o PASTA, de modo que direcionalmente elas deveriam ser subestimações da probabilidade do PASTA (embora eu não ache que isso seja um grande problema).

2. Revisões de Bioâncoras se encontram aqui; revisões de Crescimento Explosivo se encontram aqui; revisões de Probabilidades A Priori Semi-Informativas se encontram aqui. Computação Cerebral foi revisado num momento anterior quando não havíamos projetado o processo para resultar na publicação de revisões, mas mais de 20 conversas com especialistas que informaram o relatório estão disponíveis aqui. Trajetória Humana não foi revisado, embora grande parte da sua análise e conclusões figure em Crescimento Explosivo, o qual foi.

3. As áreas de estudo acadêmicas são bem amplas, e estou só dando exemplos de questões com que elas lidam.

4. Embora a ciência do clima seja um exemplo de uma área de estudo acadêmica que investe muito na previsão do futuro.

5. A área da IA existe desde 1956, mas foi só na última década que os modelos de aprendizado de máquina começaram a entrar na gama do tamanho dos cérebros dos insetos e desempenhar bem em tarefas relativamente difíceis.

6. Com frequência, estávamos simplesmente baseando-nos em nossas impressões do que outras pessoas que haviam pensado bastante sobre o tópico achavam.

7. Revisões de Bioâncoras se encontram aqui; revisões de Crescimento Explosivo se encontram aqui; revisões de Probabilidades A Priori Semi-Informativas se encontram aqui. Computação Cerebral foi revisado num momento anterior quando não havíamos projetado o processo para resultar na publicação de revisões, mas mais de 20 conversas com especialistas que informaram o relatório estão disponíveis aqui. Trajetória Humana não foi revisado, embora grande parte da sua análise e conclusões figure em Crescimento Explosivo, o qual foi.

Esta obra está licenciada sob uma Licença Creative Commons Atribuição 4.0 Internacional

Publicado originalmente em 7 de setembro de 2021 aqui.

Autor: Holden Karnofsky

Tradução: Luan Marques

Revisão: Fernando Moreno