Índice

Resumo

As instituições internacionais podem ter um papel importante a desempenhar para garantir que os sistemas avançados de IA beneficiem a humanidade. As colaborações internacionais podem liberar a capacidade da IA de promover o desenvolvimento sustentável, e a coordenação de esforços regulatórios pode reduzir os obstáculos à inovação e à difusão de benefícios. Por outro lado, as potenciais capacidades perigosas de sistemas de IA poderosos e de uso geral criam externalidades globais no seu desenvolvimento e implementação, e os esforços internacionais para promover práticas responsáveis de IA poderiam ajudar a gerir os riscos que eles representam. Este documento identifica um conjunto de funções de governança que poderiam ser desempenhadas a nível internacional para enfrentar esses desafios, desde o apoio ao acesso a sistemas de IA de fronteira até a definição de normas de segurança internacionais. Ele agrupa essas funções em quatro modelos institucionais que apresentam sinergias internas e têm precedentes em organizações existentes: 1) uma Comissão sobre IA de Fronteira que facilita o consenso de especialistas sobre oportunidades e riscos da IA avançada, 2) uma Organização de Governança da IA Avançada que estabelece padrões internacionais para gerenciar ameaças globais de modelos avançados, apoia sua implementação e possivelmente monitora a conformidade com um regime de governança futuro, 3) uma Colaboração de IA de Fronteira que promove o acesso à IA de ponta e 4) um Projeto de Segurança da IA que reúne pesquisadores e engenheiros na liderança para promover pesquisas de segurança da IA. Exploramos a utilidade desses modelos e identificamos questões em aberto sobre sua viabilidade.

Sumário Executivo

Avanços recentes na IA destacaram os impactos potencialmente transformadores dos sistemas avançados1. As instituições internacionais podem ter um papel importante a desempenhar para garantir que eles sejam globalmente benéficos.

As colaborações internacionais podem ser importantes para liberar as capacidades da IA para promover o desenvolvimento sustentável e beneficiar a humanidade. Muitas sociedades que mais poderiam se beneficiar podem não ter os recursos, a infraestrutura ou a formação para tirar partido dos atuais sistemas de IA de ponta. O desenvolvimento da IA de fronteira pode não se concentrar nas necessidades globais, e os benefícios econômicos das tecnologias comerciais de IA poderiam beneficiar principalmente os países desenvolvidos. A incapacidade de coordenar ou harmonizar a regulamentação também pode retardar a inovação.

Além disso, também poderão ser necessários esforços internacionais para gerir os riscos diretos colocados pelas poderosas capacidades de IA. Sem proteções adequadas, algumas dessas capacidades – desenvolvimento automatizado de software, pesquisa química e de biologia sintética, geração de texto e vídeo – podem ser utilizadas indevidamente por atores maliciosos em todo o mundo, com consequências transnacionais. Além disso, os benefícios geopolíticos significativos do rápido desenvolvimento da IA diminuem a probabilidade de uma governança adequada da IA sem cooperação internacional.

Este documento descreve um conjunto de funções de governança internacional, que vão desde a distribuição de sistemas de IA de fronteira até a definição de normas de segurança, que podem ser necessárias para aproveitar as oportunidades e mitigar os riscos da IA avançada. Os primeiros esforços para desempenhar algumas dessas funções foram empreendidos por organizações intergovernamentais como a Organização para a Cooperação e Desenvolvimento Econômico (OCDE), a Parceria Global sobre a IA (GPAI), o Processo de Hiroshima do Grupo dos 7 (G7), o União Internacional de Telecomunicações (UIT), bem como por iniciativas do setor privado, como a Parceria sobre a IA, o ML Commons e as iniciativas de definição de normas da Organização Internacional de Normalização (ISO) e da Comissão Eletrotécnica Internacional (IEC). Mas a rápida taxa de progresso da IA sugere que poderão ser necessários mais esforços institucionais na governança global da IA.

As funções que identificamos poderiam ser divididas de múltiplas formas entre organizações e poderiam envolver partes interessadas do setor público, do setor privado e da sociedade civil. Agrupamos essas funções em quatro modelos institucionais que apresentam sinergias e têm precedentes em organizações existentes, e discutimos seus pontos fortes e limitações:

- Uma Comissão Intergovernamental sobre IA de Fronteira2 poderia estabelecer uma posição científica sobre as oportunidades e riscos da IA avançada e como podem ser geridos. Ao fazê-lo, aumentaria a sensibilização e a compreensão do público sobre as perspectivas e questões da IA, contribuiria para uma descrição cientificamente informada da utilização da IA e da mitigação de riscos, e seria uma fonte de conhecimentos especializados para os decisores políticos.

- Uma Organização de Governança da IA Avançada que seja intergovernamental ou multilateral3 poderia ajudar a internacionalizar e alinhar esforços para enfrentar os riscos globais de sistemas avançados de IA, estabelecendo normas e padrões de governança e auxiliando na sua implementação. Pode também desempenhar funções de monitoração da conformidade (de forma independente ou em associação com grupos industriais) para um regime de governança internacional.

- Uma Colaboração de IA de Fronteira4 poderia promover o acesso à IA avançada como uma parceria internacional público-privada. Ao fazê-lo, poderia ajudar as sociedades desfavorecidas a se beneficiar da tecnologia de IA de ponta e promover o acesso internacional à tecnologia de IA para objetivos de segurança e governança.

- Um Projeto de segurança da IA5 poderia reunir investigadores e engenheiros de renome e proporcionar-lhes acesso a recursos computacionais e modelos avançados de IA para trabalhar na mitigação técnica dos riscos da IA, potencialmente trabalhando com esforços paralelos da indústria. Promoveria a Pesquisa e Desenvolvimento em segurança da IA, aumentando a sua escala, recursos e coordenação.

Existem importantes questões em aberto sobre a viabilidade de tais modelos. Uma Comissão sobre a IA de Fronteira enfrentará desafios científicos significativos, dada a limitada investigação científica sobre questões de IA avançada, e terá de combater a politização das suas atividades. A rápida taxa de progresso da IA tornará difícil para uma Organização de Governança da IA Avançada estabelecer normas que acompanhem e tenham escopo adequado para o panorama de riscos, e as muitas dificuldades de coordenação internacional levantam questões sobre como a participação em um regime de Organização pode ser incentivada. A natureza potencialmente de uso duplo das tecnologias de IA de uso geral pode prejudicar a capacidade de uma Colaboração da IA de Fronteira de distribuir amplamente sistemas benéficos, e os obstáculos significativos para sociedades desfavorecidas que utilizam sistemas de IA levantam questões sobre a sua eficácia como meio de promover o desenvolvimento sustentável. Finalmente, um Projeto de Segurança da IA poderia ter dificuldades para garantir o acesso adequado ao modelo para conduzir pesquisas de segurança, e pode não valer a pena desviar os pesquisadores de segurança dos laboratórios de fronteira.

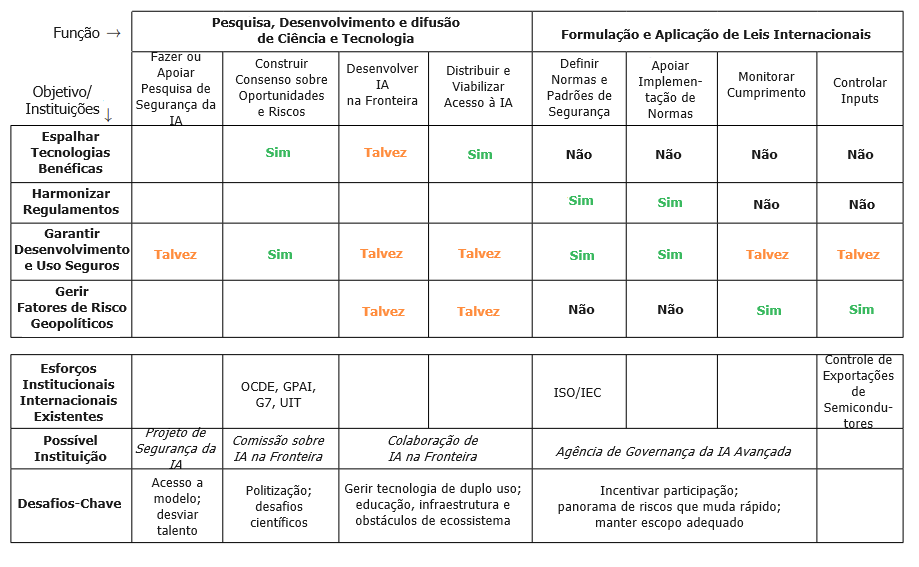

A Tabela 1 abaixo resume nosso mapeamento das funções institucionais, os desafios que elas abordam e as instituições existentes e possíveis que desempenham essas funções.

Há detalhes sobre esses modelos institucionais que deixamos fora do escopo ou que permanecem incertos – se essas instituições deveriam ser novas ou evoluções de organizações existentes, se as condições sob as quais essas instituições provavelmente terão maior impacto se concretizarão, se outros agrupamentos de funções institucionais seriam mais eficazes –, mas o rápido progresso nesses tópicos ajudará no preparo para o desenvolvimento da IA avançada.

3. Instituições internacionais para a IA avançada

Descrevemos várias funções de governança da IA que podem ser necessárias a nível internacional e demonstramos que apenas um número limitado delas está atualmente sendo desempenhado pelas instituições existentes. Nesta seção, discutimos como as lacunas funcionais podem ser preenchidas.

As funções poderiam ser divididas de múltiplas maneiras entre instituições: com base em organizações e propostas internacionais existentes, descrevemos quatro modelos idealizados. Observamos que os modelos descritos nesta seção descrevem funções que poderiam ser preenchidas por instituições novas ou existentes. Os participantes nessas instituições podem incluir governos, ONGs, o setor privado e o meio académico. A Tabela 1 resume a análise anterior e as funções das instituições que discutimos.

3.1 Comissão sobre IA de Fronteira: Promovendo o Consenso Científico

Houve várias propostas recentes de um órgão intergovernamental para desenvolver um consenso de especialistas sobre os desafios e oportunidades apresentados pela IA avançada. Instituições existentes como o Painel Intergovernamental sobre Mudanças Climáticas (IPCC), a Plataforma Intergovernamental de Política Científica sobre Biodiversidade e Serviços Ecossistêmicos (IPBES) e o Painel de Avaliação Científica (SAS), que estuda a destruição da camada de ozônio no âmbito do Protocolo de Montreal, fornecem modelos possíveis para uma instituição científica focada em IA. Tal como essas organizações, a Comissão sobre IA de Fronteira poderia facilitar o consenso científico convocando especialistas para realizar avaliações rigorosas e abrangentes dos principais tópicos de IA, tais como intervenções para liberar o potencial da IA para o desenvolvimento sustentável, os efeitos da regulamentação da IA na inovação, a distribuição de benefícios e possíveis capacidades de uso duplo de sistemas avançados e como devem ser geridas.

Funções e Motivação

O consenso internacional sobre as oportunidades e os riscos da IA avançada tem o potencial de facilitar uma ação eficaz para os abordar, por exemplo, gerando um desejo em comum pelo desenvolvimento e a adoção de estratégias eficazes de mitigação de riscos.

Atualmente, existe um desacordo significativo, mesmo entre especialistas, sobre as diferentes oportunidades e desafios criados pela IA avançada17, e essa falta de consenso pode piorar ao longo do tempo, à medida que os efeitos dos sistemas de IA aumentam em escala e número, dificultando a ação coletiva na escala necessária para garantir que a IA seja desenvolvida para o benefício de todos. Além disso, existem vários desafios da IA avançada que podem exigir uma ação internacional antes que os riscos se materializem, e a falta de uma descrição amplamente aceita ou mesmo de um mapeamento das trajetórias de desenvolvimento da IA torna difícil a tomada de tais atitudes preparatórias. Facilitar o consenso entre um grupo de especialistas representativos internacionalmente poderia ser um primeiro passo promissor para expandir os nossos níveis de confiança na previsão e resposta às tendências tecnológicas.

Desafios e Riscos

Desafios científicos de investigação dos riscos no horizonte: compreender os riscos da IA de fronteira e a sua mitigação é desafiador em termos técnicos. A natureza das futuras capacidades de IA e o seu impacto são difíceis de prever, especialmente tendo em conta o rápido ritmo de progresso. Para aumentar as probabilidades de sucesso, a Comissão deve colocar em primeiro plano o rigor científico e a seleção de peritos em IA altamente competentes que trabalhem na vanguarda do desenvolvimento tecnológico e que possam interpretar continuamente o cenário tecnológico e de risco em constante mudança.

Infelizmente, existe uma relativa falta de pesquisa científica sobre os riscos da IA avançada18. Para lidar com a falta de pesquisa científica existente, uma Comissão poderia realizar atividades que atraiam e facilitem uma maior atenção científica, tais como a organização de conferências e workshops e a publicação de pautas de pesquisa. Pode ser útil escrever uma “Estrutura Conceitual” fundamental – seguindo o exemplo do IPBES – para criar uma linguagem e uma estrutura comum que permitam a integração de vertentes diferentes do trabalho existente e abram caminhos para esforços futuros[12].

Politização: uma Comissão sobre IA de Fronteira se beneficiaria, se não necessitaria, de um amortecedor claro entre especialistas encarregados de desenvolver narrativas de consenso em torno dos riscos e oportunidades da IA e decisores políticos que agem de acordo com os interesses políticos e econômicos dos seus Estados, o que poderia impulsionar as políticas em direções diferentes. A compreensão científica dos impactos da IA deveria idealmente ser vista como um bem universal e não ser politizada.

A estrutura de filiação pode afetar a imparcialidade e a legitimidade de uma Comissão: idealmente, haveria uma ampla representação geográfica nos principais órgãos de decisão e uma predominância de peritos científicos em grupos de trabalho19. Infelizmente, dada a natureza incerta e controversa dos avanços dos riscos e oportunidades da IA, a representação pode ser conciliada com a capacidade da Comissão de superar desafios científicos e gerar consenso significativo20. Além de encontrar o equilíbrio correto na filiação, uma Comissão deve delimitar cuidadosamente o assunto da sua investigação — pode, por exemplo, adotar o objetivo do IPCC de ser “relevante em termos de política” sem ser “prescritivo em termos de política”.

Avaliação

O objetivo de uma Comissão sobre IA de Fronteira vale a pena na maioria das circunstâncias, mas os desafios científicos e o potencial de politização implicam que uma Comissão – especialmente uma que visa uma ampla representação política – pode não ser capaz de construir um consenso científico de forma eficaz. O ritmo extraordinário da mudança tecnológica pode exigir respostas políticas mais ágeis, tais como painéis consultivos científicos menos institucionalizados e politicamente influentes sobre IA avançada.

3.2 Organização de Governança da IA Avançada: Promovendo Normas e Padrões, Fornecendo Apoio à Implementação, Monitorando a Conformidade

Tal como discutido acima, determinados riscos de uso indevido e de acidentes de sistemas avançados de IA podem apresentar ameaças globais significativas, e os esforços internacionais destinados a gerir esses riscos poderão valer a pena. Uma organização intergovernamental ou com várias partes interessadas poderia desempenhar uma variedade de funções de governança que promovem a regulamentação de tais sistemas, em particular a definição de normas e padrões, a assistência à implementação e talvez a monitoração da conformidade com as estruturas de governança21.

Funções e Motivação

Identificamos dois objetivos principais para uma Organização de Governança da IA Avançada. A ênfase que deve ser dada a cada um depende dos desafios que pretende enfrentar.

Objetivo 1: internacionalizar e harmonizar a regulamentação da IA. Os regimes regulatórios que estabelecem normas e fornecem apoio à implementação podem ajudar a garantir que capacidades poderosas de IA não apresentam riscos de uso indevido ou de acidentes. O estabelecimento de padrões facilitaria a adoção internacional generalizada ao: 1) reduzir a carga sobre os reguladores nacionais para identificar os regulamentos e protocolos de segurança necessários, 2) gerar pressão normativa para a adoção de protocolos de segurança e 3) reduzir os atritos em torno do desenvolvimento de estruturas internacionais. O apoio à implementação ajudaria o estabelecimento e a manutenção de regimes regulatórios que atendam a essas estruturas. Exemplos de organizações que desempenham funções semelhantes incluem o Grupo de Ação Financeira (GAFI), a União Internacional de Telecomunicações (UIT) e a Organização da Aviação Civil Internacional (OACI).

As mesmas funções são úteis para harmonizar a regulamentação: o estabelecimento de normas internacionais reduziria as fricções transfronteiriças devido a diferentes regimes regulamentares nacionais. (É possível que regulamentos futuros limitem o acesso a tecnologias poderosas de IA em jurisdições com governança da IA inadequada.) O apoio à implementação ajudaria a reduzir os obstáculos aos países que cumprem as normas internacionais e, portanto, permitiria um maior acesso à IA avançada.

Objetivo 2: monitorar o cumprimento. Quando os Estados têm incentivos para comprometer os compromissos regulatórios uns dos outros, podem ser necessárias instituições internacionais para apoiar e incentivar as práticas recomendadas. Isso pode exigir o monitoramento da conformidade com os padrões. No extremo menos intrusivo do espectro está o autorrelato de conformidade com as normas internacionais (como no Acordo de Paris – ver propostas para autorrelato/registo de execuções de treinamento[4]). Organizações como o GAFI, a ICAO e a Organização Marítima Internacional (IMO) adotam uma abordagem um pouco mais intrusiva, monitorando as jurisdições para garantir que adotem regulamentos de práticas recomendadas e, em alguns casos, verificando a aplicação de regulamentos nacionais que incorporam padrões internacionais. No caso da IA avançada, alguns observadores perguntaram se seriam necessárias formas mais intrusivas de supervisão internacional, incluindo a detecção e inspeção de grandes centrais de dados (em parte análogas às proteções da AIEA). Quanto mais intenso e intrusivo for qualquer monitoramento, mais desafiador será chegar a um consenso [35; 43].

Desafios e Riscos

Rapidez e abrangência na definição de normas: um desafio para uma organização de governança é que a definição de normas (especialmente num contexto internacional e multilateral) tende a ser um processo lento, enquanto a natureza rápida e imprevisível do progresso da IA de fronteira pode exigir uma ação internacional mais rápida. Uma Organização de Governança poderá necessitar estabelecer parcerias com organismos especializados de evolução mais rápida e abordagens de definição de normas expeditas. A amplitude do número de membros também pode exigir uma conciliação entre velocidade e diversidade de perspectivas. Uma filiação mais ampla pode ser importante quando o consenso a longo prazo é importante, enquanto os riscos urgentes podem ter de ser abordados inicialmente por grupos menores de Estados de IA de fronteira, ou Estados alinhados com expertise relevante.

Incentivar a participação: o impacto de uma Organização de Governança depende da adoção pelos Estados das suas normas e/ou do acordo com a monitoração. Um amplo acordo (ou acordo entre os Estados de IA de fronteira, pelo menos) sobre os riscos que as normas e a monitoração abordam e o apoio financeiro e técnico para a implementação das normas podem ajudar a induzir a participação dos Estados. Muitos Estados – mesmo aqueles que não são membros de pleno direito da organização – adotam as normas do GAFI porque as consideram como sendo do seu próprio interesse [45]. Outros incentivos de participação específicos à IA incluem o condicionamento do acesso à tecnologia de IA (possivelmente de uma Colaboração da IA de Fronteira) ou a recursos computacionais22. Os Estados também podem adotar restrições à importação de IA de países que não são certificados por uma organização de governança – semelhante, por exemplo, à forma como os Estados proíbem a entrada no seu espaço aéreo de voos provenientes de jurisdições sem certificação da ICAO.

No caso mais distante de acordos de alto risco que regem o desenvolvimento de IA pelos Estados (tais como os tratados de controle de armas), alguns Estados podem estar especialmente relutantes em aderir devido ao receio de incumprimento clandestino por parte de outros Estados. Podem também temer que as inspeções internacionais possam comprometer os segredos de Estado em benefício dos adversários (o que os protocolos de segurança da informação poderiam abordar em parte). Mais uma vez, a atual dependência do desenvolvimento de IA avançada de recursos computacionais significativos pode facilitar o acompanhamento de esforços de IA significativos.23 A monitoração automatizada (mesmo capacitada pela IA) pode permitir uma inspeção mais detalhada de grandes execuções de treinamento sem comprometer os segredos. Tais medidas provavelmente dependeriam de regimes de verificação negociados, e não de meios técnicos nacionais — e a verificação da negociação é sempre complicada (p. ex., no caso da Convenção sobre Armas Químicas) e muitas vezes malsucedida (p. ex., no caso da Convenção sobre Armas Biológicas)[15; 23].

Desafios de delimitação: ao contrário de muitas outras tecnologias – de recursos nucleares até a aviação –, a IA já é amplamente implementada e utilizada por bilhões de pessoas todos os dias. Para operar de forma eficiente e à escala adequada, uma organização de governança deve concentrar-se principalmente em sistemas avançados de IA que apresentam riscos globais significativos, mas será difícil, na prática, decidir sobre a natureza e a sofisticação das ferramentas de IA que devem estar amplamente disponíveis e não controladas versus o conjunto de sistemas que deveriam estar sujeitos à governança nacional ou internacional. A rápida evolução dessas tecnologias agrava o problema, à medida que a fronteira tecnológica avança rapidamente e os modelos que estavam “na fronteira” há um ano estão agora desatualizados e amplamente disponíveis.

Avaliação

Se a IA avançada apresentar riscos de uso indevido e de acidentes de âmbito global, e as defesas técnicas unilaterais não forem suficientes para prover proteção, uma Organização de Governança Internacional pode ser valiosa. No entanto, a sua eficácia dependerá do seu processo de filiação, governança e definição de normas.

Pode ser importante que a governança se aplique a todos os países, e particularmente àqueles cujas empresas estão na fronteira do desenvolvimento de IA. No entanto, os países alinhados podem procurar formar clubes de governança, como fizeram em outros domínios. Isso facilita a tomada de decisões, mas pode dificultar o recrutamento de outros países mais tarde no processo. Não está claro quais processos institucionais satisfariam as exigências de legitimidade e eficácia e incentivariam a participação de grupos importantes de partes interessadas.

3.3 Colaboração da IA de Fronteira: Permitindo o Acesso internacional à IA

Os tomadores de decisão política e os especialistas também propuseram colaborações para desenvolver e distribuir sistemas de IA de ponta, ou para garantir que tais tecnologias sejam acessíveis a uma ampla coalizão internacional [22; 25; 34; 40]. Dado o custo significativo do desenvolvimento de sistemas avançados de IA, uma Colaboração da IA de Fronteira poderia assumir a forma de uma parceria público-privada internacional que aproveitasse a tecnologia e a capacidade existentes na indústria, por exemplo, financiando ou contratando o acesso à inovação em tecnologia de IA apropriada de desenvolvedores de IA de fronteira. Uma tal organização poderia inspirar-se em parcerias público-privadas internacionais como a GAVI – a Aliança das Vacinas – ou o Fundo Global de Luta contra a AIDS, a Tuberculose e a Malária; bem como organizações internacionais que detêm e controlam tecnologias poderosas, como o banco de combustível nuclear da AIEA [32] ou a Autoridade de Desenvolvimento Atômico, que foi proposta após a Segunda Guerra Mundial [51].

Funções e Motivação

Uma Colaboração da IA de Fronteira poderia ser concebida para difundir tecnologia benéfica ou servir como um canal para acesso internacional legítimo à IA avançada.

Difundir tecnologia benéfica: uma colaboração poderia ser estabelecida para garantir que os benefícios da IA de ponta cheguem a grupos que, de outra forma, seriam mal atendidos pelo desenvolvimento da IA. Uma motivação para esse objetivo é que os recursos necessários para desenvolver sistemas avançados tornam o seu desenvolvimento indisponível para muitas sociedades. Isso pode resultar em tecnologias que sejam projetadas e fornecidas inadequadamente aos grupos que mais podem se beneficiar delas por uma série de razões:

- Os sistemas desenvolvidos por atores privados podem não atender adequadamente a todas as sociedades ou grupos demográficos: podem não refletir os valores corretos, não ter as capacidades linguísticas adequadas ou não funcionar de forma eficiente em diversas geografias[30].

- As empresas privadas podem não fixar preços nos seus produtos de uma forma que permita uma distribuição equitativa ou ampla de benefícios.

- A fim de proteger informações proprietárias, as empresas de IA privadas podem não conceder acesso profundo aos seus modelos (p. ex., podem restringir o acesso a APIs para evitar a imitação de modelos [42]), o que poderia impedir o desenvolvimento de casos de uso com benefícios sociais significativos.

Uma Colaboração poderia adquirir ou desenvolver e depois distribuir sistemas de IA para lidar com essas lacunas, reunindo recursos dos Estados-membros e de programas de desenvolvimento internacional, trabalhando com laboratórios de IA de fronteira para fornecer tecnologia apropriada e estabelecendo parcerias com empresas locais, ONGs e governos beneficiários para melhor compreender necessidades tecnológicas e superar barreiras de uso24. Poderia permitir o desenvolvimento de tecnologia que atenda melhor às pessoas menos favorecidas, [30] o acesso de preços a modelos de IA de uma forma que seja equitativa, fornecer educação e construir infraestruturas para permitir o uso eficaz da tecnologia de IA, e estabelecer um paradigma para uma abordagem responsável e desenvolvimento inclusivo de IA. Ao reunir os recursos de múltiplas partes para esses fins (incluindo talentos em segurança, que são atualmente muito escassos na comunidade de IA), um ou mais dos objetivos poderiam ser alcançados de forma mais rápida e eficaz do que no status quo.

Facilitar o acesso internacional legítimo a uma IA poderosa: mais especulativamente, uma Colaboração da IA suficientemente ambiciosa, responsável e legitimamente governada poderia promover os objetivos de governança da IA e reduzir a instabilidade geopolítica no meio de uma feroz concorrência de IA entre Estados. Por exemplo, a filiação a uma Colaboração e o acesso à sua tecnologia segura poderiam ser oferecidos como um incentivo para os países participarem num regime de governança que imponha responsabilidades (tais como acordos para promulgar regulamentação mais rigorosa ou restringir o desenvolvimento de IA militar). A existência de uma coalizão neutra tecnologicamente capacitada também pode mitigar os efeitos desestabilizadores de uma corrida de IA entre Estados, reduzindo as consequências estratégicas de uma parte ficar para trás ou moderar o poder concentrado entre potências concorrentes.

Além disso, a tecnologia da Colaboração poderia ser utilizada para aumentar a resiliência global a sistemas de IA usados indevidamente ou desalinhados, dando aos especialistas uma vantagem inicial no estudo dos tipos de ameaças suscetíveis de ser apresentadas por outros sistemas de IA, e sendo implementados para fins de “proteção”, tais como como corrigir vulnerabilidades de segurança em infraestruturas cruciais, detectar e combater campanhas de desinformação, identificar usos indevidos ou falhas de sistemas implementados ou monitorar a conformidade com regulamentos de IA. Isso seria especialmente útil em cenários onde a queda acentuada dos custos de treinamento (devida ao progresso algorítmico e à lei de Moore) significa que a capacidade de treinar modelos perigosos é amplamente difundida.

Desafios e Riscos

Obstáculos ao benefício do acesso à IA: é provável que seja difícil capacitar significativamente as populações desfavorecidas com tecnologia de IA, uma vez que os obstáculos ao seu benefício da IA são muito mais profundos do que apenas o acesso. Qualquer Colaboração cujo objetivo principal seja o benefício global precisa de ser adequadamente integrada no ecossistema de desenvolvimento global e estabelecida com capacidade significativa ou parcerias para atividades além do desenvolvimento de IA, tais como: compreender as necessidades dos países-membros, construir capacidade de absorção através da educação e infraestruturas e apoiar o desenvolvimento de um ecossistema comercial local para fazer uso da tecnologia [29; 47]. Os recursos necessários para superar esses obstáculos serão provavelmente substanciais e não está claro se tal Colaboração seria um meio eficaz de promover o desenvolvimento.

Difusão de tecnologias de uso duplo: outro desafio para a Colaboração seria gerir o risco de difusão de tecnologias perigosas. Por um lado, para cumprir os seus objetivos, a Colaboração precisaria promover significativamente o acesso aos benefícios da IA avançada (objetivo 1), ou colocar o controle da tecnologia de ponta da IA nas mãos de uma coalizão ampla (objetivo 2). Por outro lado, pode ser difícil fazer isso sem difundir tecnologias perigosas de IA em todo o mundo, se os sistemas de IA mais poderosos forem de uso geral, de uso duplo e proliferarem facilmente25. Esse é especialmente o caso se a Colaboração pretender implementar sistemas de ponta de uso geral para gerir riscos de IA: os tipos de sistemas (e o seu código-fonte e algoritmos subjacentes) capazes de nos proteger significativamente da IA perigosa ou de promover objetivos de governança podem apresentar um risco excepcional de uso indevido, pois provavelmente serão projetados a partir de modelos de uso geral altamente capazes.

Para enfrentar esse desafio, seria importante que a Colaboração tivesse um mandato e um propósito claros. Os membros de uma Colaboração precisariam ter uma forte compreensão dos riscos dos modelos que estão sendo desenvolvidos agora e no futuro, e suas implicações para a distribuição de modelos, segurança da organização (especialmente restrições ao movimento dos pesos dos modelos da Colaboração) e outras atividades que podem afetar sua capacidade de se beneficiar da Colaboração. Só assim a Colaboração seria capaz de implementar consistentemente os controles necessários para gerir os sistemas de fronteira. Também poderá ser necessário excluir da participação Estados que provavelmente queiram utilizar a tecnologia de IA de formas não pacíficas, ou fazer da participação num regime de governança a pré-condição para a filiação.

Avaliação

Uma Colaboração da IA de Fronteira pode de fato ser uma forma viável de espalhar os benefícios da IA. No entanto, os obstáculos significativos às sociedades que se beneficiam do acesso à IA levantam questões sobre a sua competitividade (em relação a outras iniciativas de desenvolvimento) como forma de promover o bem-estar das comunidades desfavorecidas.

A viabilidade de uma Colaboração como local de tecnologia legitimamente controlada também não é clara: depende de saber se é possível encontrar um equilíbrio entre a procura legítima de tecnologias suficientemente poderosas para afetar positivamente a estabilidade internacional e a gestão da proliferação de sistemas perigosos.

3.4 Projeto de Segurança da IA: Conduzindo Pesquisa Técnica de Segurança

O modelo final que discutimos é uma colaboração internacional para conduzir pesquisas técnicas de segurança da IA26 em uma escala ambiciosa27.

O Projeto de Segurança seria modelado a partir de colaborações científicas de grande escala como o ITER (Reator Experimental Termonuclear Internacional) e o CERN (Conselho Europeu para a Pesquisa Nuclear). Concretamente, seria uma instituição com capacidade significativa de computação, engenharia e acesso a modelos (obtidos através de acordos com os principais desenvolvedores de IA) e recrutaria os principais especialistas mundiais em IA, segurança da IA e outras áreas relevantes para trabalharem em colaboração sobre como projetar e implementar sistemas avançados de IA de modo que sejam confiáveis e menos suscetíveis de ser usados indevidamente. O CERN e o ITER são colaborações intergovernamentais; observamos que um Projeto de Segurança da IA não precisa, e deveria, ser organizado para beneficiar-se da experiência em Segurança da IA na sociedade civil e no setor privado.

Funções e Motivação

A motivação por trás de um Projeto de Segurança internacional seria acelerar a pesquisa de segurança da IA, aumentando sua escala, recursos e coordenação, expandindo assim modos como a IA pode ser implementada com segurança e mitigando os riscos decorrentes de poderosas capacidades de uso geral28. Os investigadores – incluindo aqueles que de outra forma não estariam trabalhando na segurança da IA – poderiam ser atraídos pela sua estatura internacional e capacitados pela excepcional computação, engenheiros e acesso ao modelo do projeto. O Projeto se tornaria uma comunidade de investigação vibrante que se beneficiaria de fluxos de informação mais restritos e de um foco coletivo na segurança da IA. O Projeto também deve ter líderes e estruturas de governança excepcionais que garantam que os seus esforços sejam direcionados da forma mais eficaz para questões cruciais no caminho para sistemas de IA mais seguros.

Dado que as percepções do risco da IA variam em todo o mundo, tal esforço seria provavelmente liderado por atores concientes dos riscos de fronteira, como os governos dos EUA e do Reino Unido, laboratórios de inteligência geral artificial e grupos da sociedade civil. A longo prazo, seria importante que a filiação fosse ampla para garantir que a sua investigação fosse reconhecida e informasse o desenvolvimento e a implementação de IA em todo o mundo29.

Desafios e Riscos

Afastar a pesquisa de segurança dos desenvolvedores de fronteira: um efeito potencial deste modelo é que ele desvia a pesquisa de segurança dos locais de desenvolvimento da IA de fronteira. É possível que a pesquisa sobre segurança seja melhor conduzida em estreita proximidade com o desenvolvimento de IA, para aprofundar a compreensão dos pesquisadores de segurança sobre os processos e sistemas que estão tentando tornar seguros e para garantir que haja conhecimentos de segurança adequados a nível interno. Esse risco poderia ser abordado oferecendo aos pesquisadores de segurança nos laboratórios de IA duplas nomeações ou funções consultivas no Projeto, e pode se tornar um problema menor se a prática da segurança da IA se tornar institucionalizada e separada da Pesquisa e Desenvolvimento.

Preocupações de segurança e acesso a modelos: para serem eficazes, os participantes do Projeto precisam ter acesso a modelos avançados de IA, o que pode lhes permitir copiar ilegalmente os pesos do modelo, clonar o modelo através do acesso aos seus resultados [42] ou compreender como poderia ser replicado (determinando sua arquitetura ou processo de treinamento). Dada a importância desses recursos para os interesses comerciais dos laboratórios de fronteira, pode ser difícil negociar acordos onde seja concedido acesso a modelos adequados. Pode também levar à difusão de tecnologias perigosas.

Essa questão pode ser resolvida através da restrição da filiação ao Projeto de Segurança e através de medidas de segurança da informação. Em particular, pode ser possível isolar informações, estruturar o acesso a modelos e projetar processos de revisão interna de forma a reduzir significativamente esse risco, garantindo ao mesmo tempo que os resultados de pesquisa sejam sujeitos a um escrutínio científico adequado. Certos tipos de pesquisa, como o desenvolvimento de avaliações de modelos e protocolos de “equipe vermelha” (red-teaming), podem prosseguir efetivamente com acesso de API aos modelos, enquanto outros, como interpretabilidade de mecanismos, exigirão acesso aos pesos e arquiteturas do modelo, mas podem não precisar trabalhar com os modelos mais recentes (e, portanto, mais sensíveis) [37].

Avaliação

O progresso técnico sobre como aumentar a confiabilidade dos sistemas avançados de IA e protegê-los do uso indevido será provavelmente uma prioridade na governança da IA. Resta saber se – devido a questões de acesso a modelos e de alocação de especialistas entre um Projeto de Segurança e locais de desenvolvimento da IA de fronteira – um Projeto de Segurança da IA será a forma mais eficaz de atingir esse objetivo.

3.5 Combinando Funções Institucionais

Podemos imaginar as instituições assumindo o papel de vários dos modelos acima. Por exemplo, a Comissão sobre a IA de Fronteira e o Projeto de Segurança da IA estabelecem uma combinação óbvia: uma Comissão poderia amplificar as funções de pesquisa para complementar os esforços de síntese e de construção de consenso, ou um Projeto poderia realizar um trabalho de síntese no decurso das suas atividades e gradualmente assumir um papel de estabelecimento de consenso. Uma Colaboração da IA de Fronteira provavelmente também conduziria pesquisas de segurança e poderia facilmente absorver recursos adicionais para se tornar um Projeto de Segurança na liderança mundial.

Notas

1. Por “sistemas de IA avançada” queremos dizer sistemas altamente capazes e de uso geral.

2. Instituições semelhantes incluem o Painel Intergovernamental sobre Mudanças Climáticas (IPCC), a Plataforma Intergovernamental de Política Científica sobre Biodiversidade e Serviços Ecossistêmicos (IPBES) e o Painel de Avaliação Científica do Programa Ambiental das Nações Unidas.

3. Cf. a Organização da Aviação Civil Internacional (ICAO), a Agência Internacional de Energia Atómica (AIEA) e o Grupo de Acão Financeira (GAFI).

4. Cf. parcerias público-privadas internacionais como a GAVI, a Aliança para Vacinas, e o Fundo Global de Luta contra a AIDS, a Tuberculose e a Malária; bem como organizações que detêm tecnologias perigosas, como o banco de combustível nuclear da AIEA e a Autoridade de Desenvolvimento Atômico proposta após a Segunda Guerra Mundial.

5. Cf. colaborações científicas como o Conselho Europeu para a Pesquisa Nuclear (CERN) e o ITER.

16. Veja, p. ex., [27; 33].

17. Veja, p. ex., o desacordo sobre se a IA avançada poderia representar um risco de extinção: [9; 31].

18. A recente avaliação do IPCC, para referência, foi escrita por 234 cientistas de 66 Estados e baseou-se em 14.000 artigos científicos.

19. Se a legitimidade for a principal preocupação, a Comissão poderia adotar a inovação do IPCC de redigir documentos importantes por consenso, equilibrando a inclusão (representantes dos Estados e cientistas revisam, discutem e aprovam o relatório linha por linha) e o rigor científico (todos as alterações sugeridas devem ser acompanhadas do relatório científico do grupo de trabalho que está sendo resumido) [36].

20. Se seguir o modelo do IPCC, os especialistas serão nomeados pelos Estados-membros, mas não haverá uma resiliente disciplina de ciência do clima para se proteger dos interesses políticos.

21. Veja, por exemplo, [2; 10; 13; 28; 46] para discussões e propostas de uma instituição desse tipo.

22. A indústria de computação em nuvem e a cadeia de suprimentos de semicondutores subjacente estão concentradas em um pequeno número de países.

23. A supervisão de centrais de dados pode permitir a detecção de grandes execuções de treinamento que estão sujeitas a controles internacionais. Veja [8; 35].

24. Por exemplo, a GAVI promove a imunização, por ex. financiando a inovação e negociando contratos em grande escala com empresas farmacêuticas (especialmente compromissos de mercado avançados) para programas de vacinação em países de baixa renda[16].

25. Por exemplo: pode ser difícil proteger modelos amplamente implementados da imitação e pode ser difícil proteger a canalização da implementação de tentativas de copiar pesos de modelos.

26. Isso poderia incluir trabalho na compreensão e avaliação das características dos sistemas, como alinhamento/confiabilidade e capacidades perigosas, métodos de treinamento para reduzir e gerenciar essas características e protocolos de implementação (como segurança do sistema, monitoramento, resposta a acidentes) que são apropriados para diferentes características do sistema.

27. Veja, p. ex., [11; 19]

28. Sendo um bem público, a segurança da IA pode ser subfinanciada por padrão, o que o Projeto de Segurança abordaria como um local de contribuição coletiva.

29. Embora os insights relevantes para a segurança devam ser divulgados para uso internacional, outras inovações com valor comercial podem ser propriedade coletiva ou licenciadas de forma acessível aos Estados-membros para incentivar uma ampla participação. Veja, p. ex., a abordagem do CERN a isso [26].

Publicado originalmente em 2023 aqui.

Autores:

Lewis Ho1, Joslyn Barnhart1, Robert Trager2, Yoshua Bengio3, Miles Brundage4 , Allison Carnegie5 , Rumman Chowdhury6 ,Allan Dafoe1, Gillian Hadfield7, Margaret Levi8, Duncan Snidal9

1Google DeepMind, 2Blavatnik School of Government, University of Oxford and Centre for the Governance of AI, 3Université de Montréal and Mila, CIFAR Fellow, 4OpenAI, 5Columbia University, 6Harvard Berkman Klein, 7University of Toronto, Vector Institute and OpenAI (independent contractor), 8Stanford University, 9Nuffield College, University of Oxford

Tradução: Luan Marques