De Lennart Heim e Jeffrey Ladish. 2 de maio de 2022.

| Novas tecnologias em desenvolvimento, mais notoriamente a inteligência geral artificial (IGA), podem apresentar uma ameaça existencial à humanidade. Esperamos uma pressão competitiva significativa em torno do desenvolvimento da IGA, incluindo um interesse significativo da parte de atores estatais. |

Índice

Resumo

Esta postagem é de autoria de Jeffrey Ladish, que trabalha na equipe de segurança da Anthropic, e Lennart Heim, que trabalha em governança da IA com a GovAI (mais sobre nós no final ). As opiniões na postagem são nossas e não falam pela Anthropic ou pela GovAI. Esta postagem dá continuidade à postagem de 2019 de Claire Zabel e Luke Muehlhauser, Carreiras em segurança da informação para redução de riscos catastróficos globais .

Gostaríamos de fornecer uma breve visão geral sobre:

- Como a segurança da informação pode impactar o futuro a longo prazo

- Por que gostaríamos que a comunidade priorizasse a segurança da informação

Numa postagem seguinte, exploraremos:

- Como você poderia orientar sua carreira para trabalhar com a segurança

Resumo mais compacto:

- Novas tecnologias em desenvolvimento, mais notoriamente a inteligência geral artificial (IGA), podem apresentar uma ameaça existencial à humanidade. Esperamos uma pressão competitiva significativa em torno do desenvolvimento da IGA, incluindo um interesse significativo da parte de atores estatais. Desse modo, existe um grande risco de que agentes de ameaças avançados invadam organizações — que desenvolvam IGA, forneçam suprimentos cruciais a empresas de IGA ou possuam informações estrategicamente relevantes — para obterem uma vantagem competitiva no desenvolvimento de IGA. Limitar a capacidade de agentes de ameaças avançados de comprometer as organizações que trabalham no desenvolvimento de IGA e os seus fornecedores poderia reduzir o risco existencial, diminuindo as pressões competitivas sobre as organizações de IGA e tornando mais difícil para atores incautos ou não cooperativos desenvolver sistemas de IGA.

Qual é a relevância da segurança da informação para o futuro a longo prazo?

A maior parte do risco existencial provavelmente decorre de tecnologias que os humanos podem desenvolver. Entre as tecnologias candidatas, pensamos que a IGA e, em menor medida, a biotecnologia, têm maior probabilidade de causar a extinção humana. Entre as tecnologias que apresentam uma ameaça existencial, a IGA é singular no que tem o potencial de mudar permanentemente o panorama de riscos e permitir um futuro estável sem riscos significativos de extinção ou outros desastres permanentes. Embora os especialistas na área tenham divergências significativas sobre como navegar de forma responsável no caminho para uma IGA poderosa e alinhada, eles tendem a concordar que os atores que buscam desenvolver a IGA devem ser extremamente cautelosos no processo de desenvolvimento, testagem e implementação, uma vez que as falhas podem resultar em riscos catastróficos, inclusive a extinção humana.

O NIST define segurança da informação como “A proteção da informação e dos sistemas de informação do acesso, uso, divulgação, interrupção, modificação ou destruição não autorizados”.

Acreditamos que caminhos seguros para uma IGA alinhada exigirão um esforço extraordinário de segurança da informação pelas seguintes razões:

- Atores insuficientemente responsáveis ou mal-intencionados provavelmente terão como alvo organizações que desenvolvem IGA, fornecedores de software e hardware e organizações de apoio para obter uma vantagem competitiva.

- Assim, proteger esses sistemas reduzirá o risco de que sistemas de IGA poderosos sejam desenvolvidos por atores incautos que hackeiam outros grupos.

Ok, mas por que é necessário um esforço extraordinário ?

- Caminhos plausíveis para a IGA, especialmente se se parecerem com sistemas de IA existentes, expõem uma enorme superfície de ataque porque são construídos utilizando sistemas de computação complexos com cadeias de suprimento de software e hardware muito expansivas.

- Proteger sistemas tão complexos como sistemas de IGA é extremamente difícil, e a maioria das tentativas de fazer isso falharam no passado, mesmo quando os riscos eram grandes: por exemplo, o Projeto Manhattan.

- A dificuldade de defender um sistema depende do modelo de ameaça, ou seja, dos recursos que um invasor utiliza para atingir um sistema. As organizações que desenvolvem IGA provavelmente serão alvos de atores estatais avançados que estão entre os hackers mais capazes.

Embora esse seja um problema desafiador que exige um esforço extraordinário, pensamos que vale a pena buscar os investimentos, e que as medidas atuais são insuficientes.

O que significa proteger um sistema de IA?

Pode ser útil imaginar cenários concretos quando se pensa em segurança da IA: a segurança dos sistemas de IA. Gwern escreveu recentemente uma versão fictícia convincente de um desses cenários, incluindo algumas falhas plausíveis de segurança da informação, que recomendamos conferir.

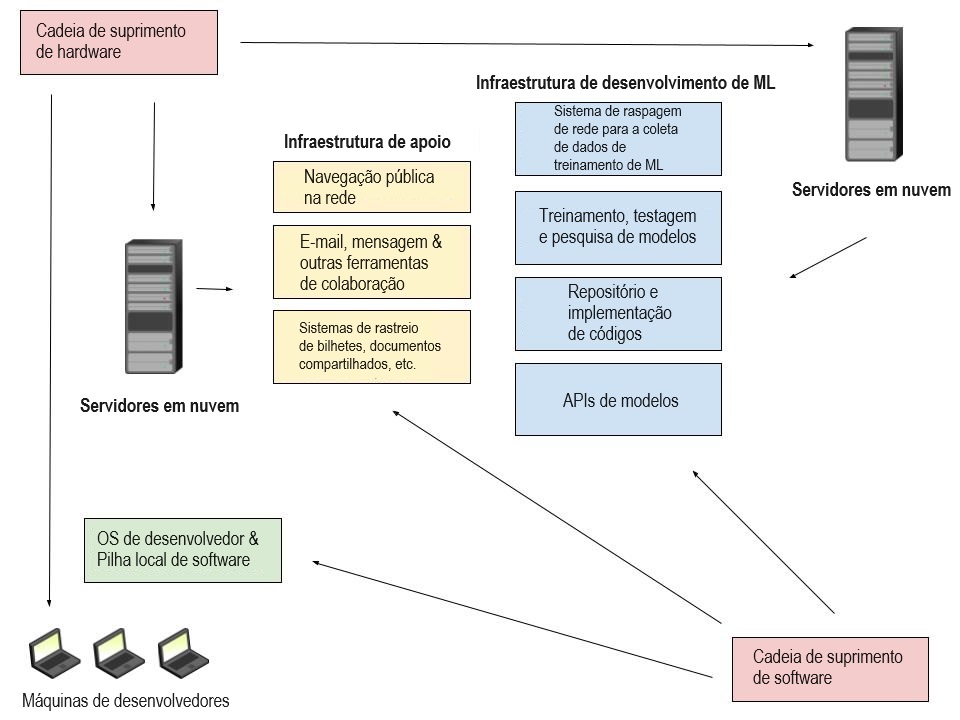

O pessoal da segurança da informação costuma pensar nos sistemas em termos de superfície de ataque. Quão complexo é o sistema, quantos componentes ele possui, quão atacável é cada componente, etc.? O desenvolvimento de um sistema de IA moderno como o GPT-3 envolve muitos pesquisadores e desenvolvedores: o artigo do GPT-3 teve 31 autores! Cada desenvolvedor tem seu próprio notebook e precisa de algum acesso aos modelos em que trabalha. Normalmente, o código é executado na infraestrutura em nuvem e há muitos componentes que compõem essa infraestrutura. Os dados precisam ser coletados e limpos. Os pesquisadores precisam de sistemas para treinar e testar modelos. No caso do GPT-3, é criada uma API para conceder acesso limitado a pessoas de fora da empresa.

A maioria dos componentes descritos aqui contém uma quantidade impressionante de complexidade (veja a Figura 1). Por exemplo, só o kernel do Linux contém mais de 20 milhões de linhas de código. Cada peça de hardware e software é um componente que pode ser explorado. O desenvolvedor pode estar usando um plug-in de um navegador malicioso que rouba código-fonte, ou seu software-antivírus pode estar exfiltrando informações críticas silenciosamente. A infraestrutura de nuvem subjacente pode ser comprometida, seja devido a explorações subjacentes no provedor de nuvem, seja devido a configurações incorretas, ou um software vulnerável introduzido pela organização.

E esses são apenas os componentes técnicos. O que não é retratado são os humanos criando e usando os sistemas de software e hardware. Os operadores humanos são geralmente a parte mais fraca de um sistema de computação. Por exemplo, os desenvolvedores ou administradores de um sistema podem ser vítimas de phishing, os telefones usados para sistemas de autenticação multifatorial podem sofrer clonagem de chip ou as senhas das principais contas podem ser redefinidas através da exploração de funcionários do suporte técnico. Isso geralmente é descrito como engenharia social. Em suma, os sistemas modernos de IA são sistemas muito complexos construídos por muitas pessoas e, portanto, são fundamentalmente difíceis de proteger.

Atores de ameaças e IGA

Proteger um projeto moderno de IA de ataques de cibercriminosos em geral — como operadores de ransomware, extorsionários, etc. — é difícil, mas não extraordinariamente difícil. Proteger um sistema tão complexo como um sistema de IA moderno de um ator estatal ou um ator de Ameaça Persistente Avançada (APT) é extremamente difícil, como demonstram os exemplos na seção de falhas de classe de referência. Acreditamos que é bastante provável que atores estatais visem cada vez mais as organizações que desenvolvem IGA pelas razões listadas abaixo:

- As capacidades de IA a curto prazo podem dar aos Estados vantagens militares significativas

- Os laboratórios de IA de última geração possuem propriedade intelectual valiosa e são, portanto, um alvo rico para espionagem industrial patrocinada pelo Estado.

- Conceitos do valor estratégico da IGA estão presentes e acessíveis na nossa cultura atual

Os EUA , a China , a Rússia , Israel e muitos outros Estados estão atualmente agindo como se as capacidades de IA modernas e de curto prazo tivessem o potencial de melhorar os sistemas de armas estratégicas, incluindo veículos aéreos não tripulados (UAVs), veículos subaquáticos não tripulados (UUVs), detecção submarina , sistemas de detecção de mísseis e ferramentas de hackeamento.

Algumas dessas áreas já foram objeto de atividades bem-sucedidas de hackers estatais. O pesquisador do Open Philanthropy Project, Luke Muelhauser, compila vários exemplos neste documento, incluindo: “Em 2011-2013, hackers chineses atacaram mais de 100 empresas de drones dos EUA, incluindo grandes empreiteiros de defesa, e roubaram projetos e outras informações relacionadas à tecnologia de drones… Pasternack (2013); Ray (2017).

Não é evidente que a espionagem destinada a tecnologias estratégicas de IA terá necessariamente como alvo os laboratórios que trabalham em IGA se a própria IGA não for reconhecida como uma tecnologia estratégica, talvez porque seja considerada demasiado distante para ser benéfica. No entanto, parece provável que os laboratórios de IGA desenvolvam aplicações mais úteis à medida que se aproximam de sistemas de IGA capazes, e que algumas dessas aplicações vão abordar áreas com as quais os Estados se preocupam. Por exemplo, a China utilizou propaganda automatizada para atingir as eleições de Taiwan em 2018 e poderia estar plausivelmente interessada em roubar modelos de linguagem como o GPT-3 para essa finalidade. Tecnologias de geração de código como o Codex e o AlphaCode também podem ter aplicações militares, talvez como ferramentas de hackeamento.

Além da utilidade militar direta dos sistemas de IA, é também provável que ocorra espionagem patrocinada pelo Estado para efeitos de competição econômica. As empresas de IA angariaram 216,6 bilhões de dólares em investimentos, com pelo menos alguns bilhões angariados por empresas que tentam especificamente buscar o desenvolvimento de IGA, o que as torna um alvo econômico valioso. Conforme já descrito, o roubo de propriedade intelectual para o próprio desenvolvimento de IGA ou para recursos críticos necessários é do interesse de atores mal-intencionados, como nações ou empresas. Se violações de propriedade intelectual forem difíceis de detectar ou executar, isso torna a espionagem industrial especialmente atraente.

A razão mais preocupante pela qual os Estados podem ter como alvo os laboratórios de IGA é que eles podem acreditar que a IGA é uma tecnologia estrategicamente importante. Os militares e as agências de inteligência têm acesso aos mesmos argumentos que convenceram a comunidade do altruísmo eficaz de que o risco da IA é importante. Nick Bostrom discute as potenciais implicações estratégicas da IGA em Superinteligência (2014, cap. 5). Tal como aconteceu com o desenvolvimento inicial de armas nucleares, os Estados podem temer que os seus rivais possam desenvolver IGA antes deles.

Note-se que é a percepção dos atores estatais que importa nesses casos. Os Estados podem considerar as novas capacidades de IA como tendo benefícios estratégicos, mesmo que não tenham. Da mesma forma, se as tecnologias de IA têm potencial para um impacto estratégico, mas os atores estatais não o reconhecem, então a espionagem estatal é menos preocupante.

Outros alvos

Além de visar organizações que desenvolvem sistemas de IGA, também pensamos que organizações que (a) fornecem recursos cruciais para laboratórios de IGA ou (b) pesquisam e desenvolvem estratégias de governança da IGA também estão em risco:

- Os fornecedores de recursos cruciais, como infraestrutura computacional ou software, são de relevância significativa para as organizações de IGA. Esses suprimentos geralmente vêm de fornecedores externos. A segmentação de fornecedores é uma prática comum para os atores estatais que tentam obter acesso a alvos de elevado valor. Além disso, o roubo de propriedade intelectual (IP) de fornecedores externos poderia aumentar a capacidade de um ator mal-intencionado de desenvolver recursos relevantes (dos quais poderia ter sido anteriormente excluído devido a proibições de exportação).

- Acreditamos que os pesquisadores da Governança da IA também podem ser alvos se forem considerados detentores de informações estratégicas sobre sistemas de IA em desenvolvimento. É provável que atores estatais estejam especialmente interessados em obter informações sobre organizações nacionais e aquelas relevantes para as forças armadas.

Falhas de classe de referência

Ao tentar compreender a dificuldade de proteger os sistemas de IA, é útil observar falhas notáveis na proteção de informações críticas e formas de mitigá-las. Não faltam exemplos – para uma lista mais abrangente, consulte esta lista compartilhada de exemplos de violações de segurança da informação de alto risco de Luke Muehlhauser. Queremos apresentar alguns exemplos recentes, percorrendo o continuum desde ataques altamente técnicos patrocinados pelo Estado até ataques de engenharia social relativamente simples, mas devastadores.

Um exemplo recente de ataque altamente técnico é o Pegasus 0-click exploit. Desenvolvido pelo grupo NSO, uma empresa de software que vende “tecnologia para combater o terrorismo e o crime apenas aos governos”, esse ataque permitiu aos atores obter o controle total do iPhone da vítima (leitura de mensagens, ficheiros, espionagem, etc.). Foi usado para espionar ativistas dos direitos humanos e também esteve ligado ao assassinato de Jamal Khashoggi. Conforme descrito nesta postagem do Project Zero da Google, esse ataque foi altamente sofisticado e exigiu uma quantidade significativa de recursos para seu desenvolvimento, custando milhões de dólares para os atores estatais comprarem.

Do outro lado do continuum, temos o sequestro de contas do Twitter em 2020, no qual hackeadores obtiveram acesso a ferramentas internas do Twitter manipulando um pequeno número de funcionários para obter acesso às suas credenciais. Isso permitiu que eles assumissem contas no Twitter de figuras proeminentes, como Elon Musk e Bill Gates; e tudo isso provavelmente foi feito por alguns adolescentes.

Outro ataque mais recente, que provavelmente também dependeu fortemente de táticas de engenharia social, é o hackeamento da NVIDIA pelo grupo Lapsus$. Esse ataque é especialmente interessante porque a NVIDIA é um ator importante no desenvolvimento de chips de IA. O vazamento de sua propriedade intelectual (PI) e o potencial uso por atores menos cautelosos poderiam acelerar os esforços dos concorrentes no desenvolvimento de chips de IA mais poderosos, violando ativamente as normas de PI de terceiros. Notavelmente, embora o alvo do grupo de hackers seja um alvo de interesse para atores estatais, temos alguns primeiros indícios de que esse ataque pode, na verdade, ter sido conduzido por vários adolescentes.

O sequestro de contas do Twitter e o recente hackeamento da NVIDIA são notáveis, pois os recursos necessários para esses ataques eram relativamente pequenos. Esforços mais significativos e boas práticas de segurança poderiam ter atenuado esses ataques ou, pelo menos, tê-los tornado significativamente mais caros. As empresas que são de importância estratégica, ou no que diz respeito a este artigo, organizações relevantes para o desenvolvimento de sistemas de IGA, devem se beneficiar da melhor segurança e estar num nível de segurança semelhante ao dos governos nacionais, dada a sua importância para a segurança (nacional).

A aplicabilidade da mentalidade de segurança ao trabalho de alinhamento

Uma boa engenharia envolve pensar em como as coisas podem funcionar; a mentalidade de segurança envolve pensar em como as coisas podem falhar.

Além de proteger informações que poderiam desempenhar um papel descomunal no futuro da humanidade, pensamos que o campo da segurança da informação também apresenta formas de pensar que são essenciais para os esforços de alinhamento da IA. Essas ideias são descritas no post Mentalidade de Segurança e Paranoia Corriqueira de Eliezer Yudkowsky e na postagem seguinte Mentalidade de Segurança e a Curva de Sucesso Logístico. A mentalidade de segurança é a prática de olhar para um sistema pelas lentes da otimização adversária, não apenas procurando maneiras de explorar o sistema, mas procurando fraquezas sistêmicas que possam ser abusadas mesmo que o caminho para a exploração não seja óbvio. No segundo post, Eliezer descreve o tipo de cenário no qual a mentalidade de segurança é crucial para construir um sistema seguro:

…este cenário pode ser válido sempre que exigimos resiliência de um sistema complexo que está sujeito a fortes pressões de otimização externas ou internas… Pressões que promovem fortemente as probabilidades de estados de coisas particulares através de uma otimização que busca um espaço de estados grande e complexo… Pressões que, portanto, por sua vez, sujeita outras subpartes do sistema à seleção de estados estranhos e caminhos de execução anteriormente não previstos… Especialmente se algumas dessas pressões puderem ser, em algum sentido, criativas e encontrar estados do sistema ou um ambiente que nos surpreendem ou violam nossas generalizações superficiais…

Esse cenário descreve códigos de segurança cruciais, como kernels de sistemas operacionais, e descreve sistemas de IGA ainda mais. Os sistemas de IGA são incrivelmente perigosos porque são otimizadores poderosos e opacos e é improvável que os engenheiros humanos tenham uma boa compreensão do escopo, escala ou alvo de seu poder de otimização à medida que são criados. Acreditamos que essa tarefa provavelmente falhará sem uma aplicação séria da mentalidade de segurança.

Aplicar a mentalidade de segurança significa ir além de apenas imaginar maneiras pelas quais seu sistema pode falhar. Por exemplo, se você está preocupado que seu modelo de gravação de código com capacidades incertas possa constituir uma ameaça à segurança e decide que isolá-lo em um contêiner Docker é suficiente, então você não conseguiu aplicar a mentalidade de segurança. Se suas ferramentas de interpretabilidade continuarem mostrando que seus modelos dizem coisas que sua representação interna sabe que são falsas, e você decidir usar o resultado das ferramentas de interpretabilidade para treinar o modelo para evitar falsidades, então você não conseguiu aplicar a mentalidade de segurança.

A mentalidade de segurança é difícil de aprender e ainda mais difícil de ensinar. Ainda assim, pensamos que uma maior interação entre a comunidade de segurança da informação e a comunidade de alinhamento da IA poderia ajudar mais pesquisadores de IA a desenvolver competências nessa área e a melhorar a cultura de segurança das organizações de IA.

Construindo agora a infraestrutura relevante de segurança da informação

Acreditamos que os laboratórios que desenvolvem sistemas de IGA poderosos devem priorizar a construção de sistemas de informação seguros para se protegerem do roubo e do abuso desses sistemas. Além disso, pensamos também que outros atores relevantes, como organizações que trabalham em pesquisa estratégica ou fornecedores críticos, estão cada vez mais se tornando um alvo e também precisam investir em controles de segurança da informação.

O nosso apelo à comunidade de alinhamento e governança da IA é que leve a sério a segurança da informação agora, a fim de construir uma base sólida à medida que as ameaças se intensificam. A segurança não é um recurso fácil de implementar posteriormente. Há muitos alvos fáceis: uso de dispositivos e software atualizados, criptografia de ponta a ponta, autenticação multifatorial forte, etc. Configurar esses controles é um excelente primeiro passo e tem um alto retorno de investimento. No entanto, controles resilientes de segurança da informação exigirão investimentos e compensações difíceis. As pessoas são geralmente o ponto fraco dos sistemas de informação. Portanto, o treinamento e a verificação de antecedentes são essenciais.

As necessidades de segurança da informação provavelmente se tornarão muito mais exigentes à medida que os laboratórios de IGA, e aqueles associados aos laboratórios de IGA, forem alvos de ataques cada vez mais persistentes e sofisticados. Nos recentes ataques do Lapsus$, as contas pessoais foram frequentemente alvos de acesso aos sistemas 2FA para comprometer as contas da empresa. Ferramentas como o Pegasus, já utilizadas por agências em dezenas de países, poderiam facilmente ser utilizadas contra aqueles que trabalham em políticas e pesquisa em IA.

Embora pudéssemos fazer muitas recomendações de segurança mais específicas, queremos enfatizar a importância da sensibilização para as ameaças e do investimento em infraestruturas seguras, em vez de qualquer controle específico. Apesar disso, se você tiver dúvidas sobre controles de segurança específicos ou quiser ajuda para tornar sua organização mais segura, fique à vontade para entrar em contato! Parte do nosso objetivo é ajudar as organizações que estão apenas começando a pensar em segurança, bem como ajudar as organizações existentes a aprimorar seus programas de segurança.

Conclusão

Neste post, apresentamos nosso argumento sobre a importância da segurança da informação para o futuro a longo prazo. Na próxima postagem, daremos algumas sugestões concretas sobre como as pessoas podem contribuir para solucionar o problema, incluindo:

- 1) como saber se uma carreira em segurança da informação é uma boa ideia para você

- 2) como orientar sua carreira para a segurança da informação e

- 3) como outras pessoas que trabalham para reduzir o risco de IA podem adquirir e incorporar habilidades de segurança da informação em seu trabalho existente

Enquanto isso, você pode interagir com outras pessoas em discussões relacionadas no grupo do Facebook de Segurança da Informação no Altruísmo Eficaz.

Sobre nós

Sobre Jeffrey

- Trabalho na equipe de segurança da Anthropic (estamos contratando!), e também estou trabalhando na construção de campo e na estratégia em segurança da IA. Desempenhei diversas funções em minha carreira de segurança da informação: trabalhei como engenheiro de segurança na Concur Technologies, liderei esforços de segurança para a empresa de criptomoeda Reserve e, em seguida, iniciei meu próprio negócio de consultoria de segurança. Também passei alguns anos explorando os riscos existenciais e catastróficos das armas nucleares e da biotecnologia. Você pode encontrar alguns dos meus trabalhos aqui: https://jeffreyladish.com

Sobre Lennart

- Trabalho na interseção entre hardware de IA e governança da IA. Antes disso, estudei Engenharia da Computação e tenho um interesse de longa data por segurança (embora nunca tenha trabalhado profissionalmente em tempo integral nessa área). Trabalhava com segurança como assistente de pesquisa em sistemas sem fio e em rede ou nas horas vagas, principalmente em sistemas embarcados e servidores web.

Agradecimentos

Muito obrigado a Ben Mann, Luke Muehlhauser, Markus Anderljung e Leah McCuan pelo feedback sobre esta postagem.

Tradução: Luan Marques

Link para o original