Pablo Stafforini: Em 9 de julho de 2014, Nick Bostrom fez uma palestra sobre Considerações Cruciais e Conselhos sobre Filantropia na Good Done Right, uma conferência sobre altruísmo eficaz que ocorreu no All Souls College, em Oxford. Achei a palestra tão valiosa que decidi transcrevê-la.

Transcrição completa

Esta palestra se baseará em algumas das ideias que Nick Beckstead estava comentando antes do almoço. Ao contrário da apresentação dele, porém, esta não está tão bem apresentada.

Este é um trabalho em andamento, então tomaremos alguns atalhos, alguns pontos podem estar confusos etc. Mas estou ansioso pela discussão que se seguirá.

O que é uma consideração crucial?

Bom, quero falar sobre esse conceito de consideração crucial, que aparece no trabalho que temos feito bastante. Suponha que você esteja numa floresta e tenha um mapa e uma bússola, e esteja tentando encontrar um destino. Você está carregando algum peso, talvez tenha muita água porque precisa se hidratar para alcançar seu objetivo e carregar peso, e tenta acertar a direção exata em que está indo. Está tentando descobrir quanta água pode jogar fora, para aliviar o peso sem ficar sem água antes de chegar ao seu destino.

Todas essas são considerações normais: você está ajustando a forma como vai conseguir progredir mais rapidamente em direção ao seu objetivo. Mas então, você olha mais de perto para a bússola que está usando e percebe que a parte do ímã se soltou. Isso significa que a agulha pode estar apontando para uma direção completamente diferente que não tem nenhuma relação com o Norte: ela pode ter rodado inúmeras voltas ou ter feito partes de uma volta.

Com essa descoberta, agora você perdeu totalmente a confiança em todo o raciocínio anterior que se baseava na tentativa de obter uma leitura mais precisa da direção para onde a agulha apontava. Isso seria um exemplo de uma consideração crucial no contexto da orientação. A ideia é que poderia haver tipos similares de considerações em contextos mais importantes, que nos jogam completamente para fora do rumo. Então, uma consideração crucial é aquela que, se fosse levada em consideração, faria uma reviravolta nas conclusões a que chegaríamos sobre como devemos direcionar nossos esforços, ou uma ideia ou argumento que possa revelar a necessidade não apenas de algum ajuste menor no curso das nossas iniciativas, mas uma grande mudança de direção ou de prioridade.

Dentro do contexto utilitário, pode-se talvez tentar explicar da seguinte forma: uma consideração crucial é aquela que muda radicalmente o valor esperado da busca por alguma submeta de alto nível. A ideia aqui é que a pessoa tem um padrão de avaliação fixo, e faz um plano geral para atingir uma submeta de alto nível. Esse é o seu conceito de como maximizar este padrão de avaliação. Uma consideração crucial, portanto, seria aquela que muda radicalmente o valor esperado por atingir esta submeta. Logo veremos alguns exemplos disso. Veja, se você parar de limitar sua visão a algum contexto utilitário, talvez queira voltar para essas formulações anteriores mais informais, porque uma das coisas que podem ser questionadas é o próprio utilitarismo. Mas, na maior parte desta palestra, estaremos pensando sobre esse componente.

Existem alguns conceitos relacionados que devemos ter em mente. Então, um componente de uma consideração crucial será um argumento, ideia, ou dado que, embora não represente por si só uma consideração crucial, parece ter uma probabilidade substancial de poder desempenhar um papel central em uma consideração crucial. É o tipo de coisa sobre a qual diríamos: “Parece realmente intrigante, isso pode ser importante. Não tenho muita certeza sobre o que fazer a esse respeito no momento.” Por si só, talvez isso não nos diga nada, mas pode haver outra peça que, ao ser combinada, de alguma forma produza um resultado importante. Assim, tais tipos de componentes de considerações cruciais podem ser úteis para descobrir isso.

E temos ainda o conceito de escada de deliberações, que seria uma sequência de considerações cruciais a respeito da mesma submeta de alto nível, em que as considerações indicam direções opostas. Vejamos alguns exemplos desses tipos de escadas de considerações cruciais que ajudam a ilustrar a situação geral.

Devo votar nas eleições nacionais?

Vamos pegar esta pergunta: “Devo votar nas eleições nacionais?” No tipo de raciocínio “nível um”, você pensa: “Sim, devo votar para eleger um candidato melhor para o cargo”. Isso realmente faz sentido.

Então, você pensa um pouco mais: “Mas, meu voto fará muito pouca diferença. Não devo votar, devo fazer algo melhor com o meu tempo.”

(Esses exemplos servem para ilustrar uma ideia geral. Não é que eu queira um grande debate a respeito desses exemplos específicos. Eles são muito complicados. Mas acho que servem para ilustrar um fenômeno mais geral.)

Então, aqui, passamos de “Sim, devo votar”, fazendo planos para ir até a cabine de votação etc. E depois, com a consideração número dois, mudamos para “Não, não devo votar. Devo fazer algo completamente diferente.”

Então, você pensa, “Bem, embora seja improvável que meu voto faça alguma diferença, as chances são bem grandes: milhões de vidas são afetadas pelo presidente. Então, mesmo se a chance de que meu voto possa decidir algo seja de um em vários milhões, o benefício esperado ainda é grande o suficiente para valer a pena ir até o local de votação.” Eu tinha acabado de ligar a televisão para ver o jogo de futebol, mas agora descobri que preciso ir votar, então temos uma direção inversa.

Então, você continua a pensar, “Bem, se a eleição não estiver tão apertada, meu voto não fará muita diferença. Se a eleição estiver apertada, então aproximadamente metade dos votos será destinada ao candidato errado, o que implica ou que os candidatos têm exatamente ou quase exatamente o mesmo mérito, então na verdade não importa quem ganhe, ou o julgamento comum dos eleitores sobre os méritos dos candidatos é muito duvidoso, e não demonstra quase nenhuma direção, então eu não deveria me preocupar em votar.

Nesse momento, você se acomoda de volta no sofá confortável e pega a pipoca ou o que quer que seja, e pensa: “Bem, é claro que sou um juiz muito melhor dos méritos dos candidatos do que o eleitor comum, então, acho que devo votar. ”

Então você reconsidera: “Bem, mas estudos psicológicos mostram que as pessoas que tendem a ser excessivamente confiantes, acreditam estarem acima da média, mas elas podem estar tanto erradas quanto certas sobre isso. Se eu tiver a mesma probabilidade de votar no candidato errado quanto o eleitor comum, então meu voto teria um peso insignificante para o processo de seleção e eu não deveria votar”.

Então, prosseguimos…

“OK, passei por todo esse raciocínio que realmente significa que sou especial, então, acho que devo votar.”

Mas então, “Bem, se sou tão especial assim, o custo de oportunidade…” [risos na platéia]

(É por isso que eu avisei a vocês para não serem filósofos.) [risos na platéia]

Então, devo fazer algo mais importante. Mas se eu não votar, meus conhecidos verão que não apoiei os candidatos que achamos que são os melhores, eles me achariam esquisito e estranho e desleal. Então, isso talvez diminuísse minha influência sobre eles, que eu poderia usar para uma boa finalidade, dessa forma… devo votar.

Mas é importante defender suas convicções, para estimular discussões frutíferas. Eles podem pensar que eu sou bastante inteligente se eu explicar todo esse complicado raciocínio sobre votar, e isso pode aumentar minha influência, que eu posso, então, investir em alguma boa causa. Etc. etc.

Não há motivo algum para pensar que a escada pararia por aqui. Simplesmente perdemos o fôlego neste momento. Se você parar em algum ponto, poderá então se perguntar que talvez existam outros degraus na escada. E quão certo você está dos raciocínios que o levaram a conclusão em que temporariamente você está, nesse estágio?

Devemos favorecer mais financiamento para pesquisas de tecnologia de risco x?

Quero mostrar um outro exemplo de escada de deliberações mais no contexto da política de tecnologia e risco x. Este é um tipo de argumento que pode ocorrer com relação a certos tipos de tecnologias, se devemos tentar promovê-las, quanto financiamento devemos buscar.

A tecnologia aqui é a nanotecnologia. Na verdade, esse é o exemplo que deu origem a essa linha de raciocínio. Algumas partes remontam ao livro de Eric Drexler Engines of Creation, no qual ele defendeu muito bem essa linha de pensamento (cap. 12). Portanto, devemos financiar a nanotecnologia — este é o raciocínio de “nível um” — porque existem muitas possíveis aplicações futuras para ela: medicina, manufatura, energia limpa etc. Seria realmente muito bom se tivéssemos todos esses benefícios.

Mas também parece que a nanotecnologia pode ter importantes aplicações militares, e poderia ser usada por terroristas etc., para criar novas armas de destruição em massa que poderiam representar uma grande ameaça para a nossa existência. Se ela é tão perigosa, talvez não devêssemos financiá-la.

Mas se esse tipo de tecnologia é possível, é bastante provável que seja desenvolvida cedo ou tarde, quer decidamos pesquisá-la quer não. (‘Nós’ talvez sejamos as pessoas neste auditório ou as pessoas na Grã-Bretanha ou em democracias no Ocidente.) Se pessoas responsáveis se abstiverem de desenvolvê-la, ela será desenvolvida por pessoas irresponsáveis, o que pode aumentar ainda mais seus riscos, por isso devemos financiá-la.

(Você pode ver que o mesmo modelo pode ser relevante para avaliar outras tecnologias, além da nanotecnologia, com vantagens e desvantagens.)

Mas já estamos adiantados nesta evolução, então um financiamento extra apenas nos faria chegar lá mais cedo, nos dando menos tempo para nos preparar para os perigos. Assim, não devemos fazer esse financiamento: as pessoas responsáveis podem chegar lá primeiro mesmo sem adicionar financiamento a esse empreendimento.

Mas então você olha ao seu redor e não vê praticamente nenhum esforço sério sendo feito para se preparar para os perigos da nanotecnologia — e este é basicamente o argumento de Drexler em Engines — porque uma preparação séria começa apenas depois que um projeto grande já está em andamento para desenvolver a nanotecnologia. Apenas após isso é que as pessoas passam a levar essa perspectiva a sério.

Quanto antes um projeto sério do tipo Manhattan para desenvolver nanotecnologia for iniciado, mais tempo levará para ser concluído, porque quanto mais cedo você começa, mais baixa é a base sob a qual se apoia para começar. Um projeto real será executado por mais tempo, o que significará mais tempo para a preparação: uma preparação séria só começa quando o projeto se inicia, e quanto mais cedo o projeto começar, mais tempo levará, portanto, mais longo será o tempo de preparação. E isso sugere que devemos nos empenhar ao máximo para lançar esse produto imediatamente, e assim maximizar o tempo de preparação.

Mas existem outras considerações que devemos fazer. O nível de risco será afetado por fatores diferentes da quantidade de preparação séria que tem sido feita, principalmente para combater a ameaça da nanotecnologia. Por exemplo, inteligência de máquina ou uma vigilância onipresente podem ser desenvolvidas antes da nanotecnologia, eliminando ou mitigando os riscos dessa última. Embora essas outras tecnologias possam representar grandes riscos por si sós, de qualquer forma esses riscos terão que ser enfrentados. E temos muitas outras coisas para dizer a esse respeito.

A nanotecnologia não reduziria de fato esses outros riscos, como os riscos de IA, por exemplo. A sequência preferida é que obtenhamos superinteligência ou vigilância onipresentes antes da nanotecnologia e, portanto, devemos nos opor a um financiamento extra para a nanotecnologia, embora a superinteligência e a vigilância onipresentes possam ser muito perigosas por si sós. Podem inclusive representar risco existencial, dadas certas suposições básicas sobre a suposição de conclusão tecnológica — que na plenitude do tempo, a menos que a civilização entre em colapso, todas as tecnologias gerais úteis possíveis serão desenvolvidas — de que esses perigos terão de ser confrontados, e tudo que nossas escolhas poderão influenciar nisso é a sequência em que os enfrentaremos. E é melhor confrontar a superinteligência antes da nanotecnologia porque a superinteligência pode evitar o risco da nanotecnologia, mas o contrário não é verdadeiro.

Entretanto, se as pessoas se opuserem ao financiamento extra para a nanotecnologia, então as que trabalham com nanotecnologia não gostarão das pessoas contrárias a elas. (Isso também é um assunto do livro de Drexler.) Mas outros cientistas podem entender que essas pessoas se opõem ao financiamento da nanotecnologia por serem contrárias à ciência como um todo e isso reduzirá nossa capacidade de trabalhar com esses cientistas e dificultará nossos esforços em assuntos mais específicos — esforços que têm mais chance de fazer uma diferença real em qualquer tentativa nossa de influenciar o nível de financiamento nacional para a nanotecnologia. Assim, não devemos nos opor à nanotecnologia. Ou seja, em vez de nos opormos à nanotecnologia, podemos tentar desacelerá-la um pouco. Entretanto, somos um grupo pequeno e não podemos fazer uma grande diferença. Precisamos então trabalhar com os cientistas da nanotecnologia, ser seus amigos, e então talvez tentar influenciar a questão marginalmente, para que desenvolvam a nanotecnologia de uma forma levemente diferente ou acrescentem algumas proteções e coisas assim.

N.R.: esse outro artigo que traduzimos, publicado no Astral Codex Ten, desenvolve bem esse argumento, aplicando-o a IA.

Novamente, não existe um motivo claro para pensar que alcançamos o limite do nível de deliberação que poderíamos aplicar a essa questão. É desconcertante porque parece que o resultado prático continua mudando à medida que verificamos com mais profundidade a árvore de busca, e podemos nos perguntar por que isso acontece. Acho que essas escadas de deliberação são bastante prováveis de aparecer quando alguém está tentando ser um utilitarista completo e leva realmente a sério a questão do panorama geral.

Considerações cruciais e utilitarismo

Vamos pensar em alguns motivos possíveis para saber porque isso pode ocorrer. Se compararmos, por exemplo, o domínio da aplicação do utilitarismo a outro domínio de aplicação, digamos, se houver uma função humana preferencial comum — você deseja uma vida próspera, tal como uma família saudável, uma carreira de sucesso e um pouco de lazer, coisas que um humano típico valoriza — se você estiver tentando satisfazer essas coisas, pode ser menos provável que você encontre um grande número de considerações cruciais. Por que isso ocorre?

Uma explicação possível é que temos mais conhecimento e experiência de vida humana no nível pessoal. Bilhões de pessoas têm tentado maximizar uma função de utilidade humana comum, têm recebido muito feedback e muitas coisas têm sido tentadas. Portanto, já sabemos algumas coisas básicas tal como, se você quer viver muitas décadas, é uma boa ideia se alimentar, coisas desse tipo. [risos na platéia]

Essas não são coisas que precisamos descobrir. E talvez nossas preferências em primeiro lugar tenham sido formuladas para se adequar mais ou menos ao tipo de oportunidade que podemos explorar cognitivamente no meio ambiente por meio da evolução. Portanto, podemos não ter nenhuma preferência estranha que não possamos satisfazer sistematicamente. Considerando o utilitarismo, a preferência utilitarista se estende muito além de nosso ambiente familiar, e inclui os bens comuns cósmicos, bilhões de anos no futuro e civilizações super avançadas: o que eles fazem é importante a partir da perspectiva utilitária, é muito importante. A maior parte do que interessa à preferência utilitária são coisas com as quais não temos familiaridade.

Outra possível fonte de considerações cruciais em relação ao utilitarismo são as dificuldades em entender o objetivo em si. Se alguém tentar, por exemplo, pensar em como aplicar o utilitarismo a um mundo que tem uma probabilidade finita de ser infinito, encontrará dificuldades em termos de como medir diferentes magnitudes infinitas e de ainda ver como que poderíamos fazer alguma diferença no mundo. Escrevi um artigo grande sobre isso, então não precisamos entrar nesse assunto. Existem algumas outras questões que consistem em tentar verdadeiramente articular o utilitarismo para lidar com todos esses casos possíveis.

O terceiro motivo possível aqui é que se pode pensar que estamos até perto, não muito perto, mas perto de algum ponto central na história. Isso significa que podemos ter oportunidades especiais de influenciar o futuro de longo prazo agora. E ainda estamos bem longe disso: não é óbvio o que devemos fazer para ter um impacto maximamente benéfico no futuro. Mas ainda estamos perto o suficiente para talvez começar a perceber alguns contornos do aparato que moldará o futuro. Por exemplo, você pode pensar que a superinteligência pode ser esse ponto central, ou um deles (pode haver pontos centrais de risco x também) que enfrentaremos neste século. Nesse caso, pode ser que mal estejamos começando a adquirir a capacidade de pensar sobre tais coisas, o que introduz todo um conjunto de novas considerações que podem ser muito importantes.

Isso também pode afetar o domínio pessoal. É exatamente como a função de utilidade típica de uma pessoa comum: ela provavelmente não valoriza um milhão de vezes mais a possibilidade de viver um bilhão de anos do que a de viver cem anos, ou valoriza mil vezes mais criar mil filhos do que criar uma criança. Portanto, embora o futuro ainda exista, ele simplesmente não tem um peso tão grande em uma função de utilidade humana normal como tem para os utilitaristas.

Em quarto lugar, também se pode argumentar que descobrimos recentemente algumas ferramentas-chave de exploração que nos permitem fazer descobertas muito importantes sobre como ser um bom utilitarista. E ainda não percorremos o percurso com essas ferramentas, então continuamos surgindo como novas descobertas importantes e fundamentais usando essas ferramentas de exploração. Por isso parece que tantas considerações cruciais estão sendo feitas. Podemos falar um pouco sobre elas mais para o final desta apresentação.

Funções de avaliação

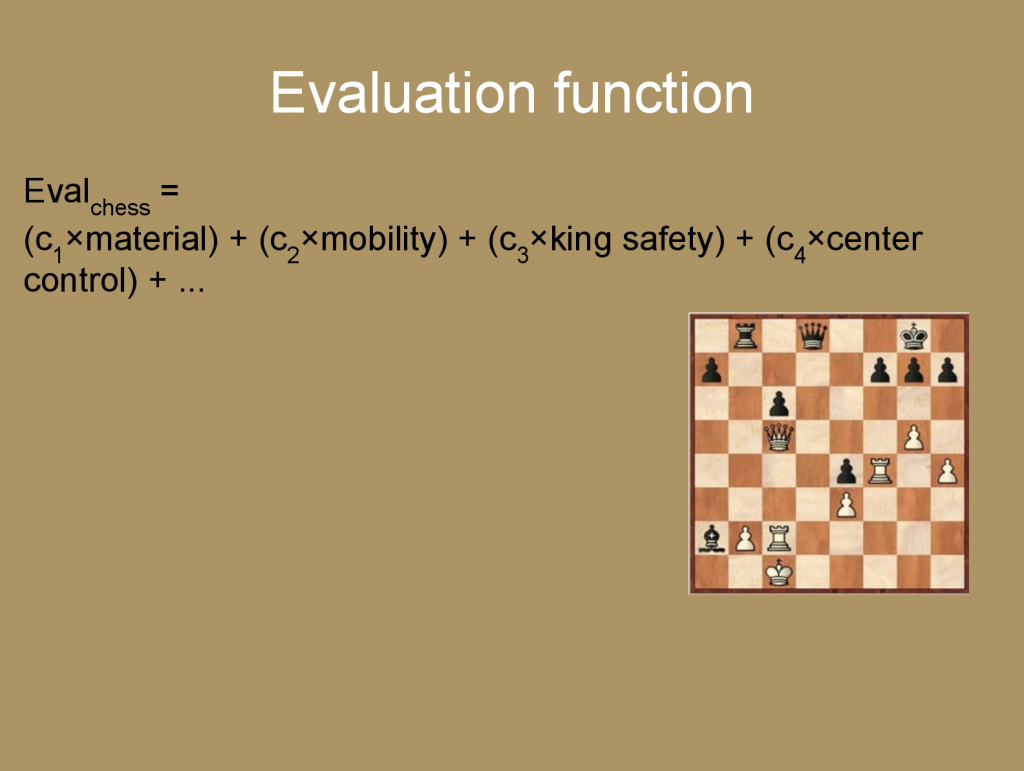

Agora, deixe-me abordar isso sob um ângulo um pouquinho diferente. No xadrez, a maneira ideal de jogar é começar pensando nos possíveis movimentos que se pode fazer, depois nas possíveis respostas que o oponente pode dar e nas suas respostas às respostas dele. Idealmente, se pensaria nisso até a situação final e, em seguida, apenas se tentaria selecionar um primeiro movimento que seria melhor do ponto de vista da vitória quando fosse possível calcular toda a árvore do jogo. Mas, computacionalmente, isso é inviável porque a árvore se ramifica demais: tem-se um número exponencial de movimentos a considerar.

Então, o que se deve fazer é calcular explicitamente algumas jogadas à frente. Talvez umas doze jogadas à frente ou algo assim. Nesse ponto, sua análise para, e você tem alguma função de avaliação relativamente simples para calcular, que tenta olhar para a situação do tabuleiro que poderia resultar dessa sequência de seis movimentos e contramovimentos e, de alguma forma aproximada e pronta, deve tentar estimar o quão boa é a situação. Uma função comum de avaliação de xadrez pode ser algo assim.

Você tem uma análise que avalia quanto material nós temos, por exemplo, ter a rainha e muitas peças é algo bom. O oponente ter menos desses itens também é algo bom. Temos uma métrica de que um peão vale um e a rainha vale, sei lá, 11 ou algo assim.

Então, você pesa tudo isso — esse é um componente na função de avaliação. Então, talvez você pense na mobilidade de suas peças. Se elas estão todas amontoadas em um canto, em geral, essa é uma situação pouco promissora, então você faz uma análise sobre isso. Segurança do rei – o controle central agrega um pouco de valor: se você controla o meio do tabuleiro, sabemos por experiência que tende a ter uma boa posição.

Então, você calcula explicitamente alguns passos à frente e tem essa função de avaliação relativamente imutável que é usada para descobrir qual desses jogos iniciais que você poderia escolher resultaria na situação mais benéfica para você. Essas funções de avaliação vieram principalmente de alguns mestres de xadrez humanos que têm muita experiência nesse jogo. Os parâmetros, tais como o peso atribuído a esses diferentes recursos, também podem ser aprendidos pela inteligência da máquina.

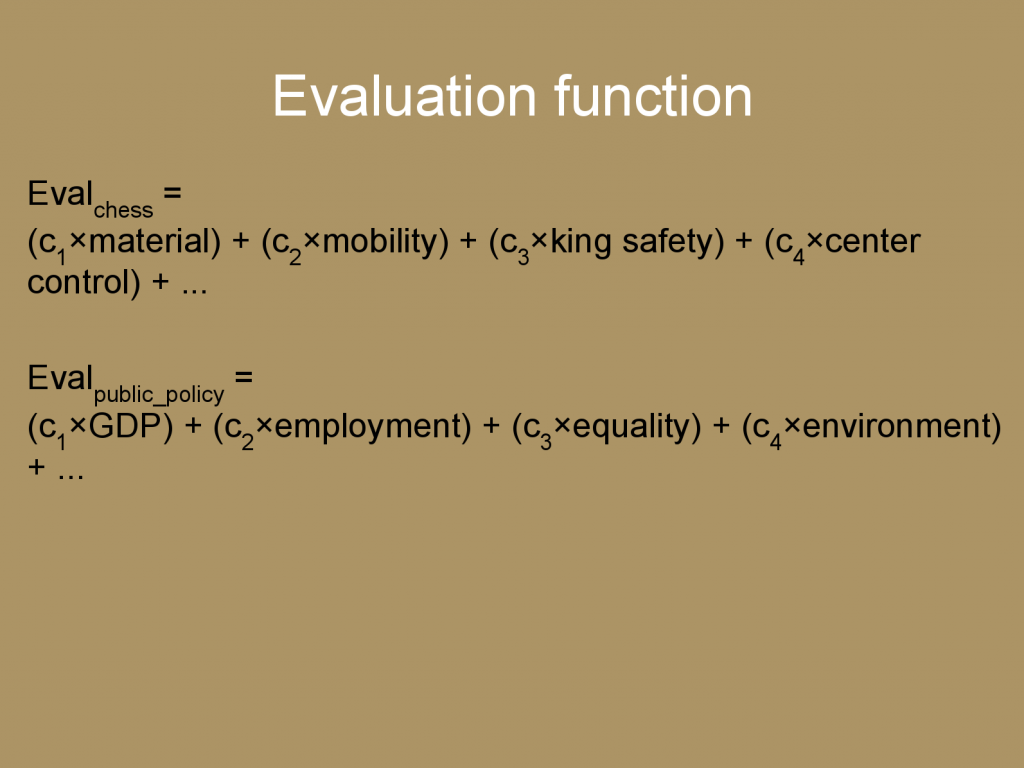

Fazemos algo parecido com isso em outras áreas. Como uma política pública tradicional típica, os economistas do bem-estar social podem pensar que você precisa maximizar alguma função de bem-estar social que pode assumir uma forma como esta.

PIB? Sim, queremos mais PIB, mas também precisamos levar em consideração o volume de desemprego, talvez a quantidade de equidade ou desigualdade, alguns fatores para a saúde do meio ambiente. Talvez o que escrevemos ali não seja exatamente o equivalente à bondade moral, fundamentalmente considerada. Mas sabemos que essas coisas tendem para o bem, ou assim pensamos.

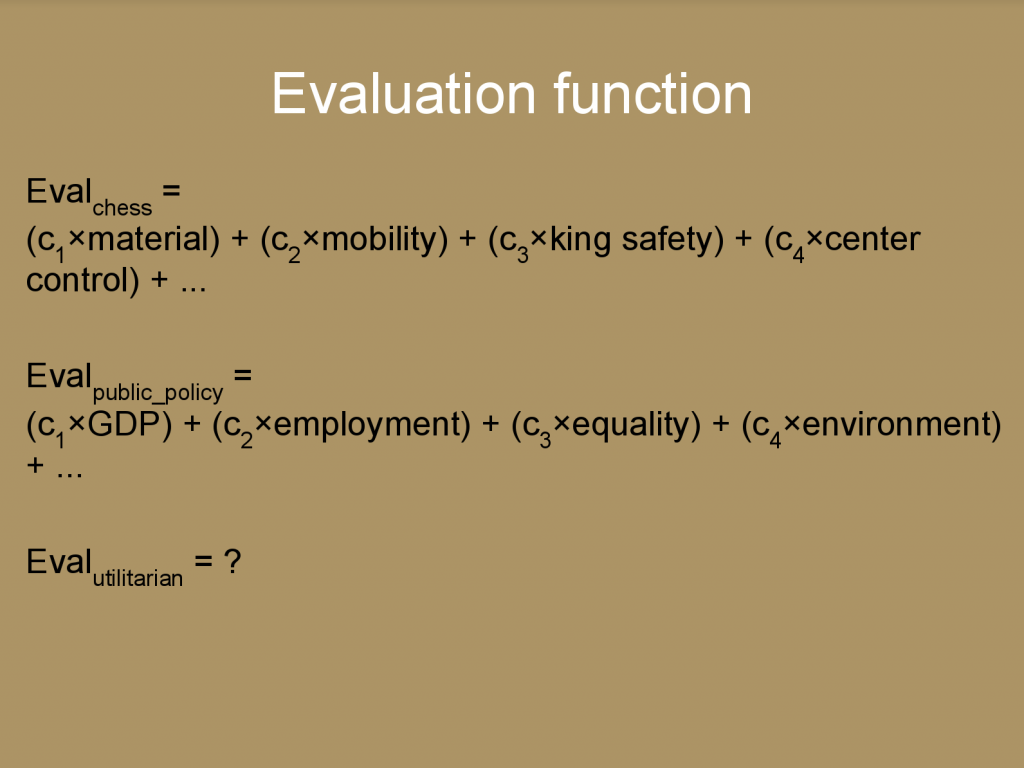

Essa é uma aproximação útil do valor verdadeiro que pode ser mais fácil em um contexto prático de tomada de decisão. Uma coisa que posso perguntar é se existe algo similar a isso para a bondade moral. Você quer fazer a melhor coisa moralmente possível, mas calcular tudo isso do zero pode ser difícil ou impossível em qualquer situação. Você precisa de princípios mais estáveis que possa usar para avaliar coisas diferentes que poderia fazer. Aqui podemos ver a versão mais limitada do utilitarismo. Podemos imaginar o que podemos colocar aí.

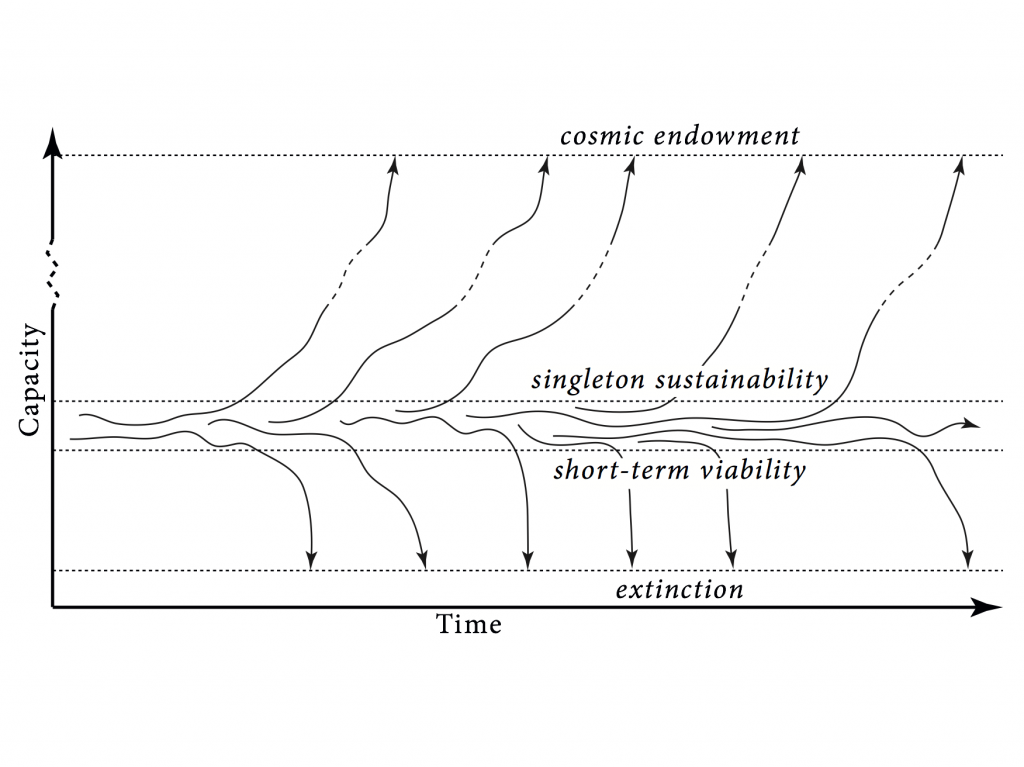

Aqui podemos voltar a algumas das coisas sobre as quais Beckstead falou. Se traçarmos em um gráfico a capacidade, que pode ser o nível de desenvolvimento econômico e de sofisticação tecnológica, coisas assim, em um eixo, e o tempo no outro, entendo que a condição humana seja uma espécie de região metaestável nesse eixo de capacidade.

É possível flutuar por um tempo, mas quanto maior a escala de tempo que se está considerando, maior a chance de se sair dessa região na direção descendente e se extinguir — se você tiver poucos recursos abaixo do tamanho mínimo viável da população, você se extingue (esse é um estado atrator: uma vez extinto, tende-se a permanecer extinto) — ou na direção ascendente: chegamos à maturidade tecnológica, iniciamos o processo de colonização e o futuro da vida inteligente originária da Terra pode apenas ser essa bolha que se expande em uma fração significativa da velocidade da luz e eventualmente acessa todos os recursos cosmológicos que são, a princípio, acessíveis a partir de nosso ponto de partida. Essa é uma quantidade finita por causa da constante cosmológica positiva: parece que só podemos acessar uma quantidade finita de coisas. Mas se você começou isso, e é um império intergaláctico, parece que poderia continuar com alta probabilidade em direção a essa visão natural.

Podemos definir o conceito de risco existencial como aquele que falha em realizar o potencial de valor que se poderia ganhar acessando os bens comuns cosmológicos, seja extinguindo-se, seja talvez acessando todos os bens comuns cosmológicos, mas depois deixando de usar para fins benéficos ou algo assim.

Isso sugere esse princípio Maxipol que Beckstead também mencionou: Maximize a probabilidade de um resultado OK. Claramente, na melhor das hipóteses, isso é uma regra prática: não pretende ser um princípio moral válido que seja verdadeiro em todas as situações possíveis. Não é isso. Na verdade, se você quiser ir do princípio original com o qual começou para algo praticamente tratável, deve torná-lo dependente de várias suposições empíricas. Essa é a compensação: você quer fazer suposições o mais fracas possível e ainda movê-las o mais longe possível para ser o mais tratável possível.

Acho que isso é algo no que se pode fazer um compromisso razoável. Em outras palavras, tome uma atitude que minimize a integralidade do risco existencial que a humanidade enfrentará. Nem sempre isso dará a resposta certa para você, mas já é um começo. Algumas coisas são diferentes das que Beckstead mencionou. Poderia haver outros cenários em que isso daria a resposta errada: se você pensou que havia um grande risco de catástrofe hiperexistencial, como algum cenário infernal, então pode querer aumentar o nível de riscos existenciais um pouco para diminuir o risco de que não houvesse apenas uma catástrofe existencial, mas uma catástrofe hiperexistencial. Outras coisas que podem entrar nisso são mudanças de trajetória menos drásticas e que mudam apenas ligeiramente.

Para os nossos fins, poderíamos considerar a sugestão de usar a regra Maxipok como uma tentativa de definir a função de valor para agentes utilitários. Então a pergunta é: o que devo fazer para minimizar o risco existencial? Esse ainda é um objetivo de alto nível. Ainda precisamos fazer outros trabalhos para dividir isso em componentes mais tangíveis.

Não estou muito certo sobre como isso se adequa ao restante da apresentação. [risos da platéia]

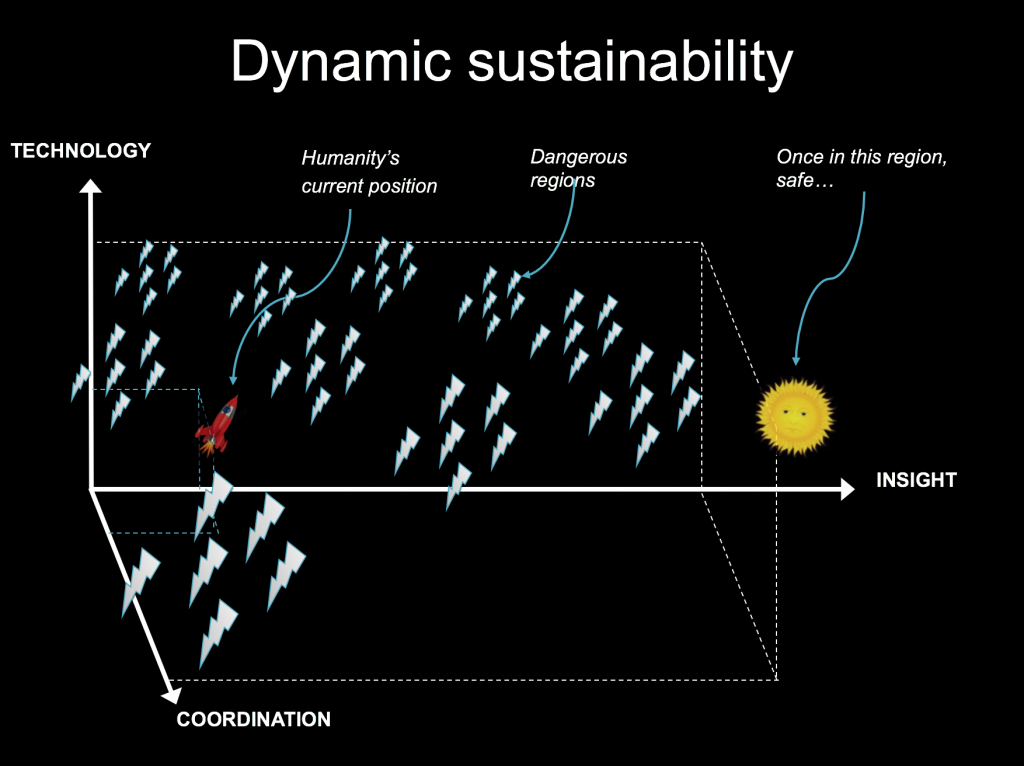

Tenho ainda este belo slide de uma outra apresentação. Essa é uma forma diferente de falar um pouco o que acabei de dizer: em vez de pensar na sustentabilidade como ela é comumente conhecida: esse conceito estático que tem um estado estável do qual devemos tentar nos aproximar, no qual não gastaríamos mais recursos do que os regenerados pelo ambiente natural. Precisamos, assim entendo, pensar a sustentabilidade em termos dinâmicos, no qual, em vez de chegarmos a um estado, tentamos entrar e permanecer numa trajetória que é indefinidamente sustentável no sentido de podermos contê-la para viajar nessa trajetória indefinidamente e que isso leve em uma boa direção.

Uma analogia aqui seria se você tivesse um foguete. Um estado estável para um foguete é na base de lançamento: ele pode ficar em pé lá por muito tempo. Outro estado estável é se ele está no espaço, ele pode continuar a viagem por um tempo ainda maior, talvez, se não enferrujar ou coisa assim. Mas no ar, existe este sistema instável. Acho que é onde a humanidade está agora: estamos no ar. O conceito de sustentabilidade estática sugere que deveríamos reduzir nosso consumo de combustível para um mínimo que permita apenas que flutuemos lá. Assim, talvez prolongássemos a duração na qual poderíamos ficar em nossa situação atual, mas o que talvez devêssemos fazer é maximizar o consumo de combustível para ter empuxo suficiente para atingir a velocidade de fuga. (E isso não é um argumento literal para queimar tanto combustível fóssil quanto possível. É apenas uma metáfora.)

A questão aqui é: para termos a melhor condição possível, precisamos de uma tecnologia superavançada para poder acessar os bens comuns cósmicos, poder curar todas as doenças que nos afligem etc. Acho que, para ter o melhor mundo possível, também são necessárias muita percepção e sabedoria, e muita coordenação para evitar o uso de alta tecnologia para lutar uns contra os outros, e assim por diante. Em última análise, desejaríamos um estado em que tivéssemos grandes quantidades de cada uma dessas três variáveis, mas isso deixa em aberto a questão daquilo que, em nossas considerações, queremos mais. Pode ser, por exemplo, que desejemos mais coordenação e percepção antes de termos mais tecnologia de certo tipo. Portanto, antes de termos várias tecnologias poderosas, primeiro queremos ter certeza de ter paz e compreensão suficientes para não usá-las para a guerra, e de ter percepção e sabedoria suficientes para não nos explodirmos acidentalmente com elas.

Claramente, uma superinteligência parece ser algo que você deseja utopicamente — é um nível muito alto de tecnologia — mas podemos querer uma certa percepção antes de desenvolver a superinteligência, para que possamos desenvolvê-la da maneira correta.

Pode-se começar a pensar, numa analogia com a situação de teste de computador, se existem diferentes características que se poderia pensar como componentes desta função de avaliação para o utilitário, o Maxipok.

Este princípio de desenvolvimento tecnológico diferencial sugere que devemos retardar o desenvolvimento de tecnologias perigosas e nocivas — aquelas que aumentam o risco existencial — e acelerar o de tecnologias que reduzem o risco existencial.

Este é o nosso primeiro esboço, não uma resposta definitiva, mas pode-se pensar que queremos muita sabedoria, muita paz e cooperação internacional e, no que diz respeito às tecnologias, fica um pouco mais complicado: queremos um progresso mais rápido em certas áreas de tecnologia e, talvez, mais lento em outras. Acho que esses são três tipos amplos de coisas que alguém pode querer colocar na função de avaliação.

Isso sugere que uma coisa a se pensar, além de intervenções ou causas, é a assinatura de diferentes tipos de coisas. Uma intervenção deve ser um tipo de alta alavancagem, e uma causa deve prometer intervenções de alta alavancagem. Não é suficiente que algo que você possa fazer seja bom, também se deve pensar muito sobre o quanto isso pode ser bom em relação a outras coisas que se poderia fazer. Não adianta pensar nas causas sem pensar em como se vê todos os frutos mais acessíveis que se pode pegar. Assim, muitos de nossos raciocínios se referem a isso.

Mas quando nos movemos nesse plano mais elevado, esta grande altitude onde estão as considerações cruciais, também parece importante pensar em determinar o sinal de diferentes parâmetros básicos, talvez até mesmo quando não temos certeza de como poderíamos afetá-los. (A pergunta seria, basicamente: Queremos mais ou menos disso?) Para começar, podemos colocar questões de alavancagem aqui, porque para nos orientarmos primeiro na paisagem, podemos querer adiar um pouco essa questão nesse contexto. Mas uma boa placa de sinalização — um bom parâmetro do qual gostaríamos de determinar a assinatura — deveria ser visível de longe.

Ou seja, se definirmos alguma quantidade em termos que ainda seja muito difícil de se dizer, para qualquer intervenção específica, se ela contribui positiva ou negativamente para essa quantidade que acabamos de definir, então ela não é tão útil quanto uma placa de sinalização. Digamos que “maximizar o valor esperado” é a quantidade que elas poderiam definir.

Isso simplesmente não nos ajuda muito porque, sempre que você tenta fazer algo específico, ainda está virtualmente tão distante quanto antes. Por outro lado, se você definir algum objetivo mais concreto, como maximizar o número de pessoas nesta sala, ou algo assim, poderá facilmente dizer quantas pessoas existem e teremos ideias sobre como maximizar isso. Então, qualquer ação específica em que pensamos, podemos ver facilmente como ela resulta nesse objetivo de maximizar as pessoas nesta sala. No entanto, podemos entender que é muito difícil ter razões fortes para saber se seria melhor ter mais pessoas nesta sala ou se há alguma relação inversa. Uma boa placa de sinalização chegaria a um meio-termo razoável entre ser visível de longe e também ser de tal forma que possamos ter fortes razões para estar certos da sua orientação.

Algumas placas de sinalização provisórias

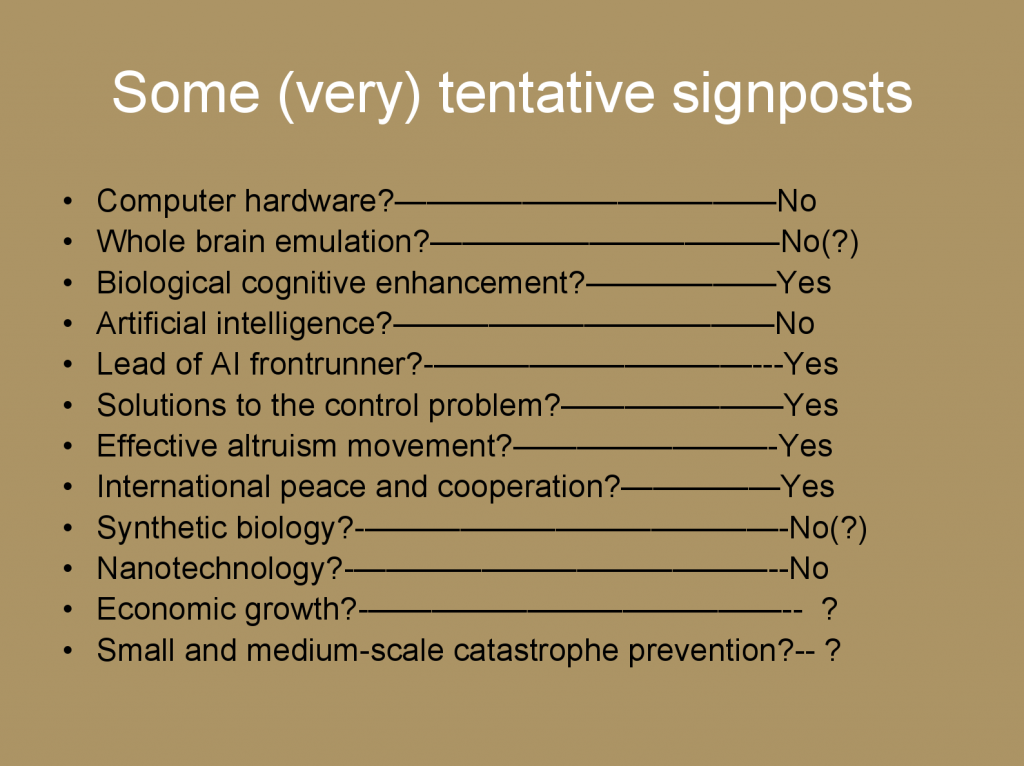

Aqui apresento algumas placas de sinalização muito provisórias: elas são provisórias na minha opinião e acho que também pode haver muita discordância entre pessoas diferentes. Portanto, essas são outras áreas de investigação. Mas isso pode ser útil apenas para mostrar como alguém pode começar a pensar sobre isso.

Queremos um progresso mais rápido ou mais lento no hardware de computadores? Meu melhor palpite é que queremos um progresso mais lento. E isso está relacionado com os riscos da transição da inteligência de máquina. Computadores mais rápidos facilitariam a criação de IA, o que (a) provavelmente faria com que ela acontecesse mais cedo, o que parece que por si só deixa menos tempo para o tipo relevante de preparação, da qual temos uma grande necessidade; e (b) pode reduzir o nível de habilidade que seria necessário para produzir IA: com uma quantidade ridiculamente grande de poder de computação, é possível produzir IA sem realmente saber muito sobre o que está sendo feito. Quando se tem restrições de hardware, podem ser necessárias mais percepção e compreensão, e é melhor que a IA seja criada por pessoas com mais percepção e compreensão.

Isso não é de forma alguma um argumento decisivo, porque existem outros riscos existenciais. Se você pensou que estamos prestes a ser extintos porque alguém vai desenvolver uma nanotecnologia, então pode-se querer tentar o curinga da IA o mais rápido possível. Mas, considerando tudo isso, este é o meu melhor palpite atual. Esses são os tipos de raciocínio nos quais é possível se engajar.

Emulação de todo o cérebro? Fizemos uma longa e enorme análise disso. Mais especificamente, não se queremos ter emulação de todo o cérebro, mas se queremos ter mais ou menos financiamento para emulação de todo o cérebro, mais ou menos recursos para desenvolver isso. Esse é um caminho possível para a superinteligência da máquina e, por razões complicadas, meu palpite é “Não”, mas isso é ainda mais incerto, e temos muitos pontos de vista diferentes em nosso grupo de pesquisa a esse respeito. (Durante a discussão, se alguém estiver interessado em um ponto de vista específico, podemos ampliá-lo.)

Aprimoramento cognitivo biológico dos humanos? Meu palpite é que queremos um progresso mais rápido nesta área.

Falo mais sobre esses três pontos no meu livro.

Quanto à IA, acho que provavelmente queremos que a IA aconteça um pouco mais devagar do que é provável que venha a ocorrer por padrão.

Outra pergunta é:

Se houver uma empresa, projeto ou equipe que desenvolverá a primeira IA bem-sucedida, quão adiantada desejamos que essa equipe esteja em relação à segunda equipe que está tentando fazer isso? Meu palpite é que queremos que ela tenha muita vantagem, muitos anos de preferência, para permitir que desacelere no final para implementar mais medidas de segurança, em vez de estar numa corrida tecnológica acirrada.

Soluções para o problema de controle para IA? Acho que queremos um progresso mais rápido nisso, e essa é uma das nossas áreas de foco. Alguns de nossos amigos do Machine Intelligence Research Institute estão aqui, também trabalhando duro nisso.

O movimento do altruísmo eficaz? Acho que isso parece muito bom em muitos aspectos, seria bastante bom mesmo ter um crescimento mais rápido e melhor nisso.

Paz e cooperação internacional? Parece bom. [risos na platéia]

Biologia sintética? Parece ruim. Não pensamos muito sobre isso, de forma a poder mudá-la, mas parece que pode haver riscos x, embora também possa ser benéfico. Na medida em que pode permitir melhorias no aprimoramento cognitivo, haverá uma espécie de difícil compensação.

Nanotecnologia? Parece ruim: queremos um progresso mais lento nessa direção.

Crescimento econômico? Muito difícil dizer a direção dele, no meu ponto de vista. E dentro de uma comunidade de pessoas que pensaram muito sobre isso, novamente, tenho diferentes suposições quanto à sua direção.

Prevenção de catástrofes de pequena e média escala? Também parece bom. Portanto, os riscos catastróficos globais ficam aquém do risco existencial. Novamente, muito difícil dizer a direção dela. Aqui estamos alavancando tudo, mesmo sabendo apenas se queremos mais ou menos, se pudéssemos obtê-lo de graça, não é muito óbvio. Por um lado, catástrofes pequenas podem criar uma resposta imunológica que nos torna melhores, coloca em prática melhores proteções e coisas assim, que podem nos proteger das grandes coisas. Se estamos pensando em catástrofes de média escala que podem provocar um colapso civilizacional, grande para os padrões comuns, mas apenas de média escala em comparação com as catástrofes existenciais, que são grandes nesse contexto, então, novamente, não fica totalmente óbvio qual é a direção disso: há muito mais trabalho a ser feito para tentar descobrir isso. Se a recuperação parece ser muito provável, pode-se então adivinhar se a civilização recuperada teria mais chances de evitar uma catástrofe existencial ao passar por essa experiência ou não.

Portanto, esses são os parâmetros a respeito dos quais podemos começar a pensar. Não se percebe o quão difícil isso é. Mesmo alguns parâmetros que do ponto de vista do senso comum parecem meio óbvios, na verdade se tornam bem pouco óbvios quando você começa a pensar na maneira como todos eles deveriam se encaixar.

Suponha que você seja um administrador aqui em Oxford, trabalhe como secretário do departamento de Ciência da Computação. Suponha que você encontre uma forma de tornar o departamento um pouco mais eficiente: você cria essa lista de mala direta para que, quando alguém tiver um anúncio a fazer, possa apenas enviá-la por e-mail para a lista de mala direta, em vez de ter que colocar o nome de cada pessoa individualmente no campo de endereço. Isso é uma coisa útil, é ótima: não custou nada, teve apenas um custo único, e agora todos podem cuidar de seus assuntos com mais facilidade. A partir dessa perspectiva, não é muito óbvio se isso é, de fato, uma coisa boa. Pode estar contribuindo para a IA — esse pode ser o principal efeito disso, além de provocar um efeito geral muito pequeno no crescimento econômico. E pode ser que você tenha piorado a expectativa do mundo ao fazer essa pequena melhoria de eficiência. Assim, esse projeto de tentar pensar sobre isso é, de certa forma, um pouco como o Umwertung aller Werte nietzscheriano — a reavaliação de todos os valores — um projeto que ele nunca pode concluir, porque enlouqueceu antes.

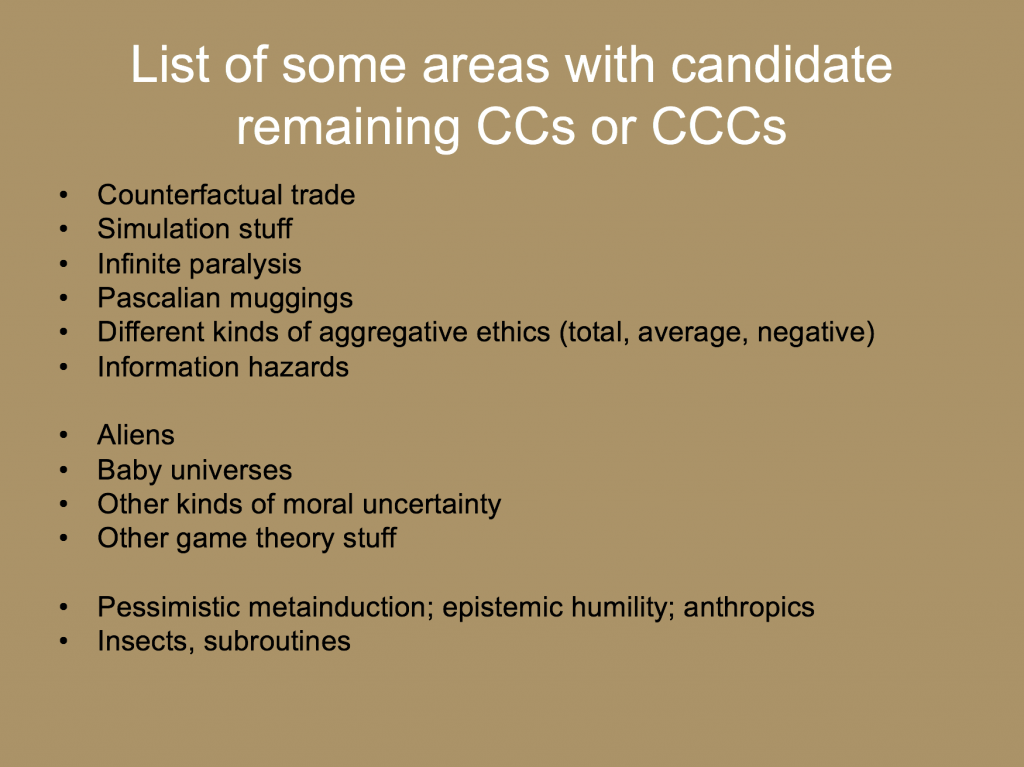

Possíveis áreas com considerações cruciais adicionais

Então, esses são alguns tipos de áreas — não vou entrar em todas elas, estou apenas dando exemplos dos tipos de áreas onde parece que pode haver considerações cruciais ainda hoje. Esta não é, de forma alguma, uma lista exaustiva, e podemos falar mais sobre alguns desses pontos. Eles vão dos mais gerais, abstratos e poderosos aos mais específicos e compreensíveis para o raciocínio comum.

Para ver apenas um exemplo: insetos. Se você é um utilitarista clássico, essa consideração surge dentro do que é mais mundano — estamos deixando de lado os comuns cosmológicos e pensando apenas aqui na Terra. Se os insetos são sencientes, então talvez a quantidade de senciência nos insetos seja muito grande porque existem muitos, muitos deles. Então, talvez o efeito de nossas políticas sobre o bem-estar dos insetos possa superar o efeito das políticas sobre o bem-estar humano ou de animais em pecuária industrial e coisas assim. Não estou dizendo que seja assim, mas é uma pergunta nada óbvia e que poderia gerar um grande impacto.

Ou, vejamos outro exemplo:

Sub-rotinas. Com certos tipos de inteligência de máquina, existem processos, como algoritmos de aprendizado por reforço e outros subprocessos dentro da IA que, de alguma forma, podem vir a ter status moral. Talvez haja um número enorme de formas de executar esses subprocessos, de modo que, se alguns desses tipos de coisas servirem para algo, talvez os números voltem a dominar.

Alguns remédios parciais

Cada um desses itens é um workshop completo por si só, então não é algo que podemos aprofundar aqui. Mas o que se pode fazer ao suspeitar que pode haver essas considerações cruciais, algumas delas ainda não descobertas? Não tenho uma resposta certa para isso. Aqui estão algumas coisas plausíveis à primeira vista que alguém pode tentar fazer um pouco:

- Não agir precipitadamente, especialmente de formas irrevogáveis.

- Investir em mais análises para localizar e reunir considerações cruciais que estão faltando. É por isso que faço o tipo de trabalho que faço, e o resto de nós também está envolvido nesse empreendimento.

- Leve em consideração que, provavelmente, as mudanças nos valores esperados são menores do que parecem. Se você é um utilitarista, digamos que pense nesse novo argumento que tem essa implicação radical para o que deveria estar fazendo. Seu primeiro instinto pode ser mudar radicalmente a utilidade esperada de diferentes políticas práticas à luz desse novo insight. Mas talvez, quando você refletir sobre o fato de que novas considerações cruciais estão sendo descobertas de tempos em tempos, talvez você deva mudar seu valor esperado ― mas não tanto quanto parecia que você deveria mudar, na primeira vez. Você deveria refletir sobre isso no nível meta.

- Leve em conta a incerteza moral fundamental. Se ampliarmos nosso alcance para não apenas considerar o utilitarismo, como considerar as coisas por uma perspectiva normativa irrestrita mais geral, então, algo como o Modelo Parlamentar para considerar a incerteza normativa parece ser bastante robusto. Essa é a ideia de que, se você não tem certeza de qual teoria moral é verdadeira, deve atribuir probabilidades a diferentes teorias morais e imaginar que haveria um congresso para onde cada teoria moral enviava delegados na proporção de sua probabilidade. Então, nesse congresso imaginário, delegados de diferentes teorias morais discutem, se comprometem e decidem o que fazer. E então você deveria fazer o que o seu congresso moral teria decidido, como uma espécie de metáfora. A ideia é que, em condições iguais, quanto maior for a probabilidade que uma teoria moral tiver, maior será sua influência na determinação das ações. Mas também pode haver essas trocas entre diferentes teorias morais sobre as quais acho que Toby Ord falou a respeito na apresentação dele. Essa é uma metáfora de como conceber tais características. Pode não ser exatamente a maneira certa de pensar sobre a incerteza normativa fundamental, mas parece estar próximo em muitas situações e parece ser relativamente robusta quanto a ser improvável que tenha uma implicação totalmente maluca.

- Concentre-se mais em objetivos convenientes e de curto prazo. Na medida em que alguém se desespera por ter uma visão coerente sobre como maximizar o bem-estar agregativo nesse contexto cosmológico, maior parece ser a voz efetiva de outros tipos de coisas sobre as quais alguém pode estar refletindo. Então, se você é em parte egoísta e em parte altruísta, se disser que o componente altruísta está nesse tipo de escada de deliberação, então talvez devesse ir mais para a parte egoísta, até que a menos egoísta possa encontrar estabilidade em suas deliberações altruístas.

- Concentre-se em desenvolver nossa capacidade como civilização para deliberar sabiamente sobre esses tipos de coisas. Construir nossa capacidade, em vez de perseguir objetivos muito específicos ― e por capacidade, neste contexto, parece que talvez devêssemos nos concentrar menos em poderes e mais na propensão a usar poderes também. Isso ainda é bastante vago, mas algo nessa direção geral parece ser bastante desejável. Certamente, você poderia ter uma consideração crucial que venha a demonstrar que esse item era a coisa errada a se fazer – mas, ainda assim, esse parece ser um palpite razoável.

É isso. Obrigado.

Esta obra está licenciada sob uma Licença Creative Commons Atribuição 4.0 Internacional.

Publicado originalmente aqui.

–

Tradução: Satia Marini

Revisão: Leo Arruda e Fernando Moreno