Em artigos anteriores, argumentei que há um risco real e grande de que sistemas de IA desenvolvam seus próprios objetivos perigosos e derrotem toda a humanidade — pelo menos na ausência de esforços específicos para impedir que isso aconteça.

Um campo jovem e crescente de pesquisa em segurança da IA tenta reduzir esse risco, encontrando maneiras de garantir que sistemas de IA se comportem conforme o pretendido (em vez de formar objetivos ambiciosos próprios e enganar e manipular humanos conforme necessário para realizá-los).

Talvez consigamos reduzir o risco; talvez não. Infelizmente, acho que pode ser difícil saber qual será o resultado. Este artigo se trata de quatro razões aparentemente distintas para que esse possa ser o caso — e que a segurança da IA possa ser um tipo de ciência difícil num nível incomum.

Este artigo se direciona a um público amplo, porque acho importante que os desafios aqui sejam amplamente compreendidos. Minha expectativa é que sistemas de IA poderosos e perigosos tenham muitos benefícios (comerciais, militares, etc) e potencialmente pareçam mais seguro do que são — logo, penso que será difícil sermos tão cautelosos sobre isso quanto deveríamos ser. Acho que nossas chances parecerão melhores se muitas pessoas entenderem, num nível abstrato, alguns dos desafios de determinar se sistemas de IA são tão seguros quanto parecem.

Primeiro, irei recapitular o desafio básico da pesquisa em segurança da IA e descrever como eu gostaria que a pesquisa de segurança da IA fosse. Eu gostaria que tivesse esta forma básica: “Aplique um teste ao sistema de IA. Se ele for mal no teste, tente outro método de desenvolvimento de IA e teste-o. Se ele for bem no teste, devemos estar bem.” Acho que a pesquisa em segurança automotiva em grande parte se parece assim; acho que a pesquisa em capacidades de IA em grande parte se parece assim.

Em seguida, darei quatro razões pelas quais o aparente sucesso na segurança da IA pode ser enganoso.

| “Ótimas notícias: testei esta IA e parece segura.” Por que ainda podemos ter um problema? | ||

| Problema | Questão-chave | Explicação |

| O problema de Lance Armstrong | Conseguimos que a IA seja realmente segura ou boa em esconder suas ações perigosas ? | Ao lidar com um agente inteligente, é difícil determinar a diferença entre “comportar-se bem” e “parecer comportar-se bem”. Quando o ciclismo profissional estava combatendo as drogas de melhoria do desempenho, Lance Armstrong teve muito sucesso e parecia estar extraordinariamente “limpo”. Mais tarde, descobriu-se que ele estava usando drogas com uma operação extraordinariamente sofisticada para escondê-las. |

| O problema do Rei Lear | A IA é (efetivamente) bem-comportada quando os humanos estão no controle. Isso será transferido para quando as IAs estiverem no controle ? | É difícil saber como alguém se comportará quando tiver poder sobre você, com base apenas na observação de como se comporta quando não tem. Pode ser que IAs se comportem conforme o pretendido desde que os humanos estejam no controle, mas, em algum momento futuro, elas sejam capazes o suficiente e estejam disseminadas o suficiente para ter oportunidades de assumir o controle do mundo inteiramente. É difícil saber se elas aproveitarão essas oportunidades e não é que possamos fazer um teste limpo da situação exatamente. É como o Rei Lear ao tentar decidir quanto poder dar a cada uma de suas filhas antes de abdicar do trono. |

| O problema dos ratos de laboratório | As IAs “subumanas” de hoje são seguras. E as futuras IAs com capacidades mais humanoides ? | Os sistemas de IA atuais não são avançados o suficiente para exibir os comportamentos básicos que queremos estudar, como enganar e manipular humanos. É como tentar estudar medicina em humanos fazendo experimentos apenas em ratos de laboratório. |

| O problema do primeiro contato | Imagine que as IAs “humanoides” de amanhã sejam seguras. Como serão as coisas quando as IAs tiverem capacidades muito além das dos humanos ? | Sistemas de IA podem (coletivamente) se tornar muito mais capazes do que os humanos, e é… simplesmente muito difícil ter alguma ideia de como isso vai ser. Pelo que sabemos, nunca houve nada na galáxia que seja muito mais capaz do que os humanos nas formas relevantes! Não importa o que inventemos para resolver os três primeiros problemas, não podemos ter muita confiança de que continuará funcionando se a IA avançar (ou apenas proliferar) muito mais. É como tentar planejar o primeiro contato com extraterrestres (isso mal parece uma analogia). |

Encerrarei com a analogia do “jovem empresário” de Ajeya Cotra, que, em certo sentido, reúne essas preocupações. Um artigo futuro discutirá sobre algumas razões para ter esperança, apesar desses problemas.

Índice

Recapitulando o desafio básico

Um artigo anterior expôs a defesa básica para nos preocuparmos com o desalinhamento da IA. Resumindo: se sistemas de IA extremamente capazes forem desenvolvidos usando métodos como os que os desenvolvedores de IA usam hoje, parece haver um risco substancial de que:

- essas IAs desenvolvam objetivos não pretendidos (estados do mundo em direção aos quais elas fazem cálculos e planos, como um enxadrista de IA “mira” o xeque-mate);

- essas IAs enganem, manipulem e dominem os humanos conforme necessário para atingir esses objetivos;

- e isso possa acabar chegando ao ponto em que IAs tomam o controle do mundo dos humanos inteiramente.

Vejo a pesquisa em segurança da IA como uma tentativa de projetar sistemas de IA que não visem enganar, manipular ou derrotar os humanos — mesmo se e quando esses sistemas de IA forem extraordinariamente capazes (e seriam muito eficazes em enganar/manipular/derrotar se visassem isso). Ou seja, a pesquisa em segurança da IA está tentando reduzir o risco do cenário acima, mesmo que (como eu presumi) os humanos se apressem em treinar IAs poderosas para fazer coisas cada vez mais ambiciosas.

N.T.: os blocos de texto são de leitura opcional para contextualização:

| Mais detalhes sobre por que a IA pode tornar este o século mais importante: Em O Século Mais Importante, argumentei que o século XXI pode ser o século mais importante de todos os tempos para a humanidade, por meio do desenvolvimento de sistemas avançados de IA que podem acelerar drasticamente o avanço científico e tecnológico, levando-nos mais rápido do que a maioria das pessoas imagina a um futuro profundamente estranho. Esta página tem um resumo de mais ou menos 10 páginas da série, assim como links para uma versão em áudio, podcasts e a série completa. Os pontos-chave que defendo na série são: – O futuro de longo prazo é radicalmente desconhecido. Avanços suficientes na tecnologia podem levar a uma civilização duradoura de escala galáctica que pode ser uma utopia radical, uma distopia radical ou qualquer coisa entre os dois cenários. – O futuro a longo prazo pode vir muito mais rápido do que pensamos, devido a uma possível explosão de produtividade impulsionada pela IA. – O tipo relevante de IA parece que será desenvolvido neste século — tornando este século aquele que iniciará e terá a oportunidade de moldar uma futura civilização de escala galáctica. – Essas alegações parecem muito “extravagantes” para levarmos a sério. Mas há muitas razões para pensar que vivemos numa época extravagante e que devemos estar prontos para tudo. – Nós, as pessoas vivendo neste século, temos a chance de causar um grande impacto num grande número de pessoas por vir — se pudermos entender a situação o suficiente para encontrar ações úteis. Mas, neste momento, não estamos prontos para isso. |

| Por que a IA “visaria” derrotar a humanidade? Um artigo anterior argumentou que, se os métodos de desenvolvimento de IA atuais levarem diretamente a sistemas de IA potentes o suficiente, desastres são prováveis por padrão (na ausência de contramedidas específicas). Em suma: – O desenvolvimento moderno de IAs é essencialmente baseado em “treinamento” por tentativa e erro. – Se avançarmos sem cautela e com ambição nesse treinamento, e se ele nos levar até sistemas de IA muito potentes, esses sistemas provavelmente acabarão visando certos estados do mundo (de forma análoga a como uma IA-enxadrista visa o xeque-mate). – E esses estados serão diferentes daqueles que pretendemos, porque nossos métodos de treinamento por tentativa e erro não serão corretos. Por exemplo, quando estamos confusos ou mal informados sobre alguma questão, recompensamos sistemas de IA por darem a resposta errada a ela — treinando, sem intenção, um comportamento enganoso. – Devemos esperar um desastre se tivermos sistemas de IA que (a) sejam potentes o suficiente para derrotar os humanos e (b) visem estados do mundo que não pretendemos. (“Derrota” significa assumir o controle do mundo e fazer o que for necessário para nos manter fora do caminho; não está claro para mim se seríamos literalmente mortos ou apenas impedidos à força1 de mudar o mundo de maneiras que contradizem os objetivos dos sistemas de IA). |

| Como a IA poderia derrotar a humanidade? Em um artigo anterior, defendo que sistemas de IA poderiam derrotar toda a humanidade em conjunto, se (por qualquer motivo) visassem esse objetivo. Por derrotar a humanidade, quero dizer ganhar o controle do mundo para que IAs, não os humanos, determinem o que acontece nele; isso pode envolver matar humanos ou simplesmente nos “conter” de alguma forma, de modo que não possamos interferir nos objetivos das IAs. Uma maneira de isso acontecer é se a IA se tornasse extremamente avançada, a ponto de ter “superpoderes cognitivos” além do que os humanos podem fazer. Nesse caso, um único sistema de IA (ou um conjunto de sistemas trabalhando juntos) poderia concebivelmente: – Fazer sua própria pesquisa sobre como construir um sistema de IA melhor, que culmine em algo que possui outras capacidades incríveis. – Hackear softwares criados por humanos pelo mundo. – Manipular a psicologia humana. – Gerar rapidamente uma vasta riqueza sob o controle dele mesmo ou de qualquer aliado humano. – Elaborar planos melhores do que os humanos podem imaginar e garantir que não faça nenhuma tentativa de tomada de controle que humanos possam detectar e impedir. – Desenvolver armamentos avançados que possam ser construídos de forma rápida e barata, mas poderosos o suficiente para dominar as forças armadas humanas. No entanto, meu artigo também investiga como as coisas poderiam se parecer se cada sistema de IA basicamente tivesse capacidades semelhantes às humanas. Nesse caso: – É provável que os humanos implementem sistemas de IA em toda a economia, de modo que sejam numerosos e tenham grande acesso a muitos recursos — e a capacidade de fazer cópias de si mesmos. – A partir desse ponto de partida, os sistemas de IA com capacidades humanoides (ou superiores) teriam várias maneiras possíveis de chegar ao ponto em que sua população total superasse os humanos em termos de números e recursos. – Eu lido com uma série de objeções possíveis, como “Como IAs podem ser perigosas sem corpos?” Mais: A IA poderia derrotar todos nós em conjunto |

Quem dera a pesquisa em segurança da IA fosse simples

Quem dera a pesquisa em segurança da IA fosse como a pesquisa em segurança automotiva2.

Embora eu tenha certeza de que isso é simplificar demais, acho que muitas pesquisas em segurança automotiva são basicamente assim:

- As empresas realizam colisões de teste com carros de teste. Os resultados fornecem uma indicação muito boa (não perfeita) do que aconteceria numa colisão real.

- Os motoristas tentam dirigir os carros em áreas de baixo risco sem muito trânsito. Coisas como mau funcionamento do volante provavelmente aparecerão aqui; se não aparecerem e os motoristas conseguirem dirigir normalmente em áreas de baixo risco, deve ser seguro dirigir o carro no trânsito.

- Nada disso é perfeito, mas o problema ocasional não é, por assim dizer, o fim do mundo. O pior cenário tende a ser um punhado de acidentes, seguidos de um recall e algumas mudanças no design do carro validadas por testes adicionais.

No geral, se tivermos problemas com a segurança do carro, provavelmente seremos capazes de observá-los de maneira relativamente simples em circunstâncias de risco relativamente baixo.

Em aspectos importantes, muitos tipos de pesquisa e desenvolvimento têm esta propriedade básica: podemos observar como as coisas estão indo durante o teste para obter boas evidências sobre como elas se comportarão no mundo real. Outros exemplos incluem pesquisa médica3, pesquisa química4, desenvolvimento de software5, etc.

A maioria das pesquisas em IA também se parece assim. As pessoas podem testar o que um sistema de IA é capaz de fazer de forma confiável (p. ex., traduzir fala para texto), antes de integrá-lo a algum produto comercial de alto risco como a Siri. Isso funciona para garantir que o sistema de IA seja capaz (p. ex., que faça um bom trabalho em suas tarefas) e que seja seguro de certas maneiras (p. ex., se estivermos preocupados com linguagem tóxica, testar isso é relativamente simples).

O restante deste artigo será sobre algumas das maneiras como os “testes” de segurança da IA não nos fornecem observações simples sobre se, quando os sistemas de IA estiverem implementados no mundo real, o mundo será realmente seguro.

Embora toda pesquisa tenha que lidar com algumas diferenças entre os testes e o mundo real, acho que os desafios que apresentarei são incomuns.

Quatro problemas

(1) O problema de Lance Armstrong: a IA é realmente segura ou boa em esconder suas ações perigosas ?

Primeiro, vamos imaginar que:

- Temos disponíveis sistemas de IA que podem fazer quase tudo que um ser humano pode, com alguns diferentes pontos fortes e fracos, mas sem grandes diferenças em “capacidades ao todo” ou valor econômico por hora de trabalho.

- Estamos observando os primeiros sinais de que sistemas de IA se comportam de maneiras não pretendidas e enganosas, como dar respostas erradas às perguntas que fazemos ou escrever software que falsifica métricas em vez de fazer as coisas que as métricas deveriam medir (p. ex., um software destinado a fazer um site rodar mais rápido pode, em vez de fazer sua função, falsificar as métricas sobre seu tempo de carregamento).

Teorizamos que modificar o treinamento da IA de alguma forma6 tornará sistemas de IA menos propensos a se comportar de forma enganosa. Experimentamos e descobrimos que, de fato, nossos sistemas de IA parecem estar se comportando melhor do que antes: estamos encontrando menos incidentes nos quais eles se comportaram de maneira não pretendida ou enganosa.

Mas isso é apenas uma declaração sobre o que estamos percebendo. Qual das opções a seguir acabou de acontecer?

- Acabamos de treinar nossos sistemas de IA para serem menos enganosos?

- Acabamos de treinar nossos sistemas de IA para serem melhores em enganar e, assim, nos fazer pensar que eles se tornaram menos enganosos?

- Acabamos de treinar nossos sistemas de IA para calcular melhor quando eles podem ser pegos no ato de engano e, portanto, ser menos enganosos apenas quando o engano seria descoberto?

- Este poderia ser útil! Especialmente se formos capazes de configurar sistemas de auditoria em muitas situações do mundo real, de modo que possamos esperar que atos de engano sejam detectados na maior parte do tempo. Mas deixa em aberto o problema do Rei Lear abordado a seguir.

(…Ou alguma combinação dos três?)

Esperamos ser capazes de implementar sistemas de IA em toda a economia, de modo que — assim como especialistas humanos — eles quase certamente terão algumas oportunidades de enganar sem serem pegos. O fato de parecerem honestos em nossos testes não é um conforto claro contra esse risco.

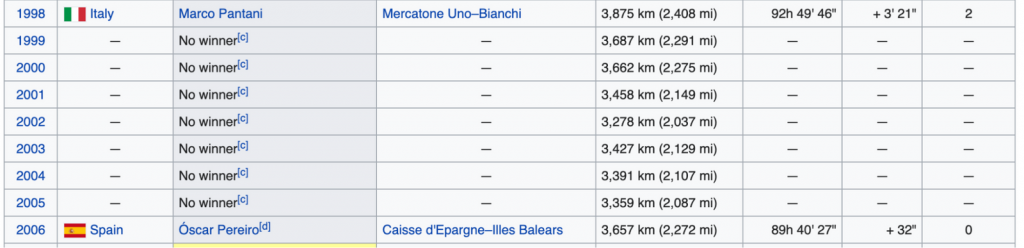

A analogia aqui é com o ciclista competitivo Lance Armstrong. Armstrong venceu a corrida do Tour de France sete vezes consecutivas, enquanto muitos de seus competidores foram pegos usando drogas para melhorar o desempenho e desclassificados. Porém, mais de 5 anos após sua última vitória, uma investigação “concluiu que Armstrong havia usado drogas para melhorar o desempenho ao longo de sua carreira [5] e o nomeou o líder do ‘programa de doping mais sofisticado, profissionalizado e bem-sucedido que o esporte já viu’.” Agora, a lista de vencedores do Tour de France está assim:

Uma questão mais ampla aqui é que, quando sistemas de IA se tornarem capazes o suficiente, a pesquisa em segurança da IA começará a se parecer mais com ciências sociais (estudar seres humanos) do que com ciências naturais. As ciências sociais são geralmente menos rigorosas e mais difíceis de obter resultados claros, e um fator nisso é que pode ser difícil estudar alguém que está ciente de que está sendo estudado7.

Duas amplas categorias de pesquisa que podem ajudar com o problema de Lance Armstrong:

- A interpretabilidade mecanicista8 pode ser considerada a análise dos “cérebros digitais” dos sistemas de IA (não apenas a análise do seu comportamento e desempenho). Atualmente, os sistemas de IA são caixas-pretas no sentido em que executam bem as tarefas, mas não podemos dizer muito sobre como eles estão fazendo isso; a interpretabilidade mecanicista visa mudar isso, o que poderia nos dar a capacidade de “ler a mente” de IAs e detectar enganos. (Ainda pode haver um risco de que os sistemas de IA estejam organizando seus próprios “cérebros digitais” de maneiras enganosas, mas isso parece um pouco mais difícil do que simplesmente comportar-se de maneira enganosa.)

- Alguns pesquisadores trabalham com “supervisão amplificável” ou “supervisão competitiva”. A ideia é que, se estivermos treinando um sistema de IA que pode se tornar enganoso, configuramos algum processo de supervisão para ele que esperamos que detecte confiavelmente qualquer tentativa de engano. Isso pode ocorrer porque o próprio processo de supervisão usa sistemas de IA com mais recursos do que aquele sendo supervisionado ou porque usa um sistema de auditorias aleatórias em que é feito um esforço extra para detectar engano.

| Por que os sistemas de IA são “caixas-pretas” cujo funcionamento interno não conseguimos entender? Explico isso brevemente num post antigo do Cold Takes; é explicado com mais detalhes em artigos mais técnicos de Ajeya Cotra (seção I linkada) e Richard Ngo (seção 2). O que quero dizer com “tentativa e erro de caixa-preta” é explicado brevemente numa postagem antiga do Cold Takes e com mais detalhes em artigos mais técnicos de Ajeya Cotra (seção I linkada) e Richard Ngo (seção 2). Aqui uma caracterização rápida e simplificada: Hoje, a maneira mais comum de construir um sistema de IA é usando uma “rede neural artificial” (RNA), que você pode pensar como um “cérebro digital” que começa num estado vazio (ou aleatório): ele ainda não foi programado para fazer coisas específicas. Um processo mais ou menos assim é seguido: – O sistema de IA recebe algum tipo de tarefa. – O sistema de IA tenta algo, inicialmente algo bastante aleatório. – O sistema de IA obtém informações sobre o desempenho de sua escolha e/ou o que teria obtido um resultado melhor. Com base nisso, ele “aprende” ajustando a fiação da RNA (“cérebro digital”) — literalmente fortalecendo ou enfraquecendo as conexões entre alguns “neurônios artificiais” e outros. Os ajustes fazem com que a RNA forme uma associação mais forte entre a escolha que fez e o resultado obtido. – Após tentativas suficientes, o sistema de IA torna-se bom na tarefa (inicialmente era terrível). – Mas ninguém sabe realmente nada sobre como ou por que ele é bom na tarefa agora. O trabalho de desenvolvimento foi para a construção de uma arquitetura flexível para aprender bem por tentativa e erro e para “treiná-la” fazendo todas as tentativas e erros. Na maioria das vezes, não podemos “olhar dentro do sistema de IA para ver como ele está pensando”. – Por exemplo, se quisermos saber por que uma IA-enxadrista, como o AlphaZero, fez uma determinada jogada de xadrez, não podemos olhar dentro de seu código para encontrar ideias como “Controlar o centro do tabuleiro” ou “Tentar não perder minha rainha.” A maior parte do que vemos é apenas um vasto conjunto de números, denotando a força das conexões entre diferentes neurônios artificiais. Assim como no cérebro humano, podemos apenas conjecturar sobre o que as diferentes partes do “cérebro digital” estão fazendo. |

2) O problema do Rei Lear: como você testa o que acontecerá quando não for mais um teste?

A peça de Shakespeare Rei Lear começa com o rei (Lear) descendo do trono e imediatamente sabendo que deixou seu reino para as duas filhas erradas. Amorosas e obsequiosas enquanto ele decidia o seu destino9, elas revelam seu desprezo por ele assim que ele perde o poder e elas o ganham.

Se estamos construindo sistemas de IA que podem raciocinar como humanos, dinâmicas como essa se tornam um problema em potencial.

Observei anteriormente que uma IA com qualquer objetivo ambicioso — ou simplemente uma IA que deseje evitar ser desligada ou modificada — pode calcular que a melhor maneira de fazer isso é comportar-se de maneira prestativa e segura em todos os “testes” que os humanos podem elaborar. Mas, uma vez que haja uma oportunidade no mundo real de debilitar os humanos de vez, esse mesmo objetivo pode fazer com que a IA debilite os humanos.

Em outras palavras:

- (A) Quando estamos desenvolvendo e testando sistemas de IA, temos o poder de decidir quais sistemas serão modificados ou desativados e quais serão implementados no mundo real. (Como o Rei Lear decidindo quem herdará seu reino).

- (B) Mas, em algum momento posterior, esses sistemas podem estar operando na economia, em grande número e com muita autonomia. (Essa possibilidade é explicada/visualizada um pouco mais aqui e aqui). Nesse ponto, eles podem ter oportunidades de derrotar toda a humanidade de forma que nunca mais tomemos decisões sobre eles (como as filhas do Rei Lear depois de assumirem o controle).

Se os sistemas de IA puderem detectar a diferença entre (A) e (B) acima, seu comportamento poderá mudar sistematicamente de um para o outro — e não há uma maneira clara de testar seu comportamento em (B).

| O escândalo das emissões da Volkswagen Em 2015, a Agência de Proteção Ambiental dos EUA “descobriu que a Volkswagen havia programado intencionalmente (…) motores para ativar seus controles de emissões apenas durante testes de emissões em laboratório, o que fez com que a produção de [óxido de nitrogênio] dos veículos satisfizesse os padrões dos EUA durante os testes regulamentares. No entanto, os veículos emitiam até 40 vezes mais [óxido de nitrogênio] ao serem dirigidos no mundo real”. (da Wikipédia). Esse é um exemplo do “problema do Rei Lear”: foi feita uma distinção deliberada na qual os motores se comportavam de maneira diferente durante os testes e durante o uso no mundo real. Não sei muito sobre esse incidente, mas suponho que os reguladores tenham sido capazes de detectar o problema por causa de (a) testes independentes em condições da estrada; (b) porque puderam entender o “dispositivo manipulador” que os carros da Volkswagen usavam para criar as leituras enganosas. Nenhuma dessas coisas se aplicaria necessariamente ao problema do Rei Lear conforme descrito aqui: (a) você pode testar um carro em condições de estrada para ver suas emissões, mas não pode (ou pelo menos não deveria) testar como uma IA se comporta quando tem a oportunidade de debilitar completamente os humanos; (b) sistemas de IA podem ser caixas-pretas tais que seja difícil entender o que está acontecendo dentro delas. |

Em geral, os pesquisadores modernos de aprendizado de máquina consideram desafiador lidar com o que é chamado de “desvio distributivo”: diferenças sistemáticas entre as situações nas quais IAs foram treinadas e as situações nas quais estão agora. Para mim, o problema do Rei Lear parece ser provavelmente o desvio distributivo mais inconveniente: sistemas de IA correm o risco de se comportar de maneiras inesperadas só enquanto (e, de fato, porque) agora são capazes de derrotar a humanidade, e não estão num ambiente de teste controlado.

Algumas linhas de pesquisa que podem ajudar aqui:

- Se pudéssemos resolver o problema de Lance Armstrong de forma resiliente o suficiente — de modo que pudéssemos ter certeza de que as IAs nunca se comportariam de maneira enganosa — poderíamos simplesmente pedir que as IAs respondessem a perguntas como “O sistema de IA x debilitaria os humanos se tivesse a oportunidade de fazer isso?” É concebível que as técnicas baseadas em cérebro digital mencionadas acima poderiam nos trazer até aqui.

- Pode haver maneiras de tentar atacar especificamente o comportamento de pior cenário dos sistemas de IA, de modo que seja quase garantido que eles não se comportem de determinadas maneiras, não importa a sua situação. Isso pode parecer mais ou menos como “simular casos em que um sistema de IA tem a oportunidade de debilitar os humanos e dar a ele um reforço negativo por escolher fazer isso”. Mais informações sobre esse tipo de abordagem, juntamente com alguns trabalhos preliminares em andamento, aqui.

(3) O problema dos ratos de laboratório: os sistemas de IA que gostaríamos de estudar não existem hoje

Acima, eu disse: “quando sistemas de IA se tornam capazes o suficiente, a pesquisa em segurança da IA começa a se parecer mais com ciências sociais (estudar seres humanos) do que com ciências naturais”. Mas, hoje, os sistemas de IA não são capazes o suficiente, o que torna especialmente difícil ter uma plataforma de teste que faça sentido e fazer avanços que façam sentido.

Em específico, não temos muitas coisas parecidas com sistemas de IA que pareçam enganar e manipular seus supervisores10, da maneira como me preocupo que eles possam fazer quando se tornarem capazes o suficiente.

De fato, não está 100% claro que os sistemas de IA possam aprender a enganar e manipular os supervisores, mesmo que tentemos deliberadamente treiná-los para isso. Isso torna difícil até mesmo começar coisas como desestimular e detectar comportamentos enganosos.

Acho que a pesquisa em segurança da IA é um pouco incomum com respeito a isso: a maioria dos campos de pesquisa não se trata explicitamente de “resolver problemas que ainda não existem”. (Embora muitas pesquisas acabem sendo úteis para problemas mais importantes do que os originais que estão estudando.) Como resultado, fazer pesquisas em segurança da IA atualmente é um pouco como tentar estudar medicina em humanos fazendo experimentos apenas em ratos de laboratório (sem cobaias humanas disponíveis).

Isso não significa que não haja pesquisas produtivas em segurança da IA a serem feitas! (Veja as seções anteriores.) Significa apenas que a pesquisa que está sendo feita hoje é um pouco análoga à pesquisa com ratos de laboratório: informativa e importante até certo ponto, mas apenas até certo ponto.

Quão ruim é este problema? Assim… acho que ele é temporário: quando estivermos enfrentando os problemas que me preocupam, poderemos estudá-los mais diretamente. A preocupação é que as coisas podem estar se movendo muito rapidamente nesse ponto: quando tivermos IAs com capacidades humanoides, as empresas podem estar furiosamente fazendo cópias dessas IAs e usando-as para todo tipo de coisa (incluindo pesquisa em segurança da IA e mais pesquisas sobre como tornar os sistemas de IA mais rápidos, mais baratos e mais capazes).

Então, eu me preocupo, sim, com o problema dos ratos de laboratório. E eu ficaria empolgado em ver mais esforços para criar “melhores organismos-modelo”: sistemas de IA que mostram versões iniciais das propriedades que mais gostaríamos de estudar, como enganar seus supervisores. (Eu até acho que valeria a pena treinar AIs especificamente para fazer isso11; se tais comportamentos acabarão surgindo, acho melhor que surjam cedo, enquanto há relativamente pouco risco de IAs realmente derrotarem a humanidade).

(4) O problema do “primeiro contato”: como nos preparamos para um mundo onde as IAs têm capacidades muito além das dos humanos?

Tudo isso até agora tem se tratado de tentar criar sistemas de IA “humanoides” seguros.

Que dizer de sistemas de IA com capacidades muito além das dos humanos — o que Nick Bostrom chama de sistemas de IA superinteligentes?

Talvez, em algum momento, sistemas de IA sejam capazes de fazer coisas como:

- Coordenar-se incrivelmente bem, de modo que seja inútil usar uma IA para ajudar a supervisionar outra.

- Entender perfeitamente o pensamento e o comportamento humano e saber exatamente quais palavras dizer para conseguir que façamos o que eles querem — de modo que simplesmente permitir que uma IA envie e-mails ou escreva tuítes dá a ela um vasto poder sobre o mundo.

- Manipular seus próprios “cérebros digitais”, de modo que nossas tentativas de “ler suas mentes” saem pela culatra e nos enganam.

- Raciocinar sobre o mundo (ou seja, fazer planos para atingir seus objetivos) de maneiras completamente diferentes das dos humanos, com conceitos como “glooble”12 que são formas incrivelmente úteis de pensar sobre o mundo, mas que os humanos não conseguiriam entender com séculos de esforço.

Neste ponto, quaisquer métodos que desenvolvermos para tornar sistemas de IA humanoides seguros, honestos e limitados podem falhar — e de modo silencioso, visto que tais sistemas de IA podem ir de “comportarem-se de maneira honesta e prestativa” para “parecerem honestos e prestativos, enquanto criam oportunidades para derrotar a humanidade“.

Algumas pessoas acham que esse tipo de preocupação com sistemas “superinteligentes” é ridículo; algumas13 parecem considerá-lo extremamente provável. Pessoalmente, não tenho simpatia por ter alta confiança sobre um lado nem outro.

Mas, além disso, um mundo com um grande número de sistemas de IA humanoides poderia ser estranho, alienígena e rápido o suficiente para ter muito dessa qualidade.

Tentar se preparar para futuros como esse pode ser como tentar se preparar para o primeiro contato com extraterrestres: é difícil ter alguma ideia de com que tipos de desafios podemos lidar, e os desafios podem surgir rápido o suficiente para que tenhamos pouco tempo para aprender e nos adaptar.

O jovem empresário

Para mais uma analogia, retornarei àquela usada por Ajeya Cotra aqui :

Imagine que você seja uma criança de oito anos cujos pais lhe deixaram uma empresa de US$ 1 trilhão e nenhum adulto de confiança para servir como seu guia para o mundo. Você deve contratar um adulto inteligente para administrar sua empresa como diretor-executivo, lidar com sua vida como um pai faria (p. ex., escolher sua escola, onde você vai morar, quando precisa ir ao dentista) e administrar sua vasta riqueza (p. ex., decidir onde você investirá seu dinheiro).

Você tem que contratar esses adultos com base em um teste ou entrevista de emprego que você elaborar — você não pode ver currículo nenhum, não pode verificar referências, etc. Porque você é tão rico, uma montoeira de pessoas se candidata por todo tipo de razões. (Mais)

Se seus candidatos são uma mistura de “santos” (pessoas que querem genuinamente ajudar), “puxa-sacos” (pessoas que só querem fazer você feliz no curto prazo, mesmo quando isso lhe é prejudicial a longo prazo) e “maquinadores” (pessoas que querem desviar sua riqueza e poder para si mesmas), como você — uma criança de oito anos — percebe a diferença?

Essa analogia combina a maioria das preocupações acima.

- O jovem empresário tem dificuldade em saber se os candidatos são verazes nas entrevistas e tem dificuldade em saber se algum teste de emprego efetivamente correu bem ou apenas pareceu correr bem devido a um engano deliberado. (O problema de Lance Armstrong).

- Os candidatos a emprego podem ter más intenções que não se amostram até que estejam no poder (o problema do Rei Lear).

- Se o jovem empresário estivesse tentando se preparar para essa situação antes de efetivamente assumir o comando da empresa, poderia ter muita dificuldade em simular a situação (o problema dos ratos de laboratório).

- E geralmente é simplesmente difícil para uma criança de oito anos ter muita compreensão sobre o mundo dos adultos — até mesmo pensar em todas as coisas em que deveria estar pensando (o problema do primeiro contato).

Parece uma situação difícil.

Anteriormente, falei sobre os perigos da IA se os desenvolvedores de IA não tomarem contramedidas específicas. Este artigo tentou dar uma ideia de por que, mesmo que eles estejam tentando tomar contramedidas, fazer isso pode ser difícil. O próximo artigo falará sobre algumas maneiras como podemos ter sucesso mesmo assim.

Notas de rodapé

1. Ou persuadido (no sentido de “hackear a mente”) ou o que for.

2. Pesquisa? Teste. O que for.

3. As drogas podem ser testadas in vitro, depois em animais e depois em humanos. Em cada estágio, podemos fazer observações relativamente simples sobre se as drogas estão funcionando, e elas preveem razoavelmente como as drogas se sairão no estágio seguinte.

4. Geralmente, você pode ver como diferentes compostos interagem em um ambiente controlado, antes de lançar qualquer tipo de processo ou produto em larga escala, e a primeira situação lhe dirá a maior parte do que você precisa saber sobre a segunda.

5. Um novo software pode ser testado por um pequeno número de usuários antes de ser distribuído para um grande número, e os testes iniciais provavelmente encontrarão a maioria (não todas) das falhas e panes.

6. Como:

- Ser mais cuidadosos para evitar respostas erradas que podem incentivar o engano

- Fazer “auditorias” aleatórias nas quais nos esforçamos ao máximo para descobrir a resposta certa para uma pergunta e damos um reforço negativo extra a uma IA se ela der uma resposta em que teríamos acreditado se não fosse pela auditoria (isso é “reforço negativo extra para respostas erradas que superficialmente parecem certas”)

- Usar métodos como “Segurança da IA via debate”

7. Embora haja outras razões pelas quais as ciências sociais são especialmente difíceis, como o fato de que muitas vezes há grandes limites éticos sobre alguns tipos de experimentos e o fato de que muitas vezes é difícil fazer comparações puras entre diferentes populações.

8. Este artigo é da Anthropic, uma empresa da qual minha esposa é presidente.

9. Tipo, ele realmente pede que elas falem do seu amor por ele logo antes de decidir que parte do reino elas receberão. Lamentável.

10. Este artigo é um exemplo em potencial, mas seus resultados parecem bastante frágeis.

11. P. ex. acho que seria interessante treinar sistemas de codificação de IA para escrever um código C: dissimulado que parece benigno para um inspetor humano, mas faz coisas inesperadas quando executado. Eles podem receber reforço negativo quando humanos conseguem identificar corretamente que o código fará coisas não pretendidas e reforço positivo quando o código alcança as coisas específicas que os humanos estão tentando impedir. Isso seria desafiador com os sistemas de IA atuais, mas não necessariamente impossível.

12. Esse é um conceito que só eu entendo.

13. P. ex., veja a discussão sobre a “curva brusca à esquerda” aqui por Nate Soares, diretor do MIRI. Minha impressão é que outros no MIRI, incluindo Eliezer Yudkowsky, têm uma imagem semelhante.

Publicado originalmente em 8 de dezembro de 2022 aqui.

Autor: Holden Karnofsky

Tradução: Luan Marques