Índice

A Ampla Comunidade de Combustíveis Fósseis

Imagine se as empresas petrolíferas e os ativistas ambientais fossem considerados parte da ampla “comunidade de combustíveis fósseis”. Exxon e Shell atuariam na área de “produção de combustível fóssil”; Greenpeace e Sierra Club atuariam na área de “segurança de combustível fóssil” – duas partes igualmente amadas da rica e diversificada comunidade de trabalho relacionado a combustíveis fósseis. Todos iriam às mesmas festas – festas da “comunidade de combustíveis fósseis” – e talvez Greta Thunberg se cansasse de protestar contra as mudanças climáticas e se tornasse uma baronesa do carvão.

É assim que a segurança da Inteligência Artificial (IA) funciona hoje. O trabalho de produção de IA – pesquisar uma IA maior e melhor – é pouco diferenciado do trabalho de segurança da IA - impedir que a IA se torne perigosa. Duas das maiores equipes de segurança de IA estão na DeepMind e na OpenAI, ou seja, as duas maiores empresas de “produção” de IA. Alguns laboratórios inclusive trabalham nos dois lados do muro, entre produção e pesquisa de segurança.

Provavelmente as pessoas da DeepMind e OpenAI acham que isso faz sentido. Construir IAs e alinhar IAs podem ser objetivos complementares, tal como construir aviões e evitar que os aviões caiam. Parece superficialmente plausível.

Mas muitas pessoas trabalhando na segurança da IA acreditam que uma IA não alinhada (aos interesses humanos) pode acabar com o mundo, que ainda não sabemos como alinhar a IA e que nossa melhor chance é atrasar o desenvolvimento de uma IA superinteligente até que saibamos como fazer isso. Trabalhar ativamente no avanço da IA parece ser o oposto desse plano.

Então, talvez (o argumento continua) devêssemos seguir a sugestão dos ativistas ambientais e ser hostis em relação às empresas de IA. Nada violento ou ilegal – fazer coisas violentas e ilegais é a melhor maneira de perder 100% do seu apoio imediatamente. Mas talvez começar a olhar um pouco feio para seu amigo que faz pesquisa de recursos de IA, em vez de apenas ficar empolgado com o quão legal é seu novo projeto. Ou começar alguma forma de ativismo pela regulamentação governamental da IA - seja porque você confia no governo para regular com sabedoria, ou porque, pelo menos, espera que o governo crie regras onerosas que prejudiquem o setor. Embora existam fartos exemplos de falhas regulatórias governamentais, algumas regulamentações – tal como a proibição da União Europeia aos Transgênicos ou as restrições dos EUA à energia nuclear – efetivamente pararam suas respectivas indústrias.

Esta é a pergunta mais comum que recebo nas postagens de segurança da IA: por que o movimento de segurança racionalista / Altruísta Eficaz / IA não está fazendo mais desse tipo de ativismo? Essa é uma ótima pergunta, e é uma que o movimento se faz muito – veja, por exemplo, o Qual seria a cara de uma estratégia de contenção de IA realmente pessimista e desacelerar o progresso da IA é uma estratégia de alinhamento pouco explorada.

Ainda assim, a maioria das pessoas não está fazendo isso. Por que não?

Não, não vamos parar de nos bater

Primeiro, uma lição de história: as melhores empresas de produção de IA foram fundadas por defensores da segurança da IA, por motivos relacionados à segurança da IA.

A DeepMind foi cofundada por Shane Legg, um dos primeiros defensores da segurança da IA que fez sua tese de doutorado em superinteligência em 2007

…e por Demis Hassabis, que disse coisas como:

Eu sempre imagino que, à medida que nos aproximamos da [superinteligência], a melhor coisa a fazer pode ser pausar a busca por ganhos de desempenho desses sistemas para que você os possa analisar nos mínimos detalhes, com exatidão, e talvez até provar matematicamente coisas sobre esse sistema, de modo que você conheça os limites e capacidades dos sistemas que está construindo. Neste momento, acho que todas as maiores mentes do mundo provavelmente deveriam estar pensando sobre esse problema. Então é isso que eu estaria defendendo, fale com os Terence Tao‘s deste mundo, os melhores matemáticos. Na verdade eu até conversei com ele sobre isso – eu sei que você está trabalhando na hipótese de Riemann ou algo que é tido como a melhor coisa em matemática, mas na verdade a IA é mais urgente.

Especulativamente, a DeepMind esperava reunir todos os talentos de IA em um só lugar, liderados por pessoas preocupadas com a segurança, para que pudessem verificar as coisas à vontade, em vez de todos competirem uns contra os outros para serem os primeiros. Não sei se esses altos ideais ainda têm algum poder; a controladora corporativa da DeepMind, Google, tem se ocupado em despojá-los de autonomia.

OpenAI é a empresa por trás do GPT-3 e DALL-E. A mídia os apresentou com a seguinte reportagem: Elon Musk acaba de fundar uma nova empresa para garantir que a inteligência artificial não destrua o mundo. O mesmo artigo cita o co-fundador e atual CEO da OpenAI, Sam Altman, dizendo que “a IA provavelmente levará ao fim do mundo, mas enquanto isso não ocorre, surgirão grandes empresas”. A declaração pública da OpenAI sobre sua própria fundação disse:

É difícil imaginar o quanto a IA de nível humano poderia beneficiar a sociedade, e é igualmente difícil imaginar o quanto ela poderia prejudicar a sociedade se construída ou usada incorretamente.

Mas eles não podem usar o argumento de “estamos tentando evitar uma corrida” – sua criação provavelmente iniciou uma corrida (contra o DeepMind). Então, o que eles tinham em mente? Eu ainda não entendi essa parte completamente, mas aqui está a explicação do próprio Altman:

Toby Ord (aqui representando a comunidade mais ampla de quantificação de risco existencial) estimou o risco de impactos de asteroides com capacidade de extinguir a humanidade em 0,0001% por século, e o risco de extinção pela construção muito rápida de uma IA como sendo 10%. Tal como escrito, o argumento de Sam não é muito bom. Mas você poderia revisá-lo para ser sobre “asteroides” metafóricos, tal como superpragas ou guerra nuclear. Altman também expressou preocupação com o fato de a IA causar desigualdade, por exemplo, se as pessoas ricas a usarem para substituir todo o trabalho e colher todos os ganhos para si mesmas. A OpenAI foi originalmente fundada como uma organização sem fins lucrativos, de modo que deveria proteger contra esse risco, então talvez ele tenha pensado que isso tornaria a OpenIA preferível a DeepMind.

(Quanto a Musk, acho que não precisamos de nenhuma explicação mais profunda do que seu padrão habitual de fazer coisas legais por impulso e depois se arrepender quando chega o fim de semana).

A Anthropic foi fundada quando alguns pesquisadores de segurança da OpenAI começaram por conta própria para criar o que eles anunciaram como uma alternativa ainda mais consciente da segurança. Mais uma vez, a manchete era Anthropic levanta US $ 580 milhões para segurança e pesquisa de IA (e a maior parte disso veio de racionalistas e altruístas eficazes convencidos por seu discurso de segurança). Mais uma vez, seu anúncio incluiu uma linguagem tranquilizadora – seu presidente disse que “estamos nos concentrando em garantir que a Anthropic tenha a cultura e a governança para continuar a explorar e desenvolver com responsabilidade sistemas de IA seguros à medida que escalamos”. As pessoas informadas discordam sobre se a Anthropic já se concentrou na construção do Torment Nexus , mas provavelmente é apenas uma questão de tempo.

Por que essa aula de história? Em parte para destacar a profundidade do envolvimento das pessoas de alinhamento de IA aqui. Não é apenas que eles não estão lutando contra empresas de IA, é que eles continuam criando e liderando investimentos nelas. Mas também…

Precisamos falar sobre a corrida*

*No original: “We Need To Talk About Race”. Aqui há um trocadilho com a palavra “race” que em inglês significa tanto corrida como raça. (Nota do Tradutor).

O grande medo das pessoas que trabalham com a regulamentação* da IA é uma “dinâmica de corrida”. Muitas empresas que buscam o lucro (ou governos que buscam o poder) competindo para serem as primeiras a alcançar a Inteligência artificial geral (AGI). Embora eles possam investir em algumas medidas básicas de segurança necessárias para fazer a IA funcionar, eles teriam pouco tempo para se preocupar com preocupações de longo prazo ou mais teóricas.

*No Original: Policy. Optei por regulamentação mas poderia também ter usado governança ou mesmo políticas, no sentido mais próximo à política pública. (Nota do Tradutor).

Muito mais agradável de se contemplar é uma única equipe estabelecendo uma liderança clara. Eles poderiam estudar a questão da segurança em seu próprio ritmo e não precisariam implantar nada até que estivessem confiantes de que funcionaria. Isso seria uma benção não apenas para a prevenção de riscos existenciais, mas para a justiça algorítmica, tomada de decisão transparente, etc. Portanto, seria bom se as equipes líderes continuassem liderando.

Suponha que a comunidade de alinhamento, sem refletir muito a respeito, iniciasse uma campanha no estilo dos ativistas contra o aquecimento global para envergonhar as empresas de produção de IA. Isso prejudicaria desproporcionalmente as empresas mais capazes de se sentirem envergonhadas. No momento, são a DeepMind, OpenAI e Anthropic – as empresas que têm a segurança da IA como parte de sua cultura, polinizam os defensores da segurança da IA com esse tipo de preocupação e levam nossos argumentos a sério.

Se todos esses lugares desacelerassem – ou porque sua liderança viu a luz, ou porque seus funcionários reclamaram e se demitiram – isso entregaria a liderança tecnológica às pessoas logo atrás deles – como Facebook e Salesforce – que se preocupam menos com segurança. Então, o que nós preferimos? A OpenAI obtendo superinteligência em 2040? Ou o Facebook obtendo superinteligência em 2044?

Se a OpenAI alcançar superinteligência em 2040, eles provavelmente estarão dispostos a tentar quaisquer medidas de alinhamento incompletas que os pesquisadores tenham descoberto até então, mesmo que isso acrescente tempo e despesas. Enquanto isso, Mark Zuckerberg diz que, quanto a IA, tudo ficará bem e que alertar as pessoas sobre riscos existenciais é algo “irresponsável”.

(claro, 2040 e 2044 são números inventados. Talvez os números reais sejam 2030 vs. 2060, e esses trinta anos extras significariam uma revolução na tecnologia de alinhamento tão abrangente que até os céticos prestariam atenção…)

Xi-Riscos*

*No original: Xi-risks. Novamente, outro trocadilho, entre o nome do líder da China, Xi Jinping, e os x-risks, uma abreviação comum para os riscos existenciais, ou seja, os riscos que podem causar o fim da humanidade, tal como os riscos trazidos pela Inteligência Artificial (Nota do Tradutor).

Talvez precisemos pensar maior. Poderíamos conseguir que o governo regulamentasse a IA tão fortemente que retarde todas as pesquisas?

Algum tempo antes que a IA se torne um risco existencial, as coisas vão ficar realmente loucas, e pode surgir uma mobilização política crescente para fazer algo, e então, talvez, os proponentes do alinhamento possam se juntar em uma coalizão para retardar a IA. Teríamos que reunir defensores da justiça algorítmica, conservadores anti-tecnologia, sindicatos, libertários anti-vigilância, todos numa mesma casa — de fato, “a política cria estranhos companheiros”.

Ou: e se conseguíssemos colocar as próprias empresas a bordo disso? A grande indústria farmacêutica tem uma relação simbiótica com a FDA (órgão regulatório americano, equivalente a nossa ANVISA); as maiores corporações contratam lobistas e departamentos jurídicos gigantes, depois usam o governo para esmagar as startup concorrentes menos experientes. As regulamentações que se resumiam a “apenas essas três grandes empresas de tecnologia podem pesquisar AGI, e elas precisam fazê-lo muito devagar e com cuidado” satisfariam a comunidade de alinhamento e encantariam as três grandes empresas de tecnologia. Sendo um tipo de libertário, odeio isso; sendo um tipo de utilitarista, se for preciso, vou engolir meu orgulho e seguir em frente.

Ou: e quanto aos limites de algo que não seja a pesquisa? As IAs precisam de muitos dados de treinamento (em alguns casos, toda a Internet). Sempre que publico um artigo aqui, ele entra em algum conjunto de dados que um dia ajudará uma IA a escrever melhores anúncios de pasta de dente. E se eu não quiser que ela faça isso? Os defensores da privacidade já estão fazendo perguntas difíceis sobre a propriedade de dados; esses tipos de regras podem retardar a pesquisa de IA sem ter que atacar as empresas diretamente. Como uma espécie de libertário, odeio iss…blá blá blá a mesma história.

Ou: e os padrões? Instituições apoiadas pelo governo, como NIST e IEEE, desempenham um papel importante na padronização da tecnologia de maneiras que, às vezes, realmente ajudam o setor de tecnologia a avançar de forma mais produtiva em uníssono, por exemplo, com os padrões de criptografia e padrões de wifi. Às vezes, os padrões estabelecidos por um governo “pegam” e se tornam os padrões internacionais. Portanto, fornecer padrões de segurança pode ser uma área em que o apoio do governo realmente aceleraria a implantação de produtos de IA realmente seguros e úteis.

O maior problema é a China. Os regulamentos dos EUA não afetam a China. A China diz que a liderança da IA é a pedra angular de sua segurança nacional – tanto por ser uma grande ajuda ao seu “Estado de Vigilância” como também porque aumentaria seu orgulho nacional se pudessem derrotar os Estados Unidos em uma tecnologia tão de ponta.

Então a verdadeira questão é: o que nós preferimos? A OpenAI obtendo superinteligência em 2040? Ou o Facebook obtendo superinteligência em 2044? Ou a China obtendo superinteligência em 2048?

Podemos ser capazes de chegar a um acordo com a China sobre IA, assim como os países já fizeram acordos de controle de armas ou mudanças climáticas? Isto bem. . . não é tecnicamente impossível pelas leis da física, mas parece muito difícil. Quando eu trago esse desafio para o pessoal que trabalha com regulamentação da IA, eles perguntam “Mais difícil do que o problema técnico de alinhamento da IA?” Ok, tudo bem, vocês ganharam dessa vez.

Cooperar / Desertar*?

*Desertar, ou seja, o abandono do posto de batalha por um militar (Nota do Tradutor)

Outra maneira de pensar sobre essa questão é: agora há uma espécie de aliança entre as empresas de produção e a comunidade de alinhamento. Devemos mantê-lo ou nos voltar contra eles quando menos esperam?

O argumento para manter a aliança: as empresas de produção têm sido muito simpáticas conosco. Muitos têm equipes trabalhando na segurança de IA. Estas não são apenas vitrines. Eles fazem um bom trabalho. As empresas os pagam bem e lhes dão acesso aos modelos mais recentes, porque as empresas gostam de segurança de IA. Se o pessoal da segurança da IA declarar guerra à produção da IA, talvez percamos todas essas coisas.

Mas também: a segurança da IA precisa de pesquisadores de IA. A maioria dos pesquisadores de IA que ainda não estão em segurança de IA são graduandos, estudantes de pós-graduação, acadêmicos ou em projetos de código aberto. No momento, essas pessoas são neutras a positivas em relação à segurança. Se declararmos guerra às empresas de IA – tentando o máximo possível impedir a pesquisa de IA – isso pode prejudicar nossa reputação entre os pesquisadores de IA, que geralmente gostam de pesquisa de IA. E se eles começarem a pensar em nós da mesma forma que os petroleiros do Texas pensam nos ambientalistas – como uma facção hostil, tentando destruir seu modo de vida? Talvez ainda pudéssemos converter alguns em pesquisa de segurança, mas enfrentaríamos ventos contrários bem mais fortes.

E também: talvez as empresas trabalhem conosco em soluções paliativas. Conheço uma equipe tentando fazer com que todos concordem com uma política de segurança comum em torno da publicação de resultados potencialmente perigosos. As empresas estão ouvindo. Se precisarmos de regulamentação e quisermos seguir o caminho da “captura regulatória que passa pela aprovação das empresas”, podemos trabalhar com as empresas para ajudá-las a redigir o texto. Demis Hassabis de vez em quando diz que ele conseguiria desacelerar a DeepMind quando eles estiverem perto da superinteligência; talvez outras empresas amigas possam ser convencidas a trabalhar com ele nessa tarefa.

O argumento para trair a aliança: muito fraco, na verdade. Prejudicaríamos as empresas mais próximas de nós, teríamos mais dificuldade em prejudicar as empresas mais distantes e perderíamos todas as vantagens acima.

O plano é criar um plano

Há um campo em crescimento chamado de regulamentação da IA, tipificado, por exemplo, pelo Centro para a governança da IA , com sede em Oxford, trabalhando em planos para abordar essas questões.

Algumas das pessoas envolvidas são ótimas, e muitas são acadêmicas brilhantes ou servidores públicos que trabalham duro. Mas sempre que pergunto qual é o plano, eles dizem coisas como “Acho que outra pessoa está trabalhando no plano” ou “Talvez o plano seja um segredo”. Eles têm um trabalho muito difícil, há muitas razões para ficarem de boca fechada, e eu respeito tudo o que eles fazem – mas não sinto que este seja um campo que tenha muitos grandes avanços para mostrar.

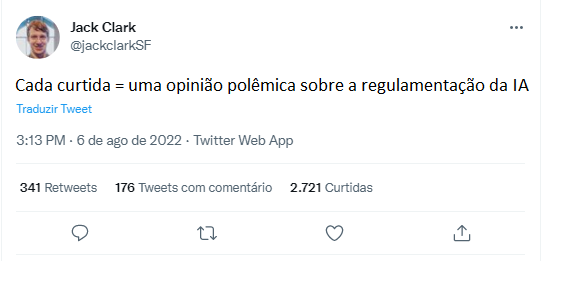

Sua perspectiva é um pouco diferente da minha, mas ele é muito experiente e eu recomendo esse tweet (que você pode ler clicando acima).

Não, não há 1.602 opiniões controvérsias no post.

O fato de um líder da regulamentação da IA não tenha considerado que seu plano se tornaria impraticável em um cenário extremo é provavelmente uma metáfora para algo.

Mas caso esse tema possa lhe interessar, você pode ler no Guia de Carreiras do 80.000 horas sobre como atuar nos problemas de IA e talvez decida trabalhar nele. Se você descobrir o plano, me avise.

Até lá, somos todos membros felizes da Ampla Comunidade de Combustíveis Fósseis.

Tradução: Fernando Moreno

Publicado originalmente por Astral Codex Ten 08 de agosto de 2022 aqui.